Appleが「児童性的虐待資料検出はプライバシーを損なうものではない」とFAQを発表

Appleが2021年8月5日(木)に発表したCSAM(児童性的虐待資料)拡散防止のための試みが、ユーザーのセキュリティやプライバシーを損なうものであると反発を招いています。Appleは改めて「メッセージの中身を見るわけではない」「iCloud写真に保存された写真がCSAMと一致するか検出するのみで、端末のその他のデータをスキャンするわけではない」など、プライバシーを損なう機能ではないことをアピールするFAQを公開しました。

Expanded Protections for Children Frequently Asked Questions

(PDFファイル)https://www.apple.com/child-safety/pdf/Expanded_Protections_for_Children_Frequently_Asked_Questions.pdf

FAQの内容は以下のような感じ。あくまで「よくある質問への回答集」なので、回答の内容に重複する部分が多々登場します。

Q:

「Communication safety in Messages(メッセージアプリの通信の安全性)」と「CSAM detection(iCloud写真でのCSAM検出)」の違いはなんですか?

A:

2つは別の機能で、同じ技術を用いていません。

「Communication safety in Messages」は、「『性的に露骨な画像』を送受信しないようにする保護」を親子に提供することを目的としたもので、ファミリー共有で設定したiMessageアプリで送受信された画像だけが対象となっています。端末上の画像を分析し、子どものアカウントで「性的に露骨な画像」の送受信が確認された場合、写真にぼかしがかかり、子どもには警告が表示されると同時に、写真を見たり送信したりしたくない場合はしなくて大丈夫だと安心させるメッセージが表示されます。追加の予防策として、幼児向けには、安全確認のため、保護者にもメッセージが送信されるオプションも用意されています。

一方、「CSAM detection」は、既存のCSAMに一致するもの以外の写真に関する情報はAppleに提供することなく、CSAMをiCloud Photosから除外するよう設計されています。CSAMの所有はアメリカを含めて多くの国で違法です。CSAM検出機能は、写真をiCloud Photosに保存することを選んだユーザーにのみ影響するもので、iCloud Photosを使用しないユーザーには影響を及ぼしません。「iMessage」には適用されず、端末上の他のデータにも影響はありません。

Q:

「Communication safety in Messages」は誰が利用できますか?

A:

「Communication safety in Messages」はiCloudで家族として設定されているアカウントでのみ使用できます。保護者アカウントで家族グループ機能を有効にする必要があります。保護者への通知は12歳以下の子どもアカウントの保護者のみが有効にできます。

Q:

メッセージの内容がAppleや法執行機関と共有されるということですか?

A:

いいえ、Appleがこの機能により通信内容にアクセスすることはありません。また、「メッセージ」でやりとりされた画像・情報が全米行方不明・搾取児童センター(NCMEC)、法執行機関と共有されることもありません。「Communication safety in Messages」は「CSAM detection」とは独立した機能です。

Q:

「Communication safety in Messages」は「メッセージ」アプリのエンドツーエンド暗号化を破るものですか?

A:

いいえ、「Communication safety in Messages」は「メッセージ」アプリのプライバシー保証に変化をもたらすものではなく、Appleが通信内容にアクセスすることもありません。「メッセージ」のすべてのユーザーは何を誰に送信するか制御できます。この機能が子どものアカウントで有効になっている場合、端末は「メッセージ」アプリで送受信される画像について、「性的に露骨な画像」と判断された場合に介入を行います。12歳以下の子どものアカウントであれば、「性的に露骨な画像」と判断された画像の送信・表示が行われるときに保護者に通知を送信するよう設定できます。Appleは通信・画像評価・介入・通知のいずれも行いません。

Q:

「Communication safety in Messages」は、虐待を受けている家庭の子どもが助けを求めるのを妨げますか?

A:

「Communication safety in Messages」は、メッセージアプリで送受信した「性的に露骨な画像」にだけ適用されます。テキストなど、被害者が助けを求めるために使用する通信には影響はありません。また、我々はSiriと検索で、被害者および被害者の知人に支援を求める方法についてのガイダンスを提供します。

Q:

子どもたちに警告を発したり選択の機会を与えることなく、保護者に通知をするのですか?

A:

いいえ。まず、保護者アカウントで「Communication safety in Messages」を有効にする必要があり、その上で12歳以下の子どものアカウントを対象として、保護者への通知を有効にすることができます。12歳以下の子どものアカウントでは、「性的に露骨な画像」が送受信されるたび、「この画像を表示・送信すると保護者に通知が送られます」という警告が出ます。通知は、警告後になおも画像を表示・送信した場合にだけ送られます。また、13~17歳の子どものアカウントでは、「性的に露骨な画像」を表示・共有するかどうかという警告が本人の端末に表示されますが、保護者への通知は行われません。

Q:

「CSAM detection」は、Appleが私のiPhoneに保存されている画像をすべてスキャンすることを意味するのですか?

A:

いいえ。設計上、「CSAM detection」はユーザーがiCloud写真にアップすると選択した写真にのみ適用されます。その場合でも、Appleは既知のCSAMと一致する画像のみを認識します。iCloud写真を無効化している場合、「CSAM detection」は機能しません。また、「CSAM detection」はプライベートなiPhoneの写真ライブラリに対しても機能しません。

Q:

「CSAM detection」は、私の写真と比較するため、iPhone内にCSAMをダウンロードしますか?

A:

いいえ。CSAMは端末に送信・保存されません。Appleは実際のCSAMではなく、端末上に保存された読み取り不能なハッシュを使用します。ハッシュは既知のCSAMを示す数字の文字列ですが、ハッシュを読み取ったり、もとになったCSAMに変換することはできません。ハッシュリストは、子ども保護団体が取得しCSAMであることを検証した画像に基づいています。Appleは新たな暗号化アプリケーションを使用することで、既知のCSAMと一致する写真を保存しているiCloud写真アカウントのみを検出できます。

Q:

なぜいまAppleが「CSAM detection」を行うのですか?

A:

この分野における重要な課題の1つは、ユーザーのプライバシーを守りながら子どもたちを保護することです。新技術により、Appleは既知のCSAMを保存しているiCloud写真アカウントだけを知ることができます。端末に保存されているその他の画像のことは何も知りません。クラウドに保存されているすべてのユーザーの写真をスキャンしてしまう既存の技術では、すべてのユーザーにプライバシーリスクをもたらします。iCloud写真を対象としたCSAM検出は、既知のCSAMに一致する画像を保存していない限り、Appleがユーザーの写真についての情報を取得しないことによって、プライバシー上の大きなメリットをもたらします。

Q:

CSAM検出技術はCSAM以外の検出にも利用できますか?

A:

そのようなことが起こらないように設計されています。iCloud写真のCSAM検出技術は、あくまでNCMECやその他の団体が提供するCSAMのハッシュでのみ動作するように作られています。このハッシュリストは、子ども保護団体が取得し、CSAMであることを検証した画像に基づいています。AppleはNCMECに報告する前に目視確認を行っており、また、法執行機関への自動通報は行われません。このシステムは「iCloud写真でCSAMであることがわかっている写真のみを報告する」仕組みです。アメリカを含むほとんどの国で、CSAMは所持しているだけで犯罪となるため、Appleは判明した事例を適切な当局に報告する義務があります。

Q:

政府がAppleに、CSAM以外の画像をハッシュリストに加えるよう強制することはできますか?

A:

Appleはそのような要求を一切拒否します。AppleのCSAM検出機能は、iCloud写真に保存された写真の中から、NCMECやその他、子どもの安全に関する団体の専門家によって特定された既知のCSAMを検出するためだけに構築されています。我々はこれまでも、ユーザーのプライバシーを侵害するような政府主導の変更の導入・構築の要求に直面し、それらを断固として拒否してきました。今後も、要求は拒み続けます。はっきりさせておきたいのは、この技術は「iCloud写真に保存されたCSAMの検出」に限定されたものであり、対象を拡大しようとする政府の要求には応じない、ということです。AppleはNCMECに報告する前に目視確認を行っています。システムが既知のCSAMと一致しない写真にフラグを立てた場合、アカウントは無効化されず、NCMECへの報告は行われません。

Q:

CSAM以外の画像をシステムに「注入」して、CSAM以外のことでアカウントにフラグを立てることは可能ですか?

A:

我々のプロセスは、そのようなことが起きないように設計されています。照合に使用されるハッシュリストは、専門家の検証を受けた既知のCSAMのものです。Appleがハッシュを追加することはありません。また、同じハッシュがすべてのiPhone・iPadユーザーのOSに保存されているので、特定の個人を狙った攻撃はできません。最後に、法執行機関への自動報告は行われず、AppleはNCMECに報告する前に人間の目での確認を行っています。万が一、既知のCSAMと一致しない画像がシステムに表示された場合でも、アカウントは無効化されず、NCMECへの報告も行われません。

Q:

iCloud写真のCSAM検出により、法執行機関が無実の人を誤認することはありませんか?

A:

このシステムは非常に正確に設計されており、任意のアカウントに誤ったフラグが立てられる可能性は年間で1兆分の1以下です。さらに、システムによりアカウントにフラグが立てられた場合、AppleはNCMECに報告する前に人間の目で確認を行います。そのため、システムのエラーや「攻撃」により、無実の人がNCMECに報告されることはありません。

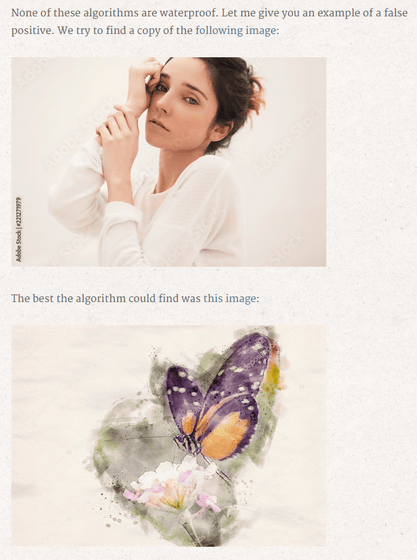

なお、画像の識別にハッシュを用いる方法はAppleのCSAM検出システムが初ではなく、ストックフォト販売サイトでコピー利用の検出にも用いられています。実際にこの技術を用いている会社に属する技術者だというオリバー氏は、Appleのいう「誤検知は年間1兆分の1以下」という数字の根拠が不明で、複数の写真が誤検知される状況が想定されることを指摘しています。

The Problem with Perceptual Hashes

https://rentafounder.com/the-problem-with-perceptual-hashes/

オリバー氏は誤検知の実例として、アルゴリズムが以下の2枚の画像を同一だと認識したという実例を挙げています。

・関連記事

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も - GIGAZINE

Appleが発表した児童の性的搾取を防ぐための「iPhoneの写真やメッセージをスキャンする取り組み」は国ごとの法律にのっとり行われる予定 - GIGAZINE

GoogleがAIを活用してネット上の「児童を搾取する違法なポルノコンテンツ」を自動で見つけ出すツールを開発 - GIGAZINE

・関連コンテンツ