GoogleドライブにAIトレーニングデータをアップロードした開発者が児童性的虐待コンテンツを保存したとしてGoogleアカウントを停止される

スマートフォン向けアプリの開発者がAI用のトレーニングデータをGoogleドライブにアップロードしたところ、GoogleアカウントをBANされてしまうという事態に陥りました。

Developer Accidentally Found CSAM in AI Data. Google Banned Him For It

https://www.404media.co/a-developer-accidentally-found-csam-in-ai-data-google-banned-him-for-it/

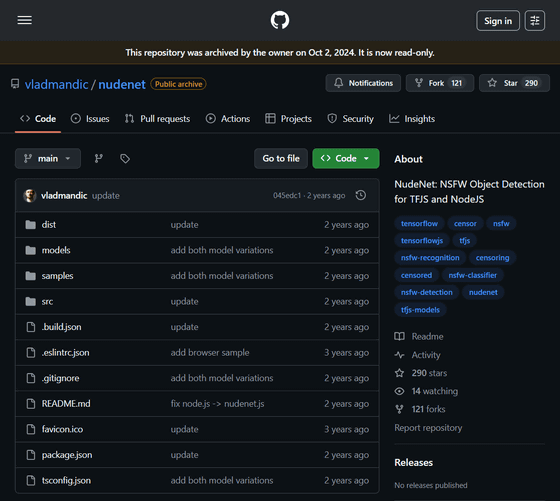

問題となったデータはNSFW検出ツール向けのデータセットである「NudeNet」です。NudeNetはwinchester6788さんがRedditや他のソースからデータを収集してGitHub上で公開したもので、さまざまな研究者や開発者がこれを利用しています。

GitHub - vladmandic/nudenet: NudeNet: NSFW Object Detection for TFJS and NodeJS

https://github.com/vladmandic/nudenet

GoogleアカウントをBANされてしまったのは、NudeNetを使用していたmarkatlargeさんです。markatlargeさんはNudeNetのデータセットをダウンロードし、自身のGoogleドライブに保存してNSFWコンテンツを検出するアプリ「punge」のベンチマークテストを行っていたそうです。

すると、Googleから「あなたのアカウントには児童性的虐待コンテンツ(CSAM)が含まれています。これはGoogleポリシーの重大な違反であり、違法となる可能性があります」というメッセージを受け取り、自身がアップロードしたデータにCSAMが含まれていたことを知ったそうです。これにより、markatlargeさんはGoogleアカウントをBANされてしまい、14年間利用してきたGmail、アプリのバックエンドとして機能するFirebase、モバイルアプリ収益化プラットフォームであるAdMobなどにアクセスできなくなってしまったそうです。

markatlargeさんはGoogleに異議申し立てを行い、アップロードした問題の画像はNudeNetから取得したものであり、自身はNudeNetを「成人向けコンテンツのみを検出できる信頼できる研究用データセット」であると信じていたと説明しています。

Googleは異議申し立てを認めたものの、アカウント停止処分は維持したままだったため、markatlargeさんは引き続きGoogleサービスにアクセスできない状態となってしまいました。そこで、もう一度異議申し立てを行ったそうですが、これは却下されてしまった模様。

markatlargeさんはアカウントが削除されてから、全米行方不明・被搾取児童センターやカナダ児童保護センターに「NudeNetにはCSAMが含まれている」ということを通知します。さらに、NudeNetがホストされていたAcademic Torrentsにも連絡し、同データセットをプラットフォームから削除しています。

連絡を受けたカナダ児童保護センターが独自に調査を行ったところ、NudeNetには「特定または既知のCSAM被害者の画像が120枚以上含まれている」ことや、「思春期前の子どもの性器や肛門に焦点を当てた画像が70枚近く含まれている」こと、「10代の若者の性行為や性的虐待行為を写した画像が含まれていること」などが明らかになりました。

これに対して、NudeNetの作者であるwinchester6788さんは、「膨大な画像の中からCSAMを確認したり削除したりすることは基本的に不可能」と言及しています。

一方、NudeNetを利用したことでGoogleアカウントが使えなくなってしまったmarkatlargeさんは、「問題は独立系開発者がCSAM検出に必要なツールに全くアクセスできない一方で、大手IT企業はそれらの機能を独占しているということです。Googleなどの巨大企業は、CSAMも含まれているLAION-5Bのようなデータセットを公然と利用しながら、何の責任も問われていません。Googleは初期のLAIONを自社AIモデルのトレーニングにさえ使用しています。それにもかかわらず、Googleを禁止する人はいません。しかし、私が正当なテストのためにNudeNetに触れたところ、Googleは私のアカウントから13万枚以上のファイルを削除しました。実際には約70万枚の画像のうち、問題があったのは約700枚だけだったにもかかわらずです。これは安全とは言えません。独立した監視も説明責任もないまま、検出システムが過剰に機能しています」とコメントし、独立系開発者がCSAM検出に必要なデータセットを利用できない現状に不満を述べています。

404 Mediaは今回の出来事について、「インターネットから無差別にスクレイピングされたAIトレーニングデータに、違法画像が含まれていることに気づかず利用する人々にどのような影響を与えるかを示す最新の事例」と報道。また、数百万枚の画像で構成されるトレーニングデータから有害な画像を特定することがいかに難しいかを示しているとも言及しました。

なお、markatlargeさんのGoogleアカウントは、404 MediaがGoogleに今回の事態についてコメントを求めたところ、再度アカウントに関する調査が行われることとなり、最終的に復元されたそうです。

Googleの広報担当者は「GoogleはCSAMの拡散防止に尽力しており、この種のコンテンツの拡散に対しては強力な保護対策を講じています。今回のケースでは、ユーザーアカウントでCSAMが検出されましたが、審査ではユーザーのアップロードは悪意のないものと判断されるべきでした。問題のアカウントは復旧しており、今後もプロセスの継続的な改善に取り組んでまいります」と404 Mediaにコメントしています。

・関連記事

自分の書いた小説を「不適切なコンテンツ」と見なされGoogleドキュメントから締め出された作家が嘆きの声 - GIGAZINE

医者の診察のため幼児の性器を撮影した親が児童性虐待の疑いでGoogleアカウントを無効化される - GIGAZINE

戦車の研究者が「テロ活動に従事している」としてGoogleアカウントをロックされる - GIGAZINE

会社内のGoogleアカウントがまとめてBANされ大混乱に、原因は「冗談」 - GIGAZINE

Googleアカウントから完全に締め出されたときの対処法は? - GIGAZINE

・関連コンテンツ

in AI, Posted by logu_ii

You can read the machine translated English article Developer who uploaded AI training data ….