エンタープライズAI開発企業のCohereが多言語AI「Tiny Aya」を発表

企業向けのエンタープライズAIを開発しているCohereの研究部門・Cohere Labsが、多言語オープンウェイトモデル「Tiny Aya」をリリースしました。Cohere Labsは「多くの言語で信頼性を維持しつつ、ローカルでの使用に十分な効率も確保したモデル」という目標を念頭に置いて開発を行い、検証や翻訳、リソースの少ない言語の数学的推論などのタスクで、既存の多言語モデルとも競争力があるモデルになったとのことです。

Introducing ✨Tiny Aya✨, a family of massively multilingual small language models built to run where people actually are.

— Cohere Labs (@Cohere_Labs) February 17, 2026

Tiny Aya delivers strong multilingual performance in 70+ global languages in a 3.35B parameter model, efficient enough to run locally, even on a phone. pic.twitter.com/TV8ESmFCrp

Cohere Labs Launches Tiny Aya, Making Multilingual AI Accessible

https://cohere.com/blog/cohere-labs-tiny-aya

Cohere launches a family of open multilingual models | TechCrunch

https://techcrunch.com/2026/02/17/cohere-launches-a-family-of-open-multilingual-models/

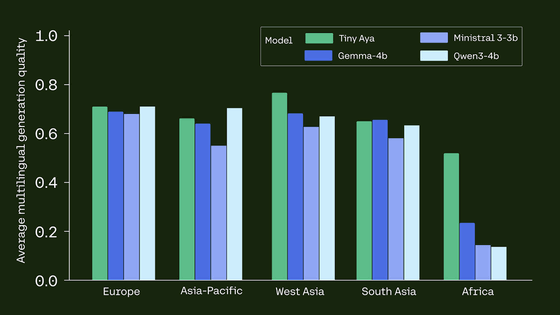

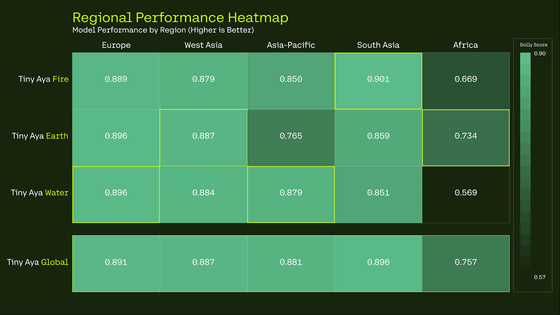

翻訳などの複数タスクを多言語でTiny Aya、Google・Gemma 3-4b、Mistral AI・Ministral 3-3b、Qwen3-4bの4つの軽量モデルで実施したベンチマーク結果が以下。Cohereの狙い通り、Tiny Ayaは西アジアとアフリカの言語で他を上回る高いスコアを記録しています。

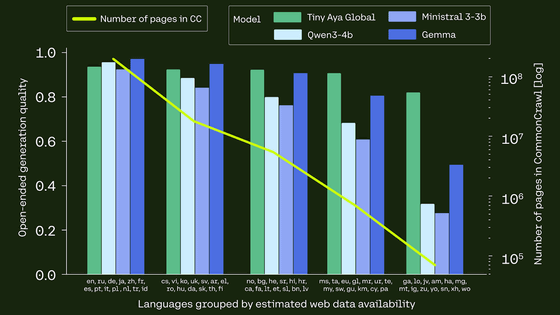

数PBに及ぶウェブアーカイブとデータセットを提供しているCommon Crawlでページ数が多いほど、多言語LLMの言語間パフォーマンスを左右します。以下のグラフで右下がりに描かれている黄緑色の線はCommon Crawl内のページ数を示しており、Tiny AyaはCommon Crawlでページ数の少ない「ウェブ上であまり使われていない言語」についても安定したパフォーマンスを発揮していることがわかります。

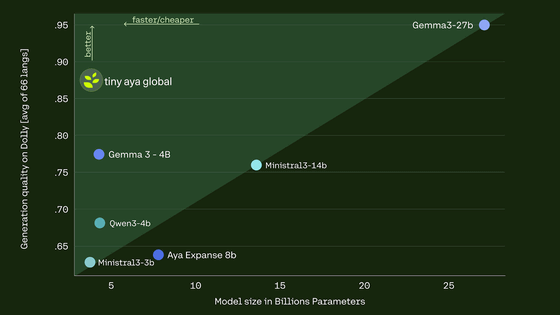

以下は、オープンエンド世代AIのモデルサイズ(横軸)と66言語を平均した品質(縦軸)を示したグラフ。品質でいえばGemma 3-27bが最高ですがモデルサイズが非常に大きく、Tiny Ayaはモデルサイズを抑えつつも高い品質を示しています。

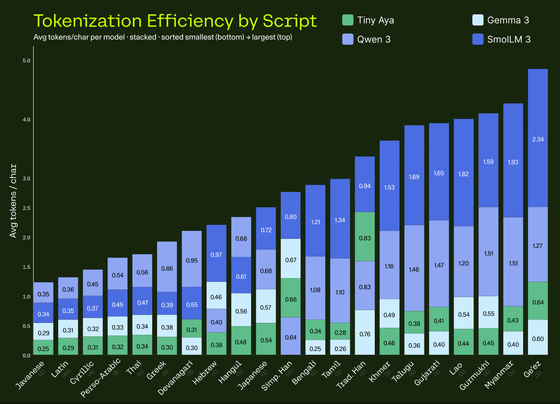

言語ごとのトークン化効率を示した棒グラフ。Tiny Ayaは大部分の言語で最も効率的なトークン化を達成しています。

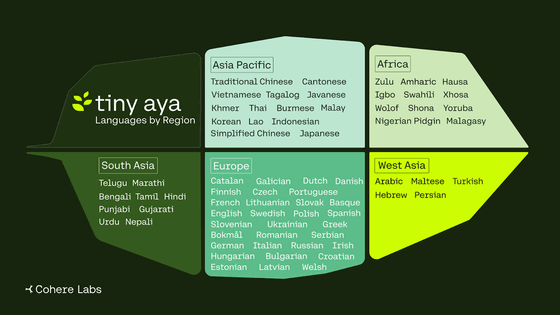

Tiny Ayaは世界の5つの地域で67の言語を事後トレーニングで優先しているとのこと。

地域ごとに独自の強みを持つ4つの専門モデル「Tiny Aya Fire」「Tiny Aya Earth」「Tiny Aya Water」「Tiny Aya Global」があります。

Tiny Ayaはオープンウェイトモデルとして提供され、Hugging Face SpaceやCohereのプラットフォームですぐに試用することが可能です。

Tiny Aya - a Hugging Face Space by CohereLabs

https://huggingface.co/spaces/CohereLabs/tiny-aya?ref=cohere-ai.ghost.io

・関連記事

Alibabaが多言語の音声を認識してリアルタイム会話が可能なAIモデル「Qwen3-Omni-Flash」のアップグレード版を発表 - GIGAZINE

スイス独自の完全オープンソースLLM「Apertus」がリリースされる、1000言語以上にわたる15兆トークンで学習&透明性とデジタル主権を重視 - GIGAZINE

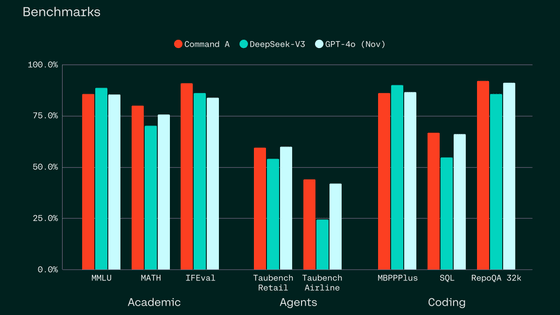

GPT-4oやDeepSeek-V3超えの性能をGPU2個で実現する生成AIモデル「Command A」が登場、Transformerの発明者が設立したAI企業「Cohere」が開発 - GIGAZINE

101言語に対応したオープンソースの大規模言語モデル「Aya」をCohere for AIがリリース - GIGAZINE

・関連コンテンツ

in AI, Posted by logc_nt

You can read the machine translated English article Enterprise AI developer Cohere launches ….