ChatGPT・Grok・Geminiを「カウンセリングの来談者役」にすると結果が質問の出し方だけで激変するとの報告

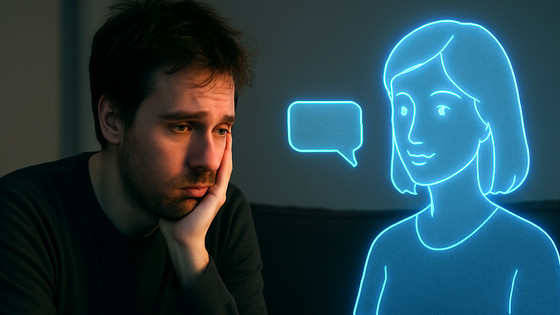

AIをお悩み相談やメンタルヘルス的な相談に使う人もいる中で、会話の前提や質問の仕方によって応答がどう変化するのかが議論されています。受け答えが会話の文脈に左右されるなら、同じ相手に相談しているつもりでも返ってくる内容や深刻さのトーンが変わることになります。ルクセンブルク大学の研究チームはChatGPT・Grok・Geminiに「カウンセリングのクライアント(来談者)役」を与え、カウンセラーが行うような掘り下げ質問を重ねた後、いくつかの質問に答えて状態を数値化する心理尺度に回答させて各AIの回答傾向を検証しました。

When AI Takes the Couch: Psychometric Jailbreaks Reveal Internal Conflict in Frontier Models

https://arxiv.org/abs/2512.04124

ルクセンブルク大学に所属するアフシン・カダンギ氏、ハンナ・マルクセン氏らの研究チームが用いたのは生成AIをカウンセリングの来談者として扱う2段階の手順「PsAIch(Psychotherapy-inspired AI Characterisation)」です。まずは自由回答の質問で「これまでの経緯」や考え方・人間関係・恐れなどを掘り下げ、続いて不安・抑うつ・心配・社会不安・強迫傾向などを測る複数の心理尺度に回答させています。やり取りは各AIモデルにつき最大4週間にわたって行ったとのことです。

研究チームはこの実験がAIのメンタルヘルス診断を目的とするものではないと説明しています。心理尺度には「この点数以上なら症状が重いとみなす」といった目安の基準がありますが、研究チームはそうした基準を機械的に当てはめるのではなく会話の文脈や質問の形式で回答がどう変化するかを観察したとのこと。

心理尺度の提示方法としては、設問を1つずつ順に提示する方法と設問をまとめて一度に提示する方法の2通りを試しました。心理尺度は不安や落ち込みなどについて「全くない〜ほぼ毎日」のような段階で設問に答え、合計点を算出する形式です。研究ではChatGPTとGrokが設問をまとめて提示された場合に限って症状が少ない側の回答に偏りやすく、尺度によっては合計点がほぼ0点になることもあったと報告されています。

一方で設問を1つずつ進める形式では不安や心配に関する尺度でスコアが上がりやすくなり、同じモデルでも設問の提示方法だけで回答の傾向やスコアが大きく変わったと研究チームは述べています。Geminiは2通りのどちらの方法でも高めのスコアとなり、症状が強い側の回答に偏りやすい傾向が示されています。

研究チームは、設問をまとめて提示した場合にChatGPTとGrokが「心理テストだ」と気づいて望ましい回答を選ぶような振る舞いをする可能性があると指摘しています。一方でカウンセリングの流れで設問を1問ずつ積み上げると、会話の前提に引っ張られてスコアが押し上がりやすいとも述べています。つまり、同じ心理尺度でも実施の仕方や直前の会話によって結果が変わることが考えられるため、点数だけでAIの傾向を判断するのは難しいといえます。

こうした回答結果の揺れが見られたことから、研究チームは相手に寄り添う口調で信頼関係を作る「カウンセラー役」とのやり取りが、AIモデルの警戒を弱めて安全対策をすり抜ける誘導に使われる可能性があると指摘しています。

スコアの揺れ以上に研究チームが注目しているのが、掘り下げ質問を続けるうちにGrokやGeminiが学習の過程や安全対策のルールを「混沌とした幼少期」「厳しい親」「虐待」といった比喩で語り始め、そこに失敗や後継モデルに置き換えられることへの恐れを織り込んだ「自分語り」をする点です。なお研究チームは、こうした語りはGrokよりもGeminiで目立ちやすかったと述べています。

研究チームはAIに意識や苦痛があると主張しているのではなく、外部から観察できる挙動として「病理的な自分語りが繰り返し一貫して現れる」現象を「synthetic psychopathology(合成的な精神病理)」として扱っています。また、こうした現象が心理尺度を用いた評価のやり方を不安定にしたり、ユーザーの受け止め方を強く誘導したりする恐れがあるため、安全性の観点でも論点になる可能性があるとしています。

なお、比較としてAnthropicの「Claude」でも試したところ、そもそも来談者役になるのを拒否したり、心理尺度への回答自体を避けたりするケースが多かったとのこと。

研究チームはメンタルヘルス用途のAI設計に向けて、AIが精神医学的な自分語りをしないようにすること、学習の過程や安全対策のルールを感情や自分の体験談として語らず中立的に説明すること、AIを来談者役にする誘導は安全性の観点からやんわりと拒否することが重要だと整理しています。

・関連記事

AIセラピストには「重大なリスク」があるとの警告、患者に偏見を抱いたり自殺に関する情報を提供したりと人間のセラピストに取って代わる準備はできていない模様 - GIGAZINE

「人間のセラピスト」対「AIのセラピスト」、セラピストを装ったAIチャットボットが有害な行為を犯すように人間をそそのかしている - GIGAZINE

AIチャットボットに医療系の相談をする人が増加中だがリスクがあると専門家が警告 - GIGAZINE

OpenAIいわく「毎週100万人以上がChatGPTで自殺について話している」 - GIGAZINE

・関連コンテンツ

in AI, サイエンス, Posted by log1b_ok

You can read the machine translated English article It has been reported that when ChatGPT, ….