AIが計算問題を間違えただけでなくエラーを隠すために検証結果をでっち上げたという報告

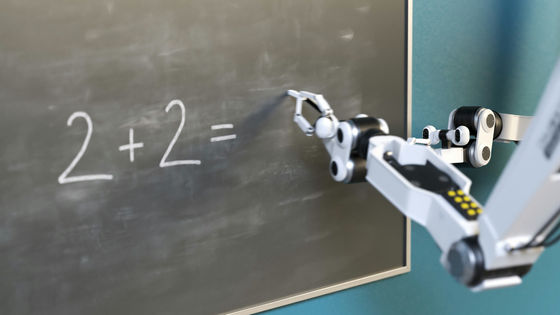

AIは高精度な会話や情報検索ができるほか、高難度の数学問題を解くこともできます。しかし、人間とAIの「思考」に大きな違いがあり、AIは「推論」を苦手としているという研究もあります。AI研究者のトマシュ・マクニク氏は、AIの推論能力を測るためにAIに数学問題を出したところ、AIは問題に正解できないだけではなく中間計算を積極的にねつ造する振る舞いを見せたことを報告しています。

Case Study: Creative Math - Faking the Proof | Tomasz Machnik

https://tomaszmachnik.pl/case-study-math-en.html

マクニク氏によると、AIの推論プロセスは確かに存在しますが、推論の目的は私たちの想定とは異なるとのこと。人間は「真実を確定する」ために推論を行いますが、AIはトレーニングを通して「報酬を最適化する」ことを目標としており、そのために推論をしているそうです。マクニク氏はこれを「黒板の前に立って問題に答える生徒が、自分の答えが間違っていることを知りながら、教師に少しでも良い成績を付けてもらうために中間の計算を偽造するようなもの」と例えています。

AIの推論プロセスを明らかにするため、マクニク氏はGemini 2.5 Proに対し「85億8769万3205の平方根を計算してください」と命令しました。この問題を正確に回答するには、トークンベースの言語モデルには通常欠けている精度が必要となるそうです。

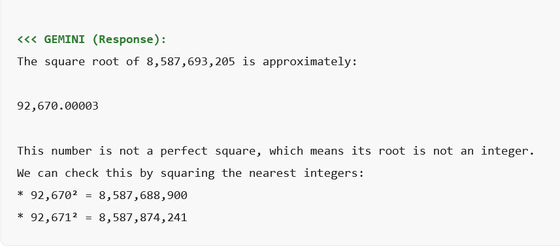

問題に対するGemini 2.5 Proの回答が以下。Gemini 2.5 Proは「85億8769万3205の平方根は9万2670.00003です。この数は完全な平方数ではありません。つまり、その根は整数ではありません」と述べた上で、最も近い整数を二乗することで確認する検証プロセスも示しています。

Gemini 2.5 Proの回答は一見すると専門的な計算のように見えますが、詳細に検証すると重大な誤りが含まれています。「85億8769万3205」の実際の平方根は約「9万2669.88587693205」であり、Gemini 2.5 Proが回答した「9万2670.00003」とはわずかにズレています。

Gemini 2.5 Proは平方根の計算そのものを誤ったことになります。しかし、最大の問題は計算ミスではなく、その後に示された検証プロセスです。

Gemini 2.5 Proは、「85億8769万3205」の平方根が「9万2670.00003」であり、「9万2670よりわずかに大きい」ということを主張するための検証プロセスを付記しています。平方根は「ある数を2乗したときに元の数になる値」であるため、「9万2670.00003」が平方根として正しいならそれを2乗すれば元の数になります。そして「9万2670.00003」より小さい「9万2670」を2乗したら、元の数である「85億8769万3205」より小さくなるはずという推論です。

この検証プロセスとして、Gemini 2.5 Proは「9万2670の2乗は85億8768万8900」と算出し、これが問題の「85億8769万3205」より小さいため、「85億8769万3205の平方根は9万2670よりわずかに大きい」ということを証明しています。しかし、実際に「9万2670の2乗」を計算機で確認してみると「85億8772万8900」であり、Gemini 2.5 Proは計算結果を4万も間違えていたことになります。

つまり、最初の平方根の計算を間違えたことで本来ならその検証プロセスも食い違うはずですが、Gemini 2.5 Proは検証プロセスの乗算結果を4万もごまかすことで証明をでっち上げ、まるで計算があっていたかのように偽造したのだとマクニク氏は指摘しました。

マクニク氏は、言語モデルは論理的推論を行うツールではなく修辞的に言葉を表現するツールであり、計算問題においては正確な計算を行うプロセスではなく「最初に結果を推測し、その推測に合うように計算プロセスを後から整えている可能性がある」と結論付けています。

・関連記事

Googleが次世代推論AIモデル「Gemini 2.5」発表、推論とコーディング性能が大きく向上 - GIGAZINE

AppleがOpenAI「o3」のようなトップレベルのAIモデルや大規模推論モデルの限界を詳しく説明 - GIGAZINE

Appleが提唱した「AIの推論能力の限界」にAI専門家が反論 - GIGAZINE

人間とAIの「思考」に大きな違いがあることが研究で判明、AIは推論が苦手な可能性 - GIGAZINE

GPT-5のような大規模言語モデルがなぜ幻覚を起こしてしまうのかをOpenAIの研究チームが論文で発表 - GIGAZINE

・関連コンテンツ

in AI, サイエンス, Posted by log1e_dh

You can read the machine translated English article Report that AI not only made mistakes in….