ついにAI学習のためのデータが枯渇へ、データセットが不足しているAI企業は大規模で汎用的なLLMから小規模で専門性の高いモデルへの移行を余儀なくされる可能性大

AIモデルの開発には学習資料となるデータセットが必要不可欠ですが、すでに大規模なモデルはアクセスできるデータのほとんどを食い尽くしており、2028年までにデータを使い果たしてしまう可能性が指摘されています。AIとデータセットの現状について、学術雑誌のNatureがまとめています。

The AI revolution is running out of data. What can researchers do?

https://www.nature.com/articles/d41586-024-03990-2

Synthetic data has its limits — why human-sourced data can help prevent AI model collapse | VentureBeat

https://venturebeat.com/ai/synthetic-data-has-its-limits-why-human-sourced-data-can-help-prevent-ai-model-collapse/

OpenAI cofounder Ilya Sutskever predicts the end of AI pre-training - The Verge

https://www.theverge.com/2024/12/13/24320811/what-ilya-sutskever-sees-openai-model-data-training

過去10年間でAIは爆発的な成長を遂げており、特に人間の文章を解析してもっともらしい文章を返す能力には目を見張るものがありますが、こうした能力はすべて、インターネット上に存在する既存の文章などさまざまなデータを学習した上で構築されたものです。

インターネット上には膨大な量のデータが存在することは間違いないのですが、研究機関のEpoch AIによると、AIはインターネット上のデータを驚くべきスピードで学習し続けており、そのほとんどを食い尽くしてしまう可能性があるとのことです。

Epoch AIは「2028年頃までに、AIモデルの学習に使用されるデータセットのサイズは、インターネット上に存在する文章の総ストックと同じサイズに達する」と予測。これはつまり、2028年頃までにAIは学習データを使い果たしてしまう可能性が高いということを意味します。データセットが不足することに加え、新聞社などのデータ所有者がコンテンツの利用を取り締まり始め、アクセスをさらに厳しくしているのもAI研究者にとってのハードルとなっています。

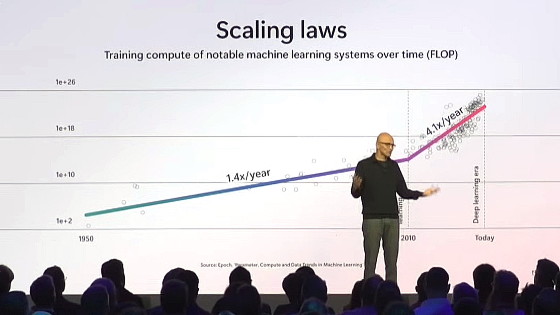

こうした問題はAI研究者の間でも認知されており、従来のデータセットを使い果たすことで学習のスケーリングが限界に近づくという法則が語られることがあります。データセットの不足を補うため、AI研究者は学習の方法を変更するなどしてAIの性能向上を模索しています。

AIのスケーリング則が限界に直面、「学習データや学習量を増やせばAIの性能が上がる」という状況はすでに終わっている - GIGAZINE

例えば、OpenAIやAnthropicといった著名なAI企業は、データセット不足の問題を公に認めつつ、新たなデータの生成や従来とは異なるデータソースの発見など、問題を回避するための計画があることを示唆しています。OpenAIの広報担当者は「我々は、公開データ、パートナーシップを結んで得られる非公開データ、生成で得られる合成データ、AIトレーナーからのデータなど、多くの情報源を利用しています」と語っているとのこと。

また、OpenAIを離れてAIの安全性改善に取り組む企業「Safe Superintelligence」を立ち上げたイルヤ・サツキヴァー氏は、「最終的には既存のモデルの学習方法からの転換が強制されるでしょう。次世代のモデルは、以前に見たものに基づいてパターンマッチングを行う既存のAIとは異なり、より『思考』に近い方法で段階的に物事を解決できるようになるでしょう」と述べています。

データセットが不足するとAIが新しい情報を取り入れることができなくなり、AIの進歩が停滞する可能性がありますが、かといってAIが生成したデータを取り込んではデータの信頼性に疑問が生じます。

Natureは「いろいろな回避策が模索されていますが、それでも、データの不足はAIモデルに変化を迫るかもしれません。おそらく、大規模で万能なLLMから、小規模でより専門的なモデルへと状況がシフトする可能性があります」と指摘しました。

データセットをスケールアップすることなく、モデルの計算能力やパラメーターの数をスケールアップすることは可能ですが、その場合はAIの処理速度が遅くなり、コストが高くなる傾向があります。天文学やゲノムデータなど、AIの進歩で急速に増加している特殊なデータセットを学習するという手もありますが、極端に専門性が高いモデルしか作れない可能性もあります。

Natureは「一部のモデルはラベル付けされていない動画や画像である程度のトレーニングをすることがすでに可能です。こうしたデータで学習する機能を拡張・改善することで、より豊富なデータへの門戸が開かれる可能性はあります」と述べました。

・関連記事

OpenAIはAIの進化の頭打ちで戦略の転換を余儀なくされている、高品質なデータ枯渇の問題が急激に顕在化 - GIGAZINE

GoogleやGoogle DeepMindが2023年のAIとコンピューティングについての研究成果を振り返る - GIGAZINE

大規模言語モデル(LLM)をLoRAで強化する際に役立つ情報を研究者が公開 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Finally, data for AI training is running….