コンピューターサイエンスに関する論文に対する5万件の査読報告書を分析すると7~17%がAI生成だったことが判明

近年ではChatGPTなどの人間と同等のレベルで自然な文章を生成できるAIや、テキストを入力するだけで高精度な画像やイラストを生成できるAIが次々と登場しており、これまでの調査では、学生の約17%が「課題または試験にChatGPTを使っている」と回答しています。スタンフォード大学などの研究チームが行った調査では、2023年から2024年にかけて学術誌に掲載されたコンピューターサイエンスに関する論文に対して行われた査読の報告書約5万件を分析した結果、文章の約7~17%がAIによって書かれた可能性があることが明らかになりました。

Monitoring AI-Modified Content at Scale: A Case Study on the Impact of ChatGPT on AI Conference Peer Reviews - liang24b.pdf

(PDFファイル)https://raw.githubusercontent.com/mlresearch/v235/main/assets/liang24b/liang24b.pdf

Monitoring AI-Modified Content at Scale: A Case Study on the Impact of ChatGPT on AI Conference Peer Reviews

https://proceedings.mlr.press/v235/liang24b.html

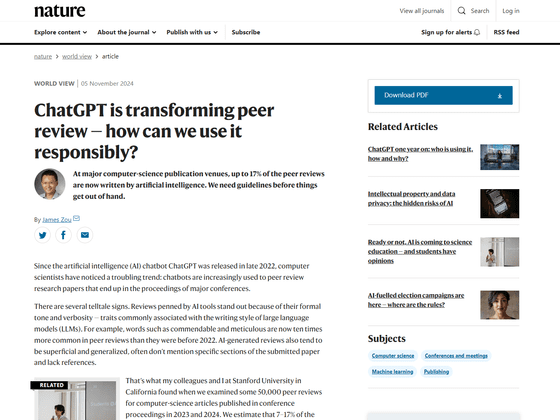

ChatGPT is transforming peer review — how can we use it responsibly?

https://www.nature.com/articles/d41586-024-03588-8

スタンフォード大学のジェームス・ゾウ氏らの研究チームは、2023年から2024年にかけて会議録に掲載されたコンピューターサイエンスに関する論文に対する査読報告書約5万件を調査しました。その結果、査読報告書の文章の約7~17%にAIが書いたと推定される単語や執筆スタイルが現れたそうです。

ゾウ氏によると、AIツールが書いた査読報告書には大規模言語モデルが生成する文体でよく見られる「堅苦しい口調」と「冗長さ」が含まれているとのこと。また、実際の査読報告書では、「称賛に値する」「綿密な」などのAIが生成しやすい言葉の登場回数が2022年以前と比べて約10倍になっていることも報告されています。

AIが生成した査読報告書は表面的で一般化された内容になっている傾向があり、提出された論文の特定のセクションについて言及していないほか、参考文献も不足していることが多いと指摘されています。

AIによる査読報告書の急速な増加について、ゾウ氏は「締め切り間近に提出された査読報告書では特に大規模言語モデルで生成したテキストの割合が高くなることが分かりました。近年では、学術誌の査読担当者は数多く寄せられる査読リクエストに圧倒されており、時間が不足しています。AIによる査読報告書の生成は今後ますます増加するでしょう」と述べました。

また、ゾウ氏は「大規模言語モデルなどのAIシステムは言語や文法の修正、簡単な質問への回答、関連情報の特定など、さまざまな問題を解決するのに役立ちます」と述べた上で、「無責任に使用すると、大規模言語モデルは科学プロセスの完全性を損なうリスクがあります」と忠告しました。そして、科学コミュニティに対して、論文の査読プロセスにおいて責任を持ってAIを使用する方法に関する規範を確立するよう提言しています。

近年の大規模言語モデルは、詳細な科学的推論を行うことができないほか、幻覚(ハルシネーション)と呼ばれる無意味な応答を生成することもあり、ゾウ氏は「現時点での大規模言語モデルは熟練した人間の査読者に取って代わることができないことを認識することが重要です」と指摘しました。実際に、大規模言語モデルが生成した査読を受けた研究者からは、「フィードバックに方法論的な批評など、技術的な深みが欠けている」「研究論文の間違いを簡単に見落としてしまう」との批判が寄せられています。

そこでゾウ氏は、査読プロセスに大規模言語モデルを用いることは認めつつも「大規模言語モデルの出力を最終的なものとするのではなく、出発点と見なし、生成された結果を人間の査読者がクロスチェックする必要があります」と語りました。

また、ゾウ氏はAIアルゴリズムを「論文や査読報告書の執筆に大規模言語モデルが使用されていないかどうかの検出」に使うことについても「有効性は限られている」と批判しています。実際に、海外メディアのBloombergが、ChatGPTのリリースより前に書かれた500本の小論文をAI検出器のGPTZeroとCopyleaksにかける調査を行ったところ、500本中3本がAIで生成したものだと判断されたほか、9本が部分的にAIを用いて書かれたものだと誤認されました。

さらに、スタンフォード大学の調査では、英語が母国語ではない生徒が書いた作文の半分以上ををAI検出器はAI生成テキストと識別したことも報告されています。

AI検出器は人間の学生が書いた文章の1~2%をAI製と誤認、ぬれぎぬで試験を落とされる学生にとってはたまったものではない精度 - GIGAZINE

ゾウ氏は「学術論文執筆や査読プロセスにおける大規模言語モデルの波を止めることはできません」と述べた上で、査読者と著者が匿名でやり取りし、何度も議論を行うことが可能なOpenReviewなどのプラットフォームを利用して、プロセス中の人間同士のやり取りを増やすべきと提言しました。また、「ジャーナルや学会は査読プロセス中の大規模言語モデルの使用について明確なガイドラインを確立し、それを強制するシステムを導入するべき」と語っています。

一方でゾウ氏は「AIが特定の査読タスクを責任を持って支援する方法についても、さらに多くの研究が必要です。コミュニティの規範とリソースを確立することで、科学的プロセスの完全性を損なうことなく、大規模言語モデルが査読者や著者に利益をもたらすことができるはずです」と述べました。

・関連記事

課題にAIを使用した生徒へ罰を与えた学校を保護者が提訴 - GIGAZINE

AIが生成した文章を検出するツールの誤検知で「AIを使って課題のエッセイを作成した」と疑われて0点になったという事例 - GIGAZINE

「AIは実際のところ従業員の生産性を低下させている」という指摘 - GIGAZINE

AIが偽の研究を量産する「論文工場」との戦いが激化している - GIGAZINE

ChatGPTで書かれた科学論文を99%以上の精度で検出できるツールが開発される - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1r_ut

You can read the machine translated English article Analysis of 50,000 peer review reports f….