イギリスの海岸で「ヴィクトリア朝時代の靴」が数百足発見される

海岸での教育活動や清掃活動などを実施しているイギリスの団体「Beach Academy」が約150年前に漂着したと考えられるヴィクトリア朝時代の靴を数百足発見しました。

Why 437 Victorian Leather Shoes Have Mysteriously Washed Up On A Beach | IFLScience

https://www.iflscience.com/hundreds-of-19th-century-black-leather-shoes-have-mysteriously-washed-up-on-a-beach-82031

Hundreds of Mysterious Victorian-Era Shoes Are Washing Up on a Beach in Wales. Nobody Knows Where They Came From

https://www.smithsonianmag.com/smart-news/hundreds-of-mysterious-victorian-era-shoes-are-washing-up-on-a-beach-in-wales-nobody-knows-where-they-came-from-180987943/

靴が見つかったのはイギリスのウェールズ南部に位置するオグモア・バイ・シーの沿岸です。

Beach Academyは岩礁再生プロジェクトの一環としてオグモア・バイ・シーの沿岸地域で活動していた際に黒色の革靴を大量に発見しました。Beach AcademyのFacebook投稿によると、発見数はわずか1週間で200足に上ります。

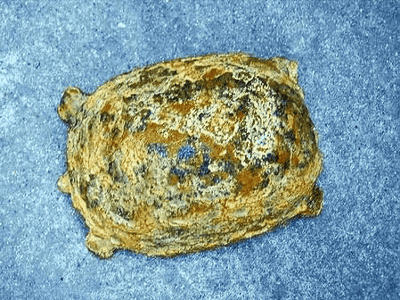

発見された革靴はこんな感じ。

ソール部分なども原形をとどめた状態で残っていました。

革靴は2025年12月末までに437足も発見されました。革靴の正確な由来は不明ですが、Beach Academyは「最も有力な説は、約150年前にイタリアからイギリスに渡航して難破船となった『フロリック号』に由来するというものです」と説明しています。

・関連記事

「人間の足首から先が入ったスニーカー」が相次いで打ち上がる海岸の真相とは? - GIGAZINE

サメに食べられないよう注意を促す啓発活動に効果はあるのか? - GIGAZINE

太陽嵐がクジラの感覚を狂わせ座礁させているという調査結果 - GIGAZINE

伝説の「クジラの爆破解体イベント」から50周年を迎える、爆破の瞬間を記録したムービーも公開中 - GIGAZINE

約8000万円の値が付いた「ヘンリー3世の金貨」はなぜ世界にたった8枚しかないのか? - GIGAZINE

200年以上も考古学者を困惑させてきた「ローマの中空十二面体」 - GIGAZINE

・関連コンテンツ

in メモ, Posted by log1o_hf

You can read the machine translated English article Hundreds of pairs of Victorian shoes dis….