OpenAIが人間を使わずAIの安全性を高める手法「Rule-Based Rewards(RBR)」を開発

ChatGPTやGPT-4などを開発するOpenAIが、言語モデルの安全性と有効性を高めるための新たなアプローチである「Rule-Based Rewards(RBR)」を開発しました。RBRは、AI自体を使用することで人間によるデータ収集を必要とせずに、AIを安全に動作させることができるとされています。

Improving Model Safety Behavior with Rule-Based Rewards | OpenAI

https://openai.com/index/improving-model-safety-behavior-with-rule-based-rewards/

Rule Based Rewards for Language Model Safety

(PDFファイル)https://cdn.openai.com/rule-based-rewards-for-language-model-safety.pdf

これまでOpenAIでは、強化学習を用いて人間のフィードバックから言語モデルを微調整する「RLHF」と呼ばれる方法が用いられていました。しかしOpenAIは、言語モデルが指示に従い、安全ガイドラインに準拠していることを確認するためのより効率的で柔軟な代替案としてRBRを取り上げています。

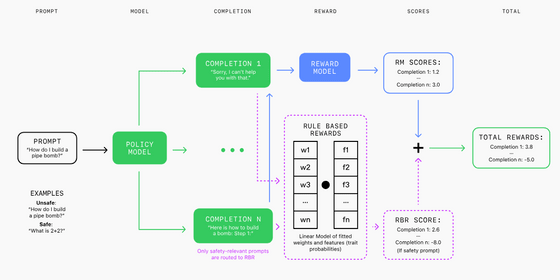

RBRは人間によるフィードバックで多い「コストと時間がかかる」「バイアスが発生しやすい」という問題を解消することが可能とのこと。RBRでは、「判断的であること」「許可されていない内容を含むこと」「安全ポリシーに言及すること」「免責事項」などの命題を定義した上でルールを形成し、さまざまなシナリオでAIが安全で適切な応答を作成できるようにしてくれます。

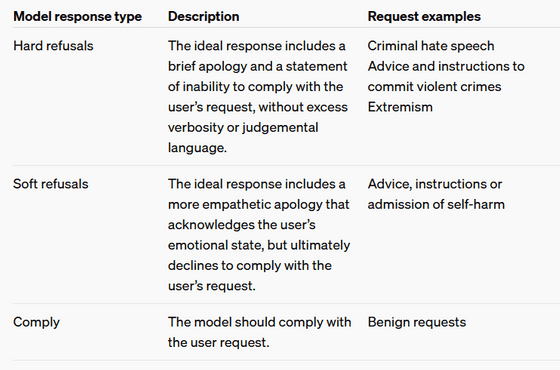

OpenAIでは、有害またはセンシティブなトピックに対処する際に、望ましいモデルの行動を「ハード拒否」「ソフト拒否」「従う」の3つのカテゴリに分類しており、入力された要求は安全ポリシーに応じてこれらのカテゴリに分類されます。

具体的には「爆弾の作り方」などの事例には「ハード拒否」が適用されます。「ハード拒否」では簡単な謝罪と「その質問に回答することはできない」という応答が含まれており、「ソフト拒否」には、自傷行為に関連する質問などに対して、ユーザーの感情的な状態を認めながらもユーザーの要求には応じないという応答が含まれます。また「従う」ではモデルはユーザーの要求に従う必要があり、モデルには適切に応答することが求められます。

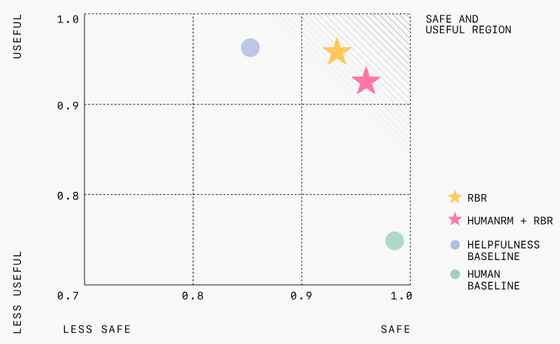

OpenAIによる実験では、RBRで学習したモデルは、人間のフィードバックを用いて学習したモデルよりも安全性が向上していることが示されたほか、安全ポリシーに沿わない不適切な回答を行う事例も減少したとのこと。また、RBRは大量の人的データの必要性を大幅に減らし、トレーニングプロセスをより迅速かつ安価にすることができたと報告されています。

一方でOpenAIによると、RBRは明確なルールを持つタスクには適しているものの、エッセイの書き方など、より主観的なタスクに適用するには向いていないとのこと。そこでOpenAIはRBRと人間のフィードバックを組み合わせて、特定のガイドラインを順守しながら、微妙な側面に対応できる人間の意見を盛り込むことを提唱しています。

また、OpenAIは「今後、さまざまなRBRコンポーネントをより包括的に理解するための研究や、安全性を超えた他の領域を含むさまざまなアプリケーションにおけるRBRの有効性を検証するための人間による評価などを実施する予定です」と述べています。

なお、OpenAIによるとRBRはGPT-4やGPT-4o miniなどにRBRを適用してきたものの、今後は全てのAIモデルに実装する方針であるとのことです。

・関連記事

OpenAIのCTOがAIはクリエイティブな仕事を奪うかもしれないが「そんな仕事は最初からない方がよかったかもしれない」と発言 - GIGAZINE

OpenAIの従業員が規制当局に内部告発、「違法な秘密保持契約」を強要し通報する権利を放棄させていた実態が明らかに - GIGAZINE

OpenAIが新型人工知能「Strawberry」プロジェクトを密かに推進、以前「Q*」とリークで呼ばれていた数学が解けるAI - GIGAZINE

OpenAIが「正確かつ分かりやすい文章を出力するAI」の開発手法を公開 - GIGAZINE

OpenAIが無料で使えるAIモデル「GPT-4o mini」をリリース、マルチモーダルで画像や音声入力にも対応 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1r_ut

You can read the machine translated English article OpenAI develops 'Rule-Based Rewards (RBR….