Mistral AIが突如として新しい大規模言語モデル「8x22B MOE」を発表、コンテキスト長65kでパラメーターサイズは最大1760億か

GoogleやMetaの研究者によって設立されたAIスタートアップのMistral AIが、オープンソースの大規模言語モデル「8x22B MOE」を公開しました。詳細は不明ですが、多くのベンチマークでGPT-3.5やLlama 2 70Bを上回る性能を持つ可能性があることが示されたモデル「Mixtral 8x7B」の3倍以上のパラメーター数を備えている可能性があります。

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%https://t.co/2UepcMGLGd%3A1337%2Fannounce&tr=http%3A%2F%https://t.co/OdtBUsbeV5%3A1337%2Fannounce

— Mistral AI (@MistralAI) April 10, 2024

RELEASE 0535902c85ddbb04d4bebbf4371c6341 lol

— Mistral AI (@MistralAI) April 10, 2024

???? Breaking: New AI Model Alert

— Shubham Saboo (@Saboo_Shubham_) April 10, 2024

Mistral AI just dropped a brand new 8x22B MoE model on X.

65k context length, more details to follow soon. Stay tuned! https://t.co/PpHhwkC7nq pic.twitter.com/XsIYMtbyLy

Mistral 8x22B MOEは、モデル名から判断すると2023年に公開されたオープンソースのモデル「Mixtral 8x7B」の大型版だと考えられます。

Mistral AIはTorrentのマグネットリンクを使用して「8x22B MOE」を共有しました。BitTorrentクライアントを使えば、モデルデータなどをダウンロードできます。

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce

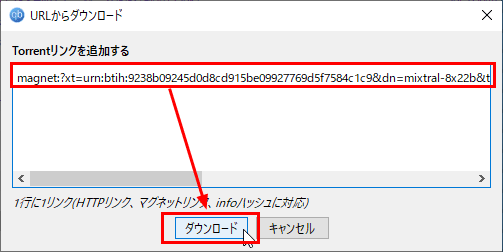

「qBittorrent」を使う場合、「ファイル」から「Torrentリンクを追加」をクリック。

Mistral AIが共有したマグネットリンクをコピーして「ダウンロード」をクリック。

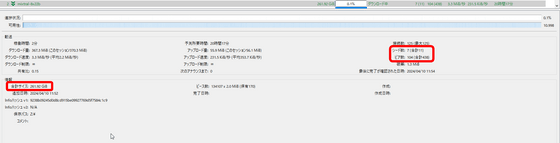

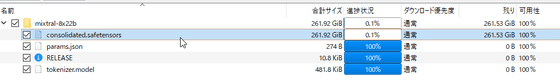

ファイルサイズは約261GB。既にSeedしているのが11人で、438人が記事作成時点でダウンロード中でした。

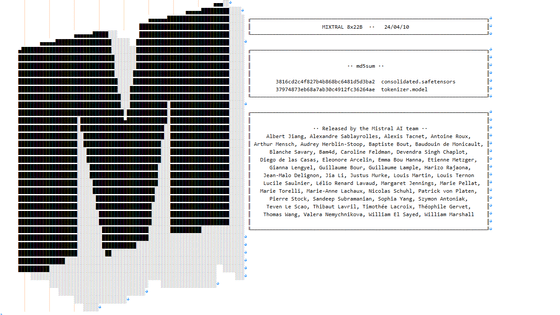

ファイルの中身は以下のようになっています。

8x22B MOEの詳細は不明ですが、パラメーターの総数は最大1760億になっている可能性があります。また扱えるコンテキスト長は65kとされています。Mistral AIのモデルはたびたび「リーク」という形で世に登場することが多いのですが、今回は公式アカウントによる正式リリースとなりました。

Mistral AIが2023年に出した「Mixtral 8x7B」は、パラメーターの総数が467億で、Llama 2 70BやGPT-3.5と同等かそれ以上のベンチマークスコアを獲得していました

無料で商用利用可能な大規模言語モデル「Mixtral 8x7B」が登場、低い推論コストでGPT-3.5と同等以上の性能を発揮可能 - GIGAZINE

Mistral AIはフランスで設立されたスタートアップで、「Mixtral 8x7B」といったオープンソースモデルと、「Mistral Small」「Mistral Embed」「Mistral Large」などの商用モデルの両方を公開しています。すでにベンチャーキャピタルのアンドリーセン・ホロウィッツやライトスピード・ベンチャー・パートナーズなどから3億8500万ユーロ(約630億円)以上を以上を調達しており、評価額は約18億ユーロ(約2970億円)に達しているとのこと。2024年2月にはMicrosoftと数年に及ぶパートナーシップ契約を結び、1500万ユーロ(約25億円)の投資を受けたと報じられていますが、この件に関してはAIの独占を懸念したEU規制当局により調査のメスが入りました。

Mistral AIは前述のモデルを公開しているほか、「Le Chat」というAIチャットサービスも提供中。Mistral AIのオープンソースモデルはNVIDIAの無料のチャットボットAI「Chat With RTX」でも利用できます。

・2024年4月11日年10時50分追記

8x22B MOEがHugging Faceで使えるようにリリースされました。これにより、ノートPCでも大規模言語モデルの性能を試せる「LM Studio」などで8x22B MOEを利用できるようになります。

・続き

無料で商用利用可能なオープンモデル「Mixtral 8x22B」が登場、高いコーディングと数学の能力を持つ - GIGAZINE

・関連記事

ファインチューニング向けモデル「Mistral 7B Fine-Tune Optimized」が登場、特定タスクにおいてGPT-4を超える性能を発揮 - GIGAZINE

本当にオープンソースのライセンスで利用&検証できる大規模言語モデル「Mistral 7B」が登場、「Llama 2 13B」や「Llama 1 34B」を上回る性能のAI開発が可能 - GIGAZINE

MicrosoftがAI開発企業「Mistral AI」との提携を発表、Mistral AIがAzureの計算資源を利用可能になりAzureユーザーはOpenAIのモデルに加えてMistral AIのモデルも利用可能に - GIGAZINE

ネット上に流出した大規模言語モデルは自社製のものだとAI企業・MistralのCEOが確認 - GIGAZINE

日本語対応でGPT-4よりも高性能な大規模言語モデル「Command R+」が登場したので使ってみた、無料でダウンロードしてローカル動作も可能 - GIGAZINE

SSM-Transformerアーキテクチャ採用で従来の約3倍のスループットを実現した大規模言語モデル「Jamba」をAI21 Labsが発表 - GIGAZINE

Databricksがオープンな大規模言語モデル「DBRX」をリリース、GPT-3.5やCodeLLaMA-70Bを上回る性能 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Mistral AI suddenly announces new large-….