ファインチューニング向けモデル「Mistral 7B Fine-Tune Optimized」が登場、特定タスクにおいてGPT-4を超える性能を発揮

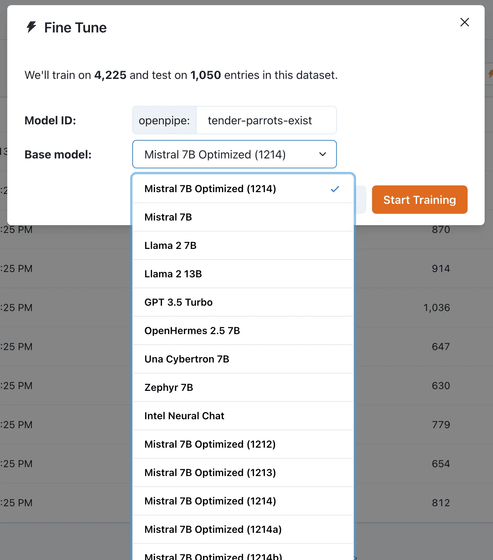

既存のAIモデルに学習データを追加し、自分の好きなようなデータを出力するよう調整する「ファインチューニング」向けのモデル「Mistral 7B Fine-Tune Optimized」が登場しました。このモデルでファインチューニングを行うと、GPT-4を超える性能を発揮することもあるそうです。

How we built “Mistral 7B Fine-Tune Optimized,” the best 7B model for fine-tuning - OpenPipe

https://openpipe.ai/blog/mistral-7b-fine-tune-optimized

元になったモデルはMistral AIが開発した大規模言語モデル「Mistral 7B」です。Mistral 7B Fine-Tune OptimizedはMistral 7Bへさらなる微調整を施すためのベースモデルとなるように最適化されたモデルであり、モデルの指示理解と推論能力を最適化できるとのこと。

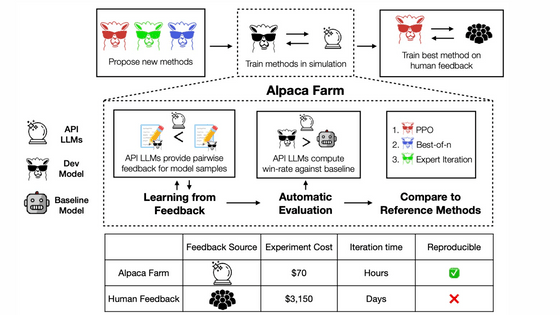

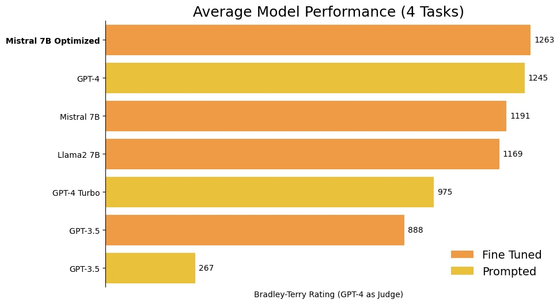

実験的に取り上げた4つのタスクを平均すると、Mistral 7B Fine-Tune OptimizedでファインチューニングしたMistral 7Bは、GPT-4よりわずかに高い値が出ました。

制作チームのOpenPipeは「GPT-4などは汎用(はんよう)モデルであり、特定のタスクでは、ファインチューニングしたような何かに特化したモデルより劣ることがあります」と指摘。全体的な能力が低いモデルであっても、何時間もかけてファインチューニングされたモデルは、一つのタスクを効率的にこなせるようになると解説しました。

制作過程では18個もの仮モデルが誕生したそうですが、複数のモデルを融合したモデルが高いパフォーマンスを示し、それをさらに改良することでMistral 7B Fine-Tune Optimizedが生まれたとのこと。

すでにMistral 7B Fine-Tune OptimizedはHugging Face上で公開されています。OpenPipeは「ユーザーがこのモデルを使ってどんなプレーをするか楽しみですが、これは始まりに過ぎません。時間をかけて、より強く、より速く、より安価なベースモデルをリリースし続けます」と述べました。

・関連記事

無料で商用利用可能な大規模言語モデル「Mixtral 8x7B」が登場、低い推論コストでGPT-3.5と同等以上の性能を発揮可能 - GIGAZINE

本当にオープンソースのライセンスで利用&検証できる大規模言語モデル「Mistral 7B」が登場、「Llama 2 13B」や「Llama 1 34B」を上回る性能のAI開発が可能 - GIGAZINE

大規模言語モデルをLoRAで低コストかつ効率的に微調整できる「Punica」が登場 - GIGAZINE

クラウド上ではなくスマホ上で動くローカルファーストLLM「Gemini Nano」がPixel 8 Proで動作可能に、GboardのSmart Replyとレコーダーの自動要約強化に先行投入 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Introducing the fine-tuning model 'Mistr….