Googleがオープンかつ商用利用可能な大規模言語モデル「Gemma」ファミリーにコード補完・生成・命令フォローを強化した「CodeGemma」と効率を最適化した「RecurrentGemma」を追加すると発表

Googleが2月に公開したオープンかつ商用利用可能な大規模言語モデル「Gemma」ファミリーに、新たなモデルとして「CodeGemma」と「RecurrentGemma」の2つを追加すると発表しました。

Gemma Family Expands with Models Tailored for Developers and Researchers - Google for Developers

https://developers.googleblog.com/2024/04/gemma-family-expands.html

Gemmaは同じくGoogleが作成しているAIモデル「Gemini」と同じ技術を使用して作成された軽量かつオープンなAIモデルです。2月にベースとなる「事前学習済みモデル」および対話性能を高めた「インストラクションチューニング済みモデル」がリリースされていました。

Googleがオープンかつ商用利用可能で軽量な大規模言語モデル「Gemma」を公開 - GIGAZINE

今回発表されたのはコード補完・生成タスク・命令フォローを強化した「CodeGemma」および効率を最適化した「RecurrentGemma」の2つです。

CodeGemmaモデルには20億パラメーターのバリアントが1つ、70億パラメーターのバリアントが2つ存在しています。20億パラメーターのバリアントはローカルコンピューターで高速にコードを補完する用途に適しており、70億パラメーターのバリアントはコード補完とコード生成タスクに特化したものとコード関連のチャットと命令追従に特化したものが存在しています。

CodeGemmaを他のモデルと比較した結果は下図の通り。単一行および複数行のコード補完タスクのパフォーマンスを競合モデルと比較しています。

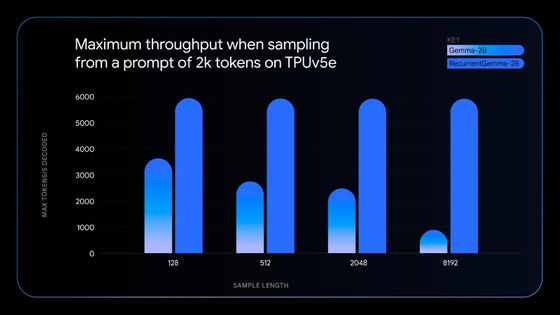

RecurrentGemmaはリカレントニューラルネットワークとローカルアテンションを活用してメモリ効率を向上させたモデルで、Gemma 2Bモデルと同様のベンチマークスコアを達成しながらメモリ使用量を削減したりスループットを大幅に向上させたりすることに成功しました。

左側のGemma 2Bモデルと比較すると、右側のRecurrentGemma 2Bモデルはシーケンスが長くなってもスループットを維持できることが分かります。

CodeGemmaおよびRecurrentGemmaは通常のGemma同様にオープンモデルとして公開されており、商用利用も可能とのこと。なお、Googleは2つのモデルのリリースと同時に元のGemmaモデルのバージョン1.1を新たに公開しています。

・関連記事

日本語能力に優れた商用利用可能な大規模言語モデル「Swallow」が公開される - GIGAZINE

無料で商用利用可能な大規模言語モデル「Mixtral 8x7B」が登場、低い推論コストでGPT-3.5と同等以上の性能を発揮可能 - GIGAZINE

101言語に対応したオープンソースの大規模言語モデル「Aya」をCohere for AIがリリース - GIGAZINE

Databricksがオープンな大規模言語モデル「DBRX」をリリース、GPT-3.5やCodeLLaMA-70Bを上回る性能 - GIGAZINE

無料で商用利用もOKな完全オープンソースの大規模言語モデルを開発するプロジェクト「RedPajama」がトレーニングデータセットを公開 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1d_ts

You can read the machine translated English article Google announces that it will add 'CodeG….