無料で商用利用もOKな完全オープンソースの大規模言語モデルを開発するプロジェクト「RedPajama」がトレーニングデータセットを公開

OpenAIのGPT-4などの大規模言語モデルによって、AI技術が急速に普及しています。しかし、GPT-4をはじめとする大規模言語モデルの多くがクローズドな商用モデルか、あるいは部分的にしかオープンになっていません。「RedPajama」は完全にオープンソース化された大規模言語モデルを開発するプロジェクトで、その第1段階として1兆2000億以上のトークンを含むLLaMAトレーニングデータセットが公開されました。

RedPajama, a project to create leading open-source models, starts by reproducing LLaMA training dataset of over 1.2 trillion tokens — TOGETHER

https://www.together.xyz/blog/redpajama

GitHub - togethercomputer/RedPajama-Data: The RedPajama-Data repository contains code for preparing large datasets for training large language models.

https://github.com/togethercomputer/RedPajama-Data

RedPajamaは再現可能で完全にオープンな言語モデルを生み出すための取り組みで、AIスタートアップのTogether、Ontocord.ai、チューリッヒ工科大学のETH DS3Lab、スタンフォード大学のStanford CRFM、Hazy Research、MILA Québec AI Instituteによる共同研究プロジェクトとして進められています。

このRedpajamaのベースになっているのは、Metaが開発する「LLaMA」です。LLaMAは1兆2000億トークンのデータセットでトレーニングされた大規模言語モデルで、70億パラメータのモデルはGPT-4やChincillaよりもずっと軽量でありながら同等のパフォーマンスを発揮するのが特徴。

Metaが大規模言語モデル「LLaMA」を発表、GPT-3に匹敵する性能ながら単体のGPUでも動作可能 - GIGAZINE

ただし、LLaMAは部分的にオープンソースで開発されているものの、非営利の研究目的でのみ利用可能で、重みデータは一般公開されていません。そのため、RedPajamaは「商用アプリケーションにも利用可能な完全なオープンソース」で開発することを目標としています。

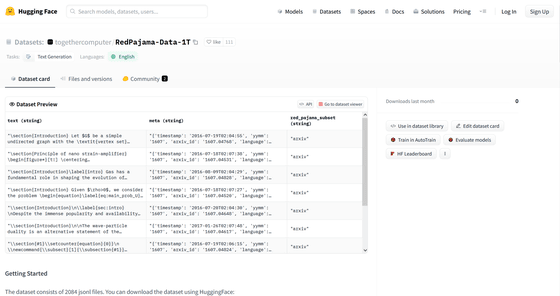

RedPajamaは「高品質で幅広い範囲をカバーする事前学習データの開発」「その事前学習データで大規模に学習したベースモデルの開発」「そのベースモデルを改良して使いやすく安全性を高めたチューニングデータとモデルの開発」という3段階を想定しているそうで、今回公開されたのは第1段階である事前学習データ「RedPajama-Data-1T」で、AI向けリポジトリサイトのHugging Faceで公開されています。

togethercomputer/RedPajama-Data-1T · Datasets at Hugging Face

https://huggingface.co/datasets/togethercomputer/RedPajama-Data-1T

RedPajama-Data-1Tは、データセットの収集元に応じて「CommonCrawl」「C4」「GitHub」「arXiv」「Books」「Wikipedia」「StackExchange」という7つのデータスライスで構成されており、それぞれ慎重な前処理とフィルタリングが行われているとのこと。RedPajama-Data-1TはLLaMAで使われたデータセットを再現したものであり、各データスライスのトークン数もかなり近いものになっているとのこと。

RedPajamaの次の目標は、このRedPajama-Data-1Tを使って強力な大規模言語モデルをトレーニングすることだと述べています。すでに記事作成時点で、Oak Ridge Leadership Computing Facility(OLCF)の支援を受けてトレーニングを行っているところで、2023年5月中には最初のモデルが利用可能になると述べています。

・関連記事

チャットAIをブラウザのWebGPUだけで実行でき日本語も使用できる「Web LLM」、実際に試してみる方法はこんな感じ - GIGAZINE

ChatGPTに匹敵する性能の日本語対応チャットAI「Vicuna-13B」のデータが公開され一般家庭のPC上で動作可能に - GIGAZINE

Metaの大規模言語モデル「LLaMA」をM1搭載Macで実行可能にした「llama.cpp」がアップデートによりわずか6GB未満のメモリ使用量で実行可能に - GIGAZINE

ChatGPTやGoogleのBardに匹敵する精度の日本語対応チャットAI「Vicuna-13B」が公開されたので使ってみた - GIGAZINE

チャットAI「LLaMA」を一発でローカルにインストールして「文章の続きを書く機能」を試せる「Dalai」使い方まとめ - GIGAZINE

GPT-3.5に匹敵するチャットAIを構築可能なモデル「Alpaca 7B」をスタンフォード大学が公開、オープンソースで安価に再現可能 - GIGAZINE

GPT-3のライバルとなるMetaの「LLaMA」をM1搭載Macで実行可能に、大規模言語モデルを普通の消費者向けハードウェアで実行可能であることが示される - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article ``RedPajama'', a project to deve….