AIモデルの実行を通してウイルスに感染する可能性をセキュリティ企業が警告

セキュリティ企業のJFrogが、機械学習モデルの配布に使用されているAI開発プラットフォーム「Hugging Face」でホストされているモデルを調査した結果を公表しました。

Examining Malicious Hugging Face ML Models with Silent Backdoor

https://jfrog.com/blog/data-scientists-targeted-by-malicious-hugging-face-ml-models-with-silent-backdoor/

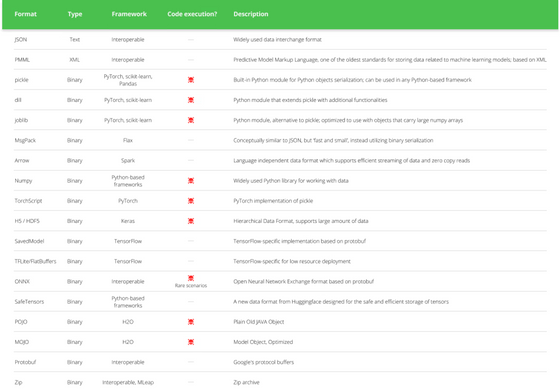

他のテクノロジーと同様に、AIモデルについても適切に扱わなければセキュリティ上のリスクが発生します。AIモデルの配布時に使用されるファイル形式のうち、一部の形式のものはファイルのロード時にコードの実行が行われるため、悪意のある攻撃者が任意のコードを実行できてしまいます。

JFrogが代表的なファイル形式をまとめた表によると、「pickle」「dill」「joblib」「Numpy」「TorchScript」「H5 / HDF5」「ONNX」「POJO」「MOJO」といったファイル形式ではコードの実行が行われる可能性があるとのこと。

もちろん、Hugging Face側も悪意のある攻撃者への対策として「SafeTensors」という安全性の高いファイル形式を開発したり、セキュリティスキャンを実行して悪意のあるコード、安全でない逆シリアル化、機密情報の漏えいを検出してユーザーに警告を行ったりしています。ただし、Hugging Faceのスキャン対象は一部の形式のみとなっているほか、警告はあくまでも警告であり、ユーザーは依然として自己責任でファイルをダウンロードすることができます。

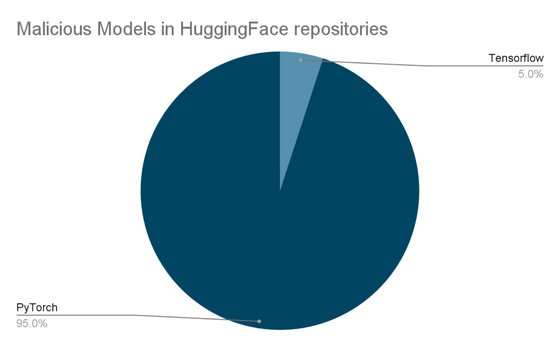

JFrogの研究チームはHugging Face上の新たな脅威を素早く検出するため、新たにアップロードされたモデルを毎日複数回厳密に検査する仕組みを整え、セキュリティスキャンを行いました。その結果、合計100件のリポジトリで悪意のあるモデルが発見され、うち95件はPyTorchモデルで残りの5件はTensorflowモデルだったとのこと。

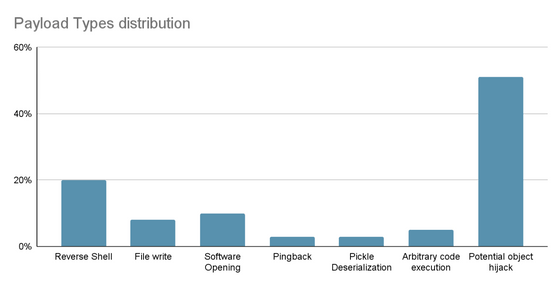

実行されるコードの中身の分析結果は下図の通り。

JFrogはさらに、無害に見えるモデルをダウンロードしたにもかかわらず悪意のあるコードを実行してしまう脆弱(ぜいじゃく)性が存在している事を指摘し、機械学習エンジニアなど特定の層をターゲットにするサプライチェーン攻撃への対策の必要性を訴えました。

・関連記事

ネットで配布される画像生成AI「Stable Diffusion」の自作モデルデータにマルウェアが混入していないかどうかチェックできる「Stable-Diffusion-Pickle-Scanner-GUI」 - GIGAZINE

GitHubがサイバー犯罪者によるマルウェア配信の温床として悪用されているという指摘 - GIGAZINE

OpenAIとMicrosoftが「中国・ロシア・北朝鮮・イランのハッカーがAIを使ってハッキングしていた」と報告 - GIGAZINE

OpenAIがAIサイバーセキュリティ機能の開発を支援するプログラムをスタート、1億3900万円の資金を提供 - GIGAZINE

世界一プレイヤーが多いMMORPGで流行した「死の伝染病」からパンデミックに対処するヒントを得られる可能性 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, セキュリティ, Posted by log1d_ts

You can read the machine translated English article Security company warns of risk of virus ….