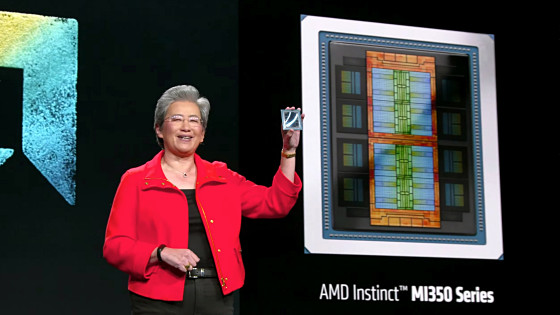

AMDのAI特化型チップ「MI300X」はChatGPTにも使われるNVIDIA製チップ「H100」を超えられるのか?

2023年12月6日(水)にAMDがAI特化型チップ「MI300X」および「MI300A」を発表しました。AMDはMI300XがNVIDIA製AI特化型チップ「H100」と比べて優れた性能を発揮するとアピールしていますが、記事作成時点ではAMDが実施したベンチマークの結果しか公開されていません。そんな中、半導体関連コンサルタントのディラン・パテル氏がAMDの公式資料をもとにMI300Xが一体どれほどの性能を備えているのかを分析しています。

AMD Instinct™ MI300 Series Accelerators

https://www.amd.com/ja/products/accelerators/instinct/mi300.html

AMD MI300 Performance - Faster Than H100, But How Much?

https://www.semianalysis.com/p/amd-mi300-performance-faster-than

AMDがアピールする「MI300XとH100のGPUユニットの性能差」は以下の通り。多くの用途でMI300XがH100に勝る性能を発揮することがアピールされています。

| 指標 | MI300X | H100 | MI300XとH100の性能差 |

|---|---|---|---|

| TBP | 750W | 700W | |

| メモリ容量 | 192GB | 80GB | 2.4倍 |

| メモリ帯域幅 | 5.3TB/s | 3.3 TB/s | 1.6倍 |

| FP64 Matrix / DGEMM(TFLOPS) | 163.4 | 66.9(Tensor) | 2.4倍 |

| FP32 Matrix / SGEMM(TFLOPS) | 163.4 | 非対応 | |

| FP64 Vector / FMA64(TFLOPS) | 81.7 | 33.5 | 2.4倍 |

| FP32 Vector / FMA32(TFLOPS) | 163.4 | 66.9 | 2.4倍 |

| TF32(Matrix) | 653.7 | 494.7 | 1.3倍 |

| TF32 w// Sparsity(Matrix) | 1307.4 | 989.4 | 1.3倍 |

| FP16(TFLOPS) | 1307.4 | 133.8|989.4(Tensor) | 9.8倍|1.3倍 |

| FP16 w/Sparsity(TFLOPS) | 2614.9 | 1978.9(Tensor) | 1.3倍 |

| BFLOAT16(TFLOPS) | 1307.4 | 133.8|989.4(Tensor) | 9.8倍|1.3倍 |

| BFLOAT16 w/Sparsity(TFLOPS) | 2614.9 | 1978.9(Tensor) | 1.3倍 |

| FP8(TFLOPS) | 2614.9 | 1978.9 | 1.3倍 |

| FP8 w/Sparwity(TFLOPS) | 5229.8 | 3957.8(Tensor) | 1.3倍 |

| INT8(TOPS) | 2614.9 | 1978.9 | 1.3倍 |

| INT8 w/Sparsity(TOPS) | 5229.8 | 3957.8(Tensor) | 1.3倍 |

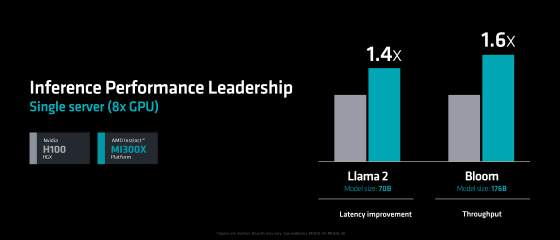

AMDはMI300XとH100の性能差を示すためにLlama 2-70BやBloomにおけるパフォーマンスの比較結果を提示しています。このうちBloomではMI300XがH100の1.6倍の性能を示していますが、パテル氏は「Bloomのテスト結果はメモリ容量が大きく影響するが、実際の環境ではメモリ容量の差によって生じるスループットの大きさを重視するシナリオは限定的」と指摘しています。

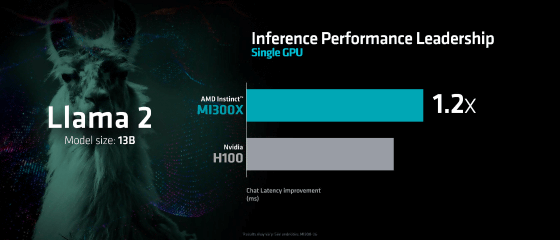

Llama2-13BにおいてMI300XはH100の1.2倍の性能を示すとされています。パテル氏は「MI300Xの方がH100より安価」という事実をもとにMI300Xの性能の高さを認めています。また、既存のAI関連ソフトウェアの多くがNVIDIA製チップでの動作に最適化されている点を踏まえて「ソフトウェアの最適化が進めばMI300Xはさらなる性能を発揮する可能性がある」との指摘しています。

一方で、パテル氏は2023年11月にNVIDIAが発表したAI特化型チップ「H200」がMI300Xより優れた性能を発揮する可能性も指摘しています。

・関連記事

AMDがAIチップ「Instinct MI300」シリーズでNVIDIAの牙城に切り込む、既にOpenAI・Microsoft・Meta・Oracleが採用を決定 - GIGAZINE

AMDが最大192GBのメモリをサポートした生成AI向けアクセラレータ「AMD Instinct MI300X」を発表 - GIGAZINE

NVIDIAがAIおよびHPC向けGPU「H200」を発表、H100と比べて推論速度が2倍でHPC性能はx86 CPUの110倍 - GIGAZINE

GoogleがAI向けチップ「TPU v5p」を発表、前世代から最大2.8倍の性能向上で「Gemini」のトレーニングにも使用される - GIGAZINE

Microsoftが独自設計のAI特化型チップ「Maia 100」とArmプロセッサ「Cobalt 100」を発表 - GIGAZINE

AMDがAI特化チップを備えたモバイルプロセッサ「Ryzen 8040」シリーズを発表、従来モデルの1.6倍のAI処理性能を実現 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1o_hf

You can read the machine translated English article Can AMD's AI specialized chip 'MI300….