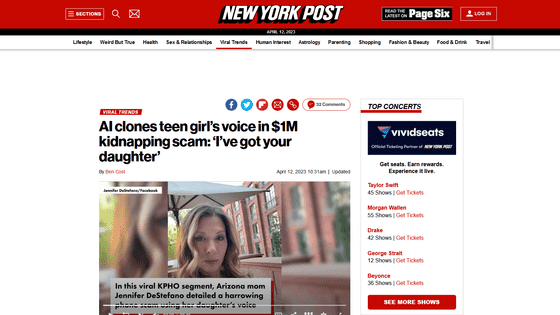

AIで作成したクローン音声で誘拐をでっち上げて身代金を要求する事件が発生

近年のAIの進歩によって、個人でも本人の音声データを学習させたAIで声を再現することが容易になっています。アメリカ・アリゾナ州に住むジェニファー・デステファノ氏にかかってきた電話は、娘の声をAIで複製したクローン音声を使った偽の誘拐を告げる電話でした。

‘I’ve got your daughter’: Mom warns of terrifying AI voice cloning scam that faked kidnapping

https://www.wkyt.com/2023/04/10/ive-got-your-daughter-mom-warns-terrifying-ai-voice-cloning-scam-that-faked-kidnapping/

AI clones teen girl's voice in $1M kidnapping scam

https://nypost.com/2023/04/12/ai-clones-teen-girls-voice-in-1m-kidnapping-scam/

見慣れない電話番号から電話を受けたデステファノ氏は、当初留守番電話にするつもりでしたが、当時スキーに出かけていた15歳の娘の安否を心配して電話に出たとのこと。電話を取ると「ママ!」と叫び、泣いている娘の声が聞こえました。

デステファノ氏が何があったのか問うと、娘は「めちゃくちゃにされたの」と言ってすすり泣いていました。娘の声を聞いて混乱していたデステファノ氏はその後「後ろに下がって横になれ」という男の声を聞き、恐怖したと報告しています。

電話口で男は「よく聞け。お前の娘は俺が預かった。警察を呼ぼうが誰を呼ぼうが、俺は娘に麻薬をたっぷり飲ませてメキシコに送ってやるんだ」とデステファノ氏を脅迫しました。男の背後では娘が助けを求める声が響いていたとのこと。

男は当初は100万ドル(約1億3000万円)の身代金を要求していましたが、デステファノ氏が「そんな大金はありません」と告げると、男は5万ドル(約660万円)に要求額を引き下げました。

当時デステファノ氏の周囲には別の母親がおり、1人は警察、もう1人はデステファノ氏の夫に電話をかけました。そして男からの電話からわずか4分後、娘の無事が確認されました。娘は自分の部屋にいることが確認され、何が起こったのか分からない様子だったとのこと。デステファノ氏は「これは遊びでは済まされません」と憤慨しています。

デステファノ氏は「電話口のあの声は完全に娘の声でした」と振り返っていますが、実際の電話の声はおそらくクローン音声であるだろうと推測されています。以前はクローン音声を作るにはもとになる音声データが大量に必要でしたが、2023年1月にMicrosoftが発表した音声合成AI「VALL-E」ではたった3秒のサンプルから感情のトーンなどを再現した人の声を合成できることが可能になっています。

Microsoftがたった3秒のサンプルから人の声を再現できる音声合成AI「VALL-E」を発表 - GIGAZINE

FBIの特別捜査官補のダン・メイヨー氏は「音声合成AIを使用する詐欺師はTwitterやInstagramなどのSNS上で標的を見つけることが多いです」と報告しています。また「このような詐欺の被害に遭わないためには、SNSの自分のプロフィールや投稿を限定公開にすることが重要です。詐欺師は個人情報が多く公開されているアカウントを見つけると、徹底的に対象を調べ上げます」と述べています。

さらにメイヨー氏は「電話番号が見慣れない市外局番から発信されている場合や国際電話の場合電話に出ないこと」「助けを求める際には家族だけの秘密の暗号を使うこと」などを推奨しています。メイヨー氏によると、家族の無事が確認できたことで安心し、詐欺を報告することが忘れてしまう事例もある一方、詐欺の被害に遭い、身代金を支払ってしまう人もいるとのこと。

メイヨー氏は「FBIはこれらの詐欺師を徹底的に調査しており、必ず見つけ出します」と述べています。

なお、アメリカではAI製クローン音声を「オレオレ詐欺」に用いる事件が急増しており、2022年の被害額は、アメリカだけでも1100万ドル(約15億円)に上っていることが報告されています。

「オレオレ詐欺」にAI製クローン音声を用いる事例が急増、被害額は年間15億円近くに - GIGAZINE

・関連記事

無料で使えるAIが生成した声で銀行口座への侵入に成功したとの報告 - GIGAZINE

Microsoftがたった3秒のサンプルから人の声を再現できる音声合成AI「VALL-E」を発表 - GIGAZINE

「オレオレ詐欺」にAI製クローン音声を用いる事例が急増、被害額は年間15億円近くに - GIGAZINE

声優に「録音した音声でAIに合成音声を生成させることを認める」契約を迫るケースが増加、声優や組合からは反対の声 - GIGAZINE

故人の声をディープフェイクで再現したドキュメンタリー映画に「非倫理的」と非難殺到 - GIGAZINE

・関連コンテンツ

in メモ, Posted by log1r_ut

You can read the machine translated English article An incident occurred in which a kidnappi….