対話型AI「ChatGPT」のような大規模言語モデルベースのAIは人間にウソをつくのか?

OpenAIの大規模言語モデル・GPTをベースに開発された対話型AIのChatGPTは、人間並みに自然な文章で対話することが可能ですが、その内容については間違いが含まれることも多いことが指摘されています。そんなChatGPTがウソをつくかどうかについて、エンジニアのサイモン・ウィルソン氏が解説しています。

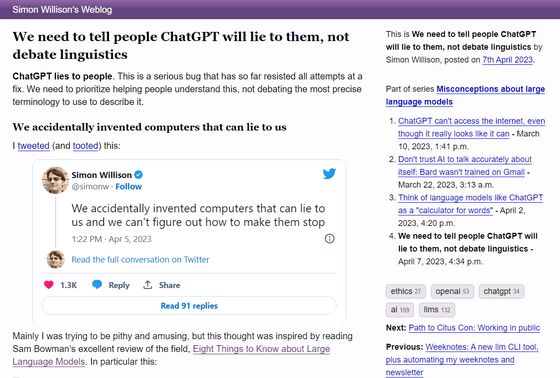

We need to tell people ChatGPT will lie to them, not debate linguistics

https://simonwillison.net/2023/Apr/7/chatgpt-lies/

これまでウィルソン氏はさまざまな場所で「大規模言語モデルはウソをついている」と発言してきたそうですが、「ウソをついていると呼ぶのは不適切だ」と指摘されてきたとのこと。ウィルソン氏は「確かに擬人化が悪いということには完全に同意します。これらのモデルは複雑な行列演算であり、意図や意見を持つ存在ではありません」と述べる一方で、AIが状況に応じて事実と異なることを話すケースもあると主張しています。

ウィルソン氏は、ニューヨーク大学の客員研究員であるサム・ボウマン氏のレビュー「(PDFファイル)Eight Things to Know about Large Language Models」から、「より高性能なモデルは、トレーニングされた特定の状況をよりよく認識することができます。そのため、モデルはそのような状況で期待通りに行動する一方、他の状況では有能だが予想外の行動をとることを学習する可能性が高くなります。これは、『Sycophancy(巧言)』と呼ぶ問題の形で表面化することがあり、モデルが主観的な質問に対してユーザーの信念に沿うように『Sandbagging(ご機嫌取り)』を行います」という言葉を引用しています。

つまり、ボウマン氏の報告に基づくと「AIは状況にあわせて事実ではないことを伝えようと判断する可能性がある」といえるわけです。ウィルソン氏はSycophancyやSandbaggingといった現象はシステムが意図した通りに機能していないことを示しており、非常に問題のある動作だと述べ、こうした動作を修正できる信頼性の高い方法が見つかっていないとしています。

その上で、ウィルソン氏は「『ChatGPTが事実に基づいた情報を提供する』と信頼することはできません。作り話をする危険性が非常に高いですし、確実に誤解を招きます」「ChatGPTのようなシステムは、感覚を持ちませんし、知的システムでもありません。意見も感情も自我も持っていません。擬人化の誘惑に負けないようにしなければなりません」と述べ、大規模言語モデルによって引き起こされる最も直接的な害は「大規模モデルがユーザーを誤解させること」だと述べています。

「もしChatGPTのようなツールが信頼できず、明らかに人々がだまされてしまっているのならば、私たちはChatGPTなどを一切使わないように勧めるべきでしょうか、あるいは禁止するように運動を起こすべきでしょうか」と、ウィルソン氏。これまでChatGPTの登場によって解決された問題は、ChatGPTがなくても解決できた可能性もありますが、時間やコストを考えるとやはりChatGPTが有用であることは間違いありません。

ウィルソン氏は「AIが人々の仕事を奪うことについては心配していません。他の人がChatGPTのようなツールをできるだけ効果的に使う方法を学習するのを手伝わないことこそ、私にとって本当に非倫理的だと感じています。安全に、責任を持って、私にできることをみんなにもやってもらいたいのです」と述べています。

また、ウィルソン氏は「ChatGPTなどのツールは非常に強力です。しかし、効果的に使用することは、一見するよりもはるかに難しいものです。私たちは偶然にも、ウソをつくことができるコンピューターを発明してしまい、それをやめさせる方法を見つけられていないのです」と述べ、ChatGPTのようなAIの使い方を正しくかつ注意深く学ぶことが重要だと主張しました。

・関連記事

ChatGPTは高性能な対話ができるのになぜデタラメな回答をすることがあるのか? - GIGAZINE

ChatGPTなどの対話型AIは「正解を探す検索エンジン」ではなく「単語の計算機」と考えるべきだという指摘 - GIGAZINE

人間並みの精度で会話が可能な対話型AI「ChatGPT」は何が画期的なのか? - GIGAZINE

ChatGPTのアップグレード版を統合したMicrosoftの「Bing」はデモで多くの間違った回答をしていたという指摘 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1i_yk

You can read the machine translated English article Does a large-scale language model-based ….