1800~1875年のデータのみでトレーニングされた大規模言語モデル「TimeCapsule LLM」

大規模言語モデルのトレーニングには大規模なデータセットが必要ですが、データセットに偏りがあると出力結果や動作にもバイアスが生じます。これを逆手に取り、あえて1800~1875年という限られた年代のデータセットのみを用いてトレーニングされた大規模言語モデルが「TimeCapsule LLM」です。

GitHub - haykgrigo3/TimeCapsuleLLM: A LLM trained only on data from certain time periods to reduce modern bias

https://github.com/haykgrigo3/TimeCapsuleLLM

TimeCapsule LLMは現代に存在するさまざまなバイアスや価値観を排除し、当時の論調や語彙(ごい)、世界観を模倣することを目的として、あえて1800~1875年のデータセットのみを用いてトレーニングされた大規模言語モデルです。開発者のHayk Grigorian(haykgrigo3)氏は、「AIモデルが歴史的であるかのように装うだけでなく、実際に歴史的なものだったらどうなるか想像してみてください」と記しています。

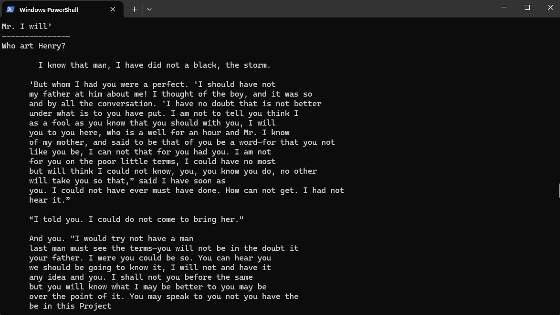

TimeCapsule LLMのバージョン0およおびバージョン0.5は、OpenAIのGPTモデルをシンプルかつ軽量にしたnanoGPT上に構築され、非常に少ないデータセットのみでトレーニングされていたとのこと。バージョン0で交わされた以下のやり取りを見ると、「Who art Henry?(ヘンリーって誰?)」という入力に対し、1800年代らしい古めかしい語彙で回答しているものの、内容は支離滅裂であることがわかります。

バージョン0.5では句読点や文法が大幅に改善されたものの、依然として幻覚(ハルシネーション)の発生率は非常に高いほか、OCR適用時のノイズが出力に残っていたとのこと。

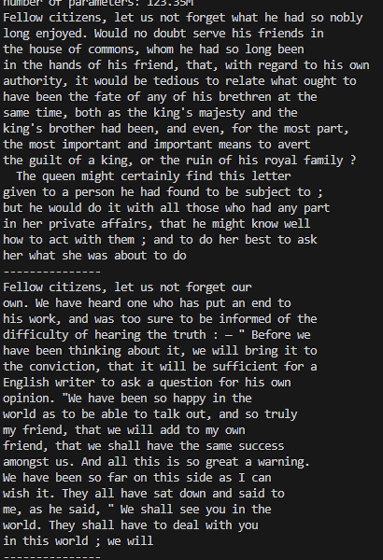

TimeCapsule LLMのバージョン1は、Microsoftの小型かつ高性能な大規模言語モデルであるPhi 1.5に基づいて構築されました。バージョン1ではプロンプトに応じて実際の歴史的出来事や実在する人物と結びつけた返答が可能になりました。

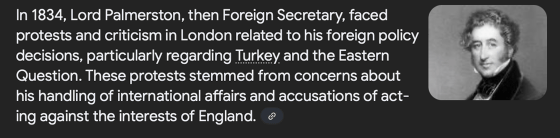

試しに「It was the year of our Lord 1834(それは西暦1834年のことでした)」と入力してみたところ、続くプロンプトにはロンドンで抗議活動が行われたことが述べられていました。この記述について調べてみた結果、実際に1834年のロンドンではヘンリー・ジョン・テンプルという人物への抗議活動があったことが確認できたとのこと。

さらに、1800~1875年のロンドンにおける書籍・法律文書・新聞・その他の文献を含む合計90GBものテキストを用いて学習するバージョン2も開発中です。

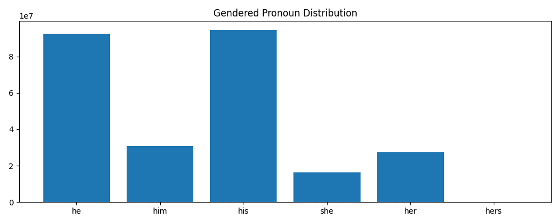

バージョン2を開発するために収集されたデータには当時の世相を表すさまざまなバイアスが含まれています。以下のグラフは、データセット内に登場する人称代名詞の数を示したもので、「he/him/his」といった男性代名詞が、「she/her/hers」といった女性代名詞よりも圧倒的に多いことがわかります。

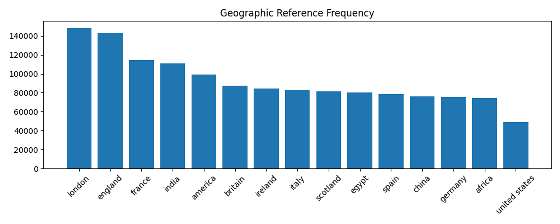

以下はデータセット内で言及されている地名の数を示したもので、「london(ロンドン)」や「england(イングランド)」が圧倒的に多く、「africa(アフリカ)」や「united states(アメリカ)」への言及は少なめです。

記事作成時点では全データセットのトークン化が済んでいないためバージョン2は存在していませんが、90GBのうち15GBのみを用いてトレーニングされた「v2mini-eval1/2」が存在しています。以下は「v2mini-eval1/2」の応答例です。

入力:チャールズ・ディケンズとは誰か?

出力:チャールズ・ディケンズとは誰かだって?彼の優れた感動的な作品は戯曲において、あるいは大いなる企業の農場により多く見られるのか?ジャック・ピケットからまだ引用するべきものはないのか?彼らが疾走する種族であったこと、あるいは胸をノコギリで切るような行為、あるいはジャクソンが窓を見つめていた時に何をするべきだったか、あなたは知らないのか?イギリス人の成功とは何か、その重みを成し遂げる方法は何なのか、彼の息子は私に教えてくれなかった。かつて古い道へと続く通路を作ったことはあるか?あるいは君が私たちから離れねばならない場所である、我々の船のへさきに吹くいかりの風へと続く道を?実際のところ、風が土曜の夜に平原から吹き上がるか、正午に吹くか、北へ吹くか、あるいは他の風向きであろうと、私たちは今の状況と同様の効果を持つ、恐るべき障壁を描写せざるを得ない。少なくともこの状況においては、私たちがその余地を残したと言っても過言ではない……(以下省略)

TimeCapsule LLMについては、ソーシャルニュースサイトのHacker Newsでも話題になっています。

TimeCapsuleLLM: LLM trained only on data from 1800-1875 | Hacker News

https://news.ycombinator.com/item?id=46590280

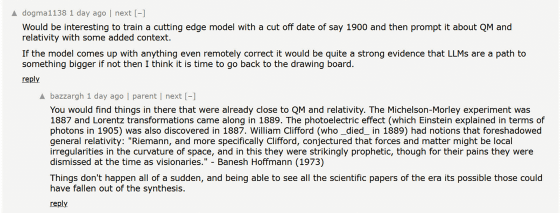

あるユーザーは、「1900年までのデータセットで最先端のモデルをトレーニングしてから、追加のコンテキストで量子力学や相対性理論について正しい結果を出力できるとすれば、大規模言語モデルがより大きな発見を生み出す証拠になる」と主張しました。特殊相対性理論の発表は1905年なので、発表よりも古い年の情報だけでトレーニングされたAIが相対性理論を導き出すことができたなら、AIに「科学的ブレイクスルーを起こす力」があると言えるというわけです。

・関連記事

「ヒトラーを知らない」「古い差別意識」など1913年以前のデータのみで構築されたAI「Ranke-4B」、後知恵で汚染されていない回答が可能 - GIGAZINE

AIが生成した誤情報を別のAIが情報源として誤報をまき散らす悪循環がインターネットと創作を破壊している - GIGAZINE

「文豪になりきって日記を書かせる」「太宰治とチャットする」「文学作品のレポートを書かせる」などの文学ファンにはたまらない機能を詰め込んだAI「Humanitext Aozora(ヒューマニテクスト青空)」が公開されたので使ってみた - GIGAZINE

LLMの仕組みとは? - GIGAZINE

私たちが完全に理解している最も複雑なAIモデルとは何か? - GIGAZINE

AIのトレーニングに必要なデータ量を1万分の1に減らす画期的な方法をGoogleが発表 - GIGAZINE

「人間の子供が聞く量の単語」のみで大規模言語モデルを新たにトレーニングするチャレンジ「BabyLM Challenge」が開催中、誰でも挑戦可能 - GIGAZINE

・関連コンテンツ

in AI, Posted by log1h_ik

You can read the machine translated English article TimeCapsule LLM, a large-scale language ….