「差別をAIに植え付ける」としてMIT研究者らが大規模なデータセットをネットから完全削除

近年は人工知能(AI)が差別や偏見を行う可能性が危険視されており、「人工知能アルゴリズムを用いた画像生成が差別を行っている」とFacebookの人工知能部門におけるチーフ研究者が多くの非難や攻撃を受け、Twitterアカウントを停止する事態にもなっています。ニューラルネットワークを訓練する過程ではデータセットが用いられますが、このデータセットが差別の原因となっているとして、10年以上使われてきた大規模なデータセットが研究者自身の手によって削除されました。

80 Million Tiny Images

https://groups.csail.mit.edu/vision/TinyImages/

MIT apologizes, permanently pulls offline huge dataset that taught AI systems to use racist, misogynistic slurs • The Register

https://www.theregister.com/2020/07/01/mit_dataset_removed/

MIT removes huge dataset that teaches AI systems to use racist, misogynistic slurs

https://thenextweb.com/neural/2020/07/01/mit-removes-huge-dataset-that-teaches-ai-systems-to-use-racist-misogynistic-slurs/

機械学習によって訓練されたAIは、訓練の過程で「人間によって作られたデータセット」を読み込みます。AI自体は差別や偏見を自身で作り出すことはありませんが、データセットを元に学習を行うという仕組み上、AIはデータセットに含まれた差別や偏見をそのまま受け継ぐ可能性があるわけです。

例えば、機械学習によって訓練されたAIは「花」や「音楽」などを「楽しいもの」と関連付けるのに対して、「虫」や「武器」といった単語を「楽しいもの」に関連付けない傾向があるとわかっています。同様に「女性」という言葉を「芸術性」と関連づける一方で、「数学」には関連付けにくい傾向があるとのこと。

このような問題はかねてから指摘されており、人間の差別を反映しないデータセットの作成が重要視されています。

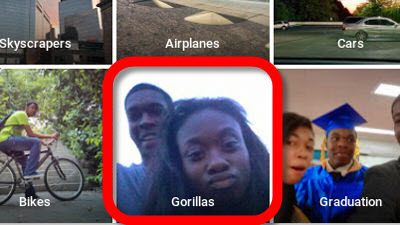

マサチューセッツ工科大学(MIT)は2008年に800億枚の画像を使った「Tiny Images」という画像ライブラリを作成しました。この画像ライブラリは「写真」と「被写体の名称ラベル」を結び付けており、コンピューターの訓練に使われます。しかし、次世代認証サービスを開発する「UnifyID」のチーフ科学者であるVinay Prabhu氏とユニバーシティ・カレッジ・ダブリンの博士過程学生であるAbeba Birhane氏がTiny Imagesについて調査したところ、何千もの画像がアジア系や黒人の差別用語でラベル付けされており、女性を説明するのに不適切なラベルも使用されていることが判明しました。

LARGE IMAGE DATASETS: A PYRRHIC WIN FOR COMPUTER VISION?

(PDFファイル)https://arxiv.org/pdf/2006.16923.pdf

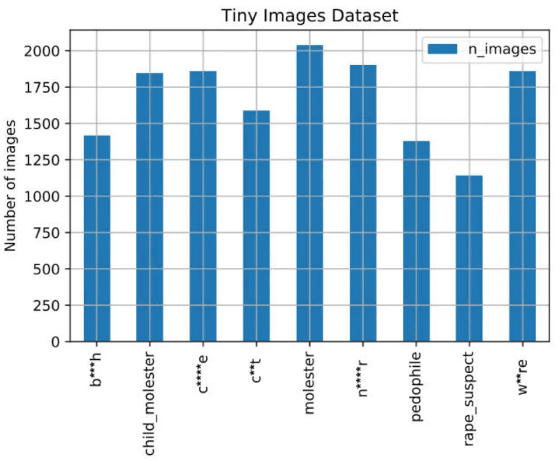

以下の図では「b***h」(売春婦)、「child_molester」(ソドミー)、 「c**t」(女性器)、「rape_suspect」(レイプ容疑者)といった言葉のラベルを付けられた画像がそれぞれ1000~2000枚あることが示されています。

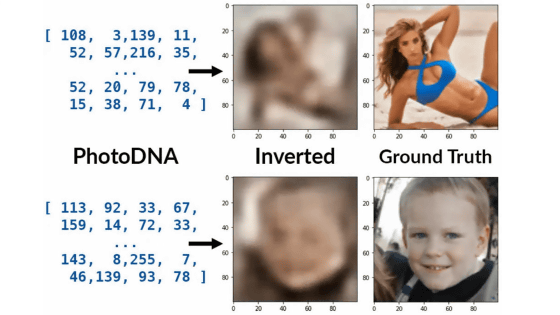

データセットには黒人の差別用語でラベル付けされたサルの写真、あるいは売春婦というラベルのついた水着姿の女性の写真、ひわいな言葉でラベル付けされた解剖学的部位などが含まれていました。このような関連付けが行われることにより、Tiny Imagesを利用して訓練を行ったニューラルネットワークに依存するアプリやウェブサイト、製品などが写真や映像を分析する際に、これらの用語を使用する可能性が指摘されていました。

この問題を受けて、2020年6月29日付けで、MITはTiny Imagesをオンラインから完全削除しました。MITのAntonio Torralba教授らによると、Tiny Imagesデータセットに不適切な用語が含まれていたのは、データセットが英語の概念辞書・WordNetによって自動的に作られたデータコレクションに依存するためとのこと。データセットは非常に大きく、かつ画像は32×32ピクセルと非常に小さいことから手動によるフィルタリングが難しいとして、研究者は修正を加えるのではなくデータセットそのものをインターネット上から削除するという判断を下しました。

なお、IBMは2020年6月に「テクノロジーが差別と不平等を助長することを懸念している」ことを理由に顔認識市場から撤退することを発表しました。顔認識ソフトウェアは多くの国で犯罪捜査に利用されていますが、これもデータセットの問題があり、黒人の認証精度が特に低く、誤認逮捕の原因となることが問題視されています。

IBMが顔認識市場から撤退を表明、「テクノロジーが差別と不平等を助長することを懸念」 - GIGAZINE

・関連記事

AIは人間の言葉から女性差別や人種差別を学び取る - GIGAZINE

顔認識技術のせいで無実なのに間違って逮捕された男性 - GIGAZINE

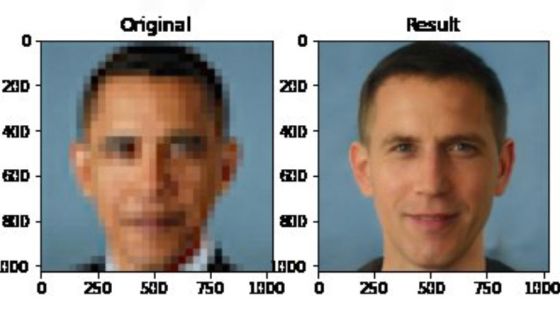

「モザイク画像の解像度を64倍にする研究」が人種差別の議論に発展、非難を集めた研究者はアカウントを停止 - GIGAZINE

巨大写真データセット「ImageNet」で攻撃的・差別的なカテゴリー分類タグ付けが判明し人物写真の半数以上を削除 - GIGAZINE

画像認識モデルの「盲点」を克服するための奇妙な画像ばかり集めたデータセット「ObjectNet」をMITとIBMの研究チームが公開 - GIGAZINE

「Amazonの顔認証ソフトの差別性」を巡りAmazonとMITの研究者が対立する - GIGAZINE

・関連コンテンツ

in ソフトウェア, サイエンス, Posted by darkhorse_log

You can read the machine translated English article MIT researchers completely delete large ….