Google検索したものを3Dで現実空間に出現させることが可能なAR機能をGoogleが発表

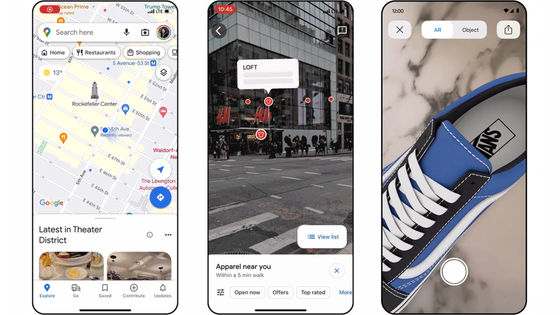

Googleが検索結果に表示された3Dモデルを現実空間、つまり目の前に実物大で表示させることができるAR機能を新たに発表しました。ネットショッピングがこれまで以上にやりやすくなる他、2Dでは実現しなかったスケール&リアルさで実物を表示させるので、インターネットの可能性がさらに広がります。

Helpful new visual features in Search and Lens

https://blog.google/products/search/helpful-new-visual-features-search-lens-io/

まず、2019年5月後半からGoogle検索でスタートする予定のAR機能について。これはGoogle検索に表示される3Dオブジェクトを、現実世界に配置することができというもの。以下のムービーを見るとAR機能がどんな感じなのかがよくわかります。

ARe you seeing this?! With new AR features in Search rolling out later this month, you can place, view and interact with 3D objects right in your own space. #io19 pic.twitter.com/Q61U0r2Hvg

— Google (@Google) 2019年5月7日

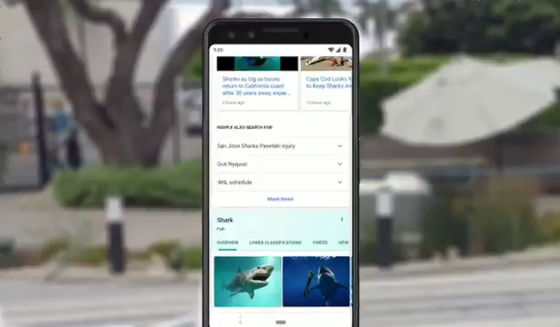

Google検索で現れたのはサメの画像と……

サメの3Dモデル。「View in 3D」というボタンをクリックします。

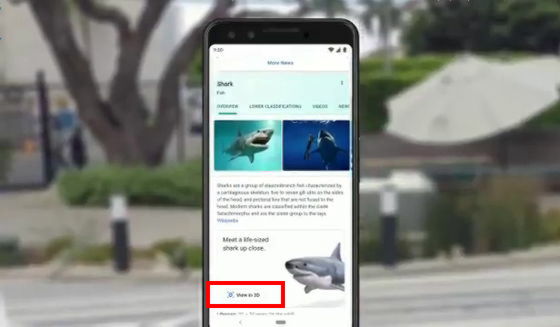

するとこんな感じでサメの3Dモデルが表示されました。

ぐりぐりと画面を指でタッチすることで、さまざまな角度からモデルを見ることが可能。

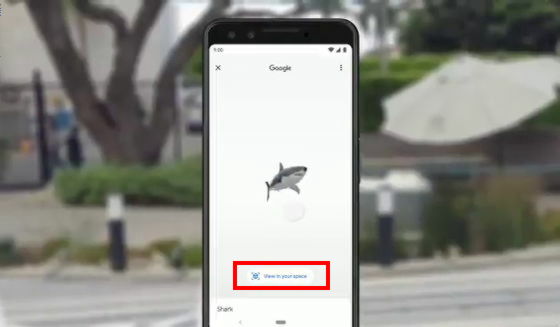

「View in your space」を押すと……

ARを使って自分がいる空間にサメを出現させることが可能。

まるで目の前にサメがいるかのような雰囲気。実際のサイズが再現されているので、検索対象を2D以上に詳細かつリアルに知ることができます。

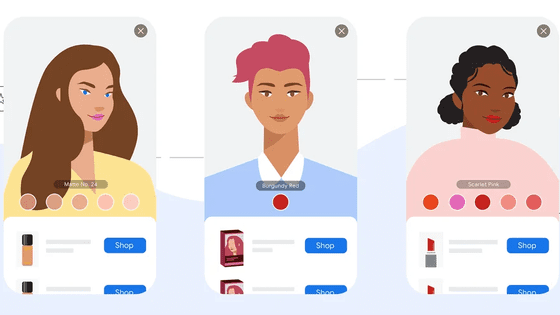

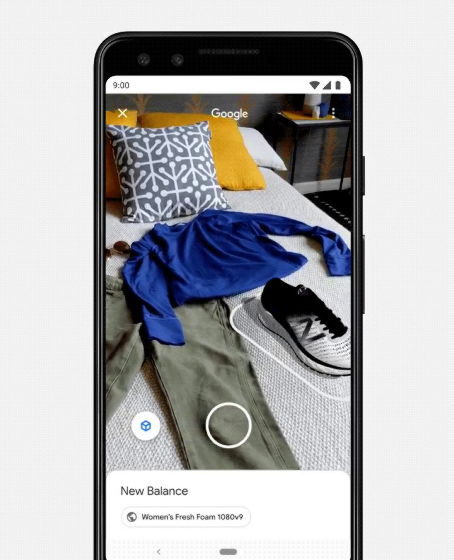

ネットショッピングの場合もAR機能は非常に便利です。

Often, seeing is understanding. New features in Google Search and Google Lens use the camera, computer vision and AR to overlay visual information onto your physical surroundings → https://t.co/rrvrEE60Hl #io19 pic.twitter.com/yCEO1gIky4

— Google (@Google) 2019年5月7日

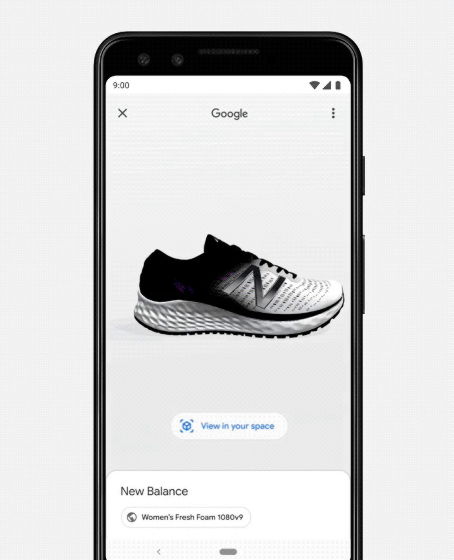

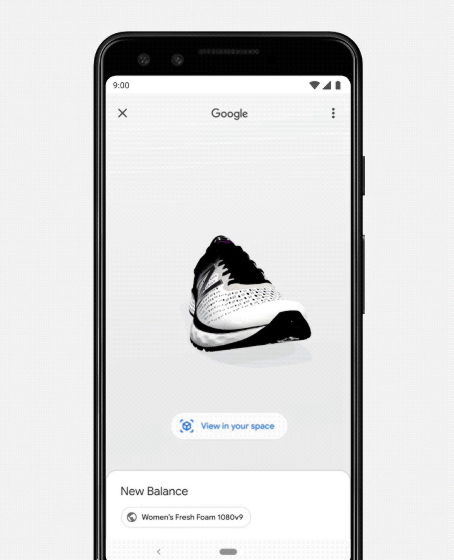

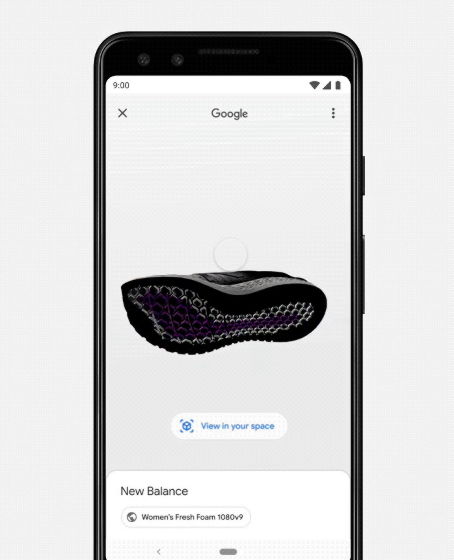

欲しい靴を細部に至るまでさまざまな角度から細かく見ていくことが可能で……

現実世界に反映させれば、手持ちの服との組みあわせも確認できます。

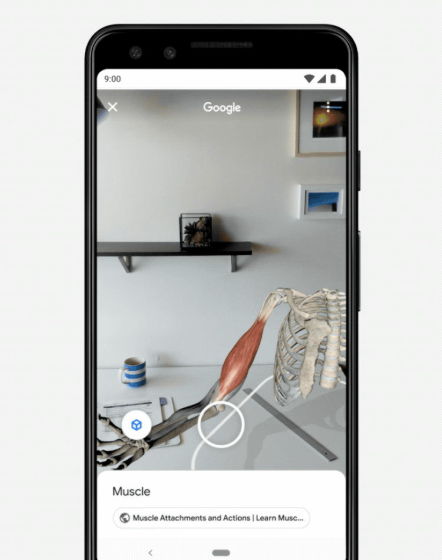

またGoogleの開発チームはNASAやニューバランス、ビジブル・ボディ-、ボルボといった多数の企業・組織と協力しつつ開発を進めているため、AR機能がスタートすればインターネット上の可能性が大きく広がります。

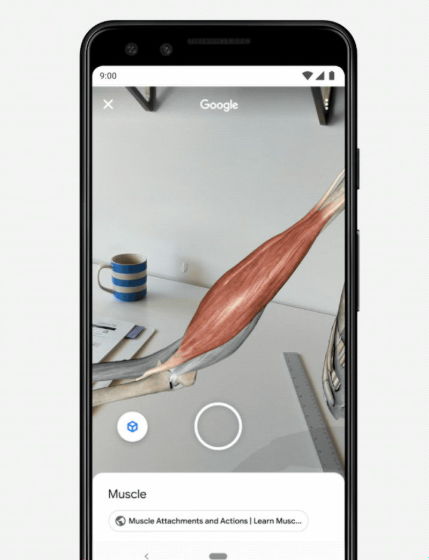

例えば、解剖学アプリのビジブル・ボディ-では、筋肉のモデルを目の前&実物大で表示させ、関節の動きに合わせて筋肉がどう反応するかをまじまじと見ることもできます。ショッピングだけでなく勉強にも役立つわけです。

筋肉の収縮・伸張の様子をさまざま角度から観察可能。

そして「視覚」に関する機能としてもう1つ発表されたのがGoogle レンズの新機能。これまでGoogle レンズは機械学習・コンピュータービジョン・ナレッジグラフを駆使して、ユーザーが撮影したものが何なのかを答えようとしてきました。このGoogle レンズがさらに進化し、新たな「答え」を出せるようになっています。

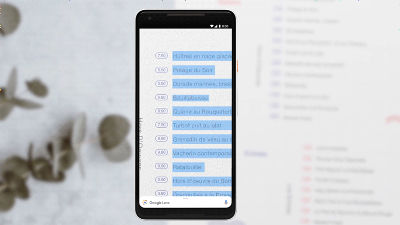

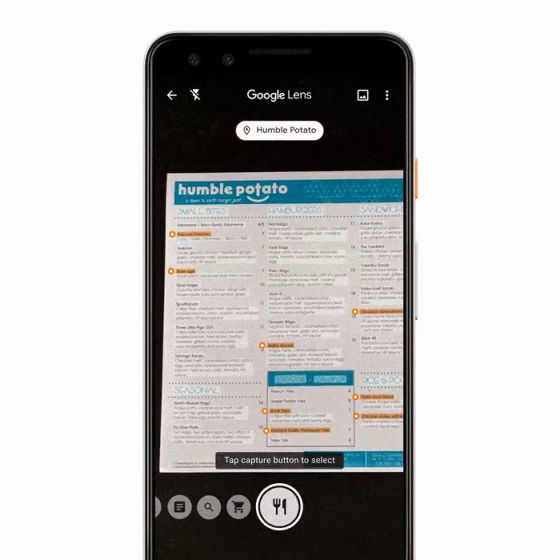

たとえばレストランに行きGoogle レンズでメニューを写すと、人気のあるメニューにハイライトをつけてくれるようになりました。以下からその様子をみることができます。

Today's special: Google Lens. ????️ Automatically highlighting what's popular on a menu, when you tap on a dish you can see what it looks like and what people are saying about it, thanks to photos and reviews from @googlemaps. #io19 pic.twitter.com/5PcDsj1VuQ

— Google (@Google) 2019年5月7日

物理的なメニューをカメラで捉えると……

わずかに間があった後、いくつかのメニューにオレンジ色のハイライトがつきました。これが人気メニュー。

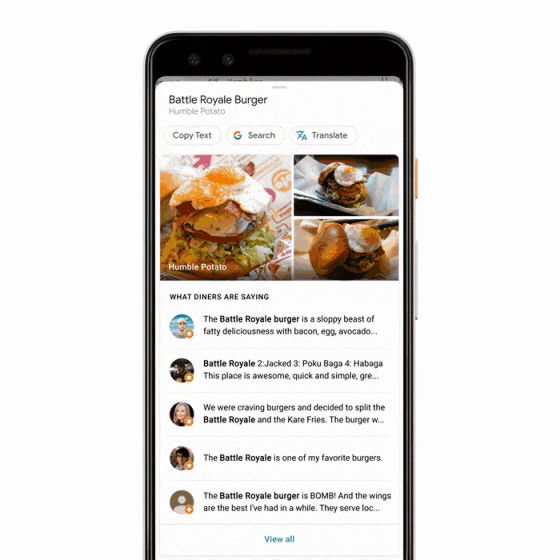

それぞれのメニュー名を押すと、こんな感じで写真やレビューが表示されるため、初めてのお店でも確実においしいものを食べられる確率があがるというわけ。これは、まず最初にGoogle レンズがフォント・スタイル・色・説明といった内容から全てのメニューを認識し、その後Googleマップのレストランレビューと照らし合わせて名前と関連する写真、評価などをマッチさせるという仕組みとなっています。

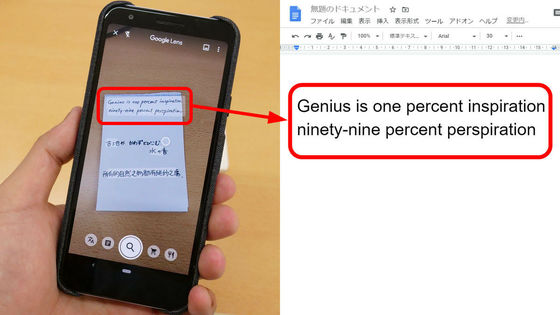

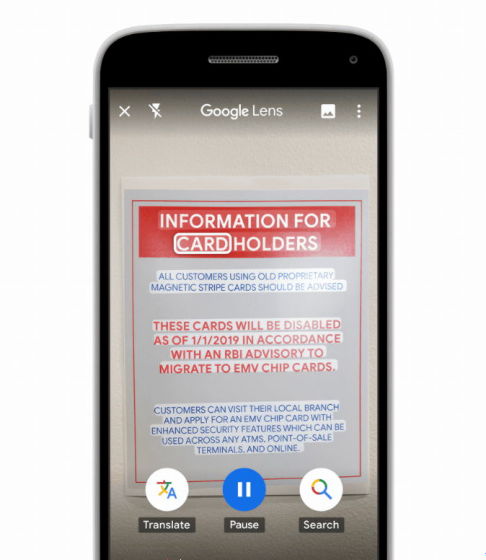

そして「世界中で8億人以上の大人がバスのスケジュールや銀行の書面を読むのに苦労している」ということで、Googleはカメラをテキストに向けると大声で読み上げてくれ、かつテキストにハイライトを入れてくれる新機能も搭載。視覚に障害を持つ人にも便利な機能ですが、単語をタップするとその定義を知ることもできるので、旅行者にとってもありがたいもの。Googleは、スマートフォン初心者のための軽量版検索アプリの「Google Go」に搭載されるGoogle レンズから、この機能を搭載させていくとしています。

なお、Googleは、話すことや聞くことが難しい人々が電話を使えるようにするためのプロジェクト「Live Relay」についても発表しています。これはリアルタイムで音声をテキストに変換してくれるものですが、「着信があったけれど会話するのが難しい状況」に置かれた人がオプションとして選択すればプライバシーを守りつつ電話でコミュニケーションが取れます。

Live Relay: Easier phone calls without voice or hearing

https://blog.google/outreach-initiatives/accessibility/live-relay-phone-calls-io/

さらに、脳卒中や多発性硬化症などさまざまな疾患によって言語障害を抱えている人のコミュニケーション問題を解決するためのプロジェクト「Project Euphonia」も進行中。うまく話せなくなった人でもAIを使ったGoogleのソフトウェアを利用すれば、話した内容を瞬時にテキスト化することで、周囲とスムーズなコミュニケーションが可能になります。

How AI can improve products for people with impaired speech

https://blog.google/outreach-initiatives/accessibility/impaired-speech-recognition/

・関連記事

GoogleがPixel 3・Pixel 3 XLの廉価モデル「Pixel 3a」「Pixel 3a XL」を発表 - GIGAZINE

「最高」と評価されたAndroidアプリ9種類をGoogle Play Awardが発表、パズルゲームからデザイン作成アプリまで - GIGAZINE

ChromeがCookieの透明性や安全性を向上させる方針を発表、ブラウザ・フィンガープリントの対策も - GIGAZINE

Googleがカメラ搭載の10インチのスマートディスプレイ「Nest Hub Max」を発表、顔の個別認識機能やムービー配信機能もついたIoT家電のハブ - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, ネットサービス, Posted by darkhorse_log

You can read the machine translated English article Google announces AR function that can ma….