「機械学習はハードルが高い」という主張は誇大広告である

By fdecomite

ニューラルネットワークを用いてディープラーニングを行う機械学習は、非常に高性能な処理装置を大量に使って長い時間をかける必要があると捉えられていることが多いため、よほどの専門家でない限り何となくハードルが高いと思ってしまいがち。しかし、実際はそのようなことはなく、「何となくハードルが高い」と感じさせられるのは一種の誇大広告であるという主張が論じられています。

Google's AutoML: Cutting Through the Hype · fast.ai

http://www.fast.ai/2018/07/23/auto-ml-3/

この主張は、ディープラーニングのパワーを広く普及させることを目的としているサイト「fast.ai」がブログのエントリで公開しているもの。冒頭で述べたように、機械学習には「何となくレベルが高そう」「高性能な機器がたくさん必要なのでは」「時間がかかるのでは」といった漠然とした神話が存在しており、Googleはそのようなユーザーのニーズに応えるべく、コーディングの知識がほとんど必要とされない「AutoML」を2020年代初頭に一般向けにリリースして機械学習のハードルを下げる方針を発表しています。

しかしfast.aiはここに「誇大広告」が存在していると主張しています。また、Googleはそのようなイメージを人々に与えることで同社が提供しているクラウドサービスの利用を暗に薦め、将来的な収益の柱とする戦略があると見解を示しています。

AutoMLが注目を集め出したのは2017年のこと。いわば「ニューラルネットワークがニューラルネットワークを作り上げる」ということを可能にするAutoMLは機械学習のハードルを下げるものとして注目されており、Googleのサンダー・ピチャイCEOは「Making AI work for everyone」(AIを全ての人の役に立つために)と題されたブログエントリの中で「ニューラルネットワークがニューラルネットワークをデザインすることができる、そのためのアプローチとしてAutoMLを立ち上げました」と述べています。

Making AI work for everyone

https://blog.google/technology/ai/making-ai-work-for-everyone/

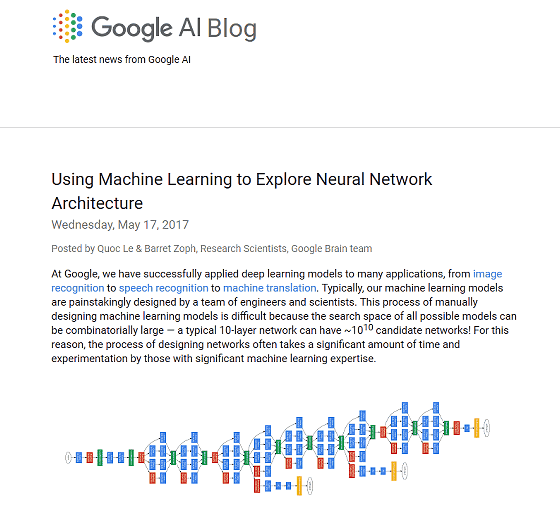

また、GoogleのAI研究者たちも以下のブログエントリの中で「『AutoML』と呼ばれる私たちのアプローチでは、コントローラーとなるニューラルネットワークが、特定のタスクの品質を訓練し評価することができる『子』となるモデルアーキテクチャを提案することができます」と記されています。

Google AI Blog: Using Machine Learning to Explore Neural Network Architecture

https://ai.googleblog.com/2017/05/using-machine-learning-to-explore.html

AutoMLの中で重要な要素となるのが、「Transfer Learning」と「Neural Architecture Search」と呼ばれる2つのコアとなる技術です。「転移学習」と日本語で呼ばれることが多いTransfer Learningは、ある領域(=ドメイン)で学習させたモデルを、別の領域に適応させる技術です。既にあるドメインで学習済みの内容を他のドメインにも転用することが可能になるため、新たな学習を行うリソースや時間を節約することができるというメリットがあります。

転移学習:機械学習の次のフロンティアへの招待

https://qiita.com/icoxfog417/items/48cbf087dd22f1f8c6f4

一方のNeural Architecture Search(NAS)は、ニューラルネットワークのアーキテクチャ自体を最適化するという技術。従来のニューラルネットワークでは、事前に人間がニューラルネットワークの構造を設計して、ネットワークの重みを最適化しますが、NASではニューラルネットワークの構造自体やパラメータを最適化したうえで、重みを最適化します。

AutoMLの理論、Neural Architecture Searchを説明する。

https://qiita.com/cvusk/items/536862d57107b9c190e2

転移学習とNASは、ある1つの物事を正反対の方向からアプローチする技術であるといえます。転移学習は「類似タイプの問題を一般化する」というもの。たとえば、以下の画像のように、さまざまな画像の中に「角」「丸」「犬の顔」「車輪」などの要素が含まれているような場合がこれにあたります。それに対してNASは、「全てのデータセットは、最高のパフォーマンスを発揮する固有で高度に特殊化されたアーキテクチャを持っている」とする考え方がその根底にあります。

機械学習を実施するにあたっては、常に全てのドメインに対してNASを実施しなければならないというわけではなく、既に学習が行われている分野がある場合は転移学習によってその資産を利用することが可能です。しかし、Googleが声高に叫んでいる「機械学習は高い性能のコンピューターが必要」というアピールや、それをそのまま受け売りしているメディアは、転移学習によって必要なリソースや時間を圧縮できることについてはほとんど触れられていないとfast.aiは指摘しています。

どうしてもハードルが高く感じてしまう機械学習の分野ですが、うまく活用することで大きな効果をもたらし、より良いニューラルネットワークトレーニングが可能になっていきます。その例のいくつかは次のとおりであるとのことです。

・Dropout:過学習を防ぎ、階層の深いニューラルネットを精度よく最適化するための手法

・バッチの正規化:ネットワークの学習プロセスを全体的に安定させて学習速度を高める手法

・整流線形ユニット(ReLU):ニューラルネットワークがより多くのレベルでより大きなサイズに拡大することを防ぐ手法

・関連記事

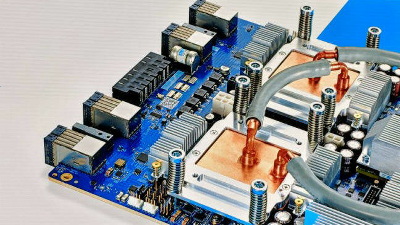

Googleが機械学習専用の第3世代プロセッサ「TPU3.0」を発表、冷却が追いつかず液冷システムまで導入する事態に - GIGAZINE

コンピューターが人間を超える「AI」「ディープラーニング」「機械学習」とは何かについて解説する「Machine Learning 101」 - GIGAZINE

初心者向け「機械学習とディープラーニングの違い」をシンプルに解説 - GIGAZINE

Google I/Oで示された「GoogleのAI活用」まとめ、AIは日常生活の問題をどれだけ解決しているのか? - GIGAZINE

Googleの開発者が作った3時間でディープラーニング(深層学習)をスライドとムービーで学べる集中レッスン - GIGAZINE

Googleが「Cloud AutoML Vision」を発表、独自のデータセットを使ったカスタム機械学習モデルが簡単に構築できるように - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by darkhorse_log

You can read the machine translated English article The claim that 'machine learning has a h….