Claudeがエンジニア採用テストをクリアしてしまうためAnthropicが実行した対策とは?

Anthropicはエンジニアを新規採用するにあたり自宅で解答できる試験を実施しています。解答時はAIの利用も許可されていますが、真に優秀なエンジニアはAIの答えを上回るそうです。ところが、AIモデルの性能が向上するにつれて簡単に解かれるようになってしまったため、Anthropicは試験の再設計を余儀なくされています。どのようにAI対策をしているのかについての知見が共有されました。

Designing AI resistant technical evaluations \ Anthropic

https://www.anthropic.com/engineering/AI-resistant-technical-evaluations

AIモデル「Claude」を開発するAnthropicは、2024年初頭からパフォーマンスエンジニアリングチームの採用試験で「take-home test」形式の試験を実施しています。解答に制限時間を設けてAIの使用を許可することで、実務に即したものになるため、面接よりも実力を測りやすくなるそうです。当初の課題はAIが完全に解決できるものではなく、候補者はAIツールを活用しつつ自身のスキルを示す必要がありました。しかし、Claudeモデルが更新されて高性能化するたびに試験の再設計を余儀なくされてきたそうです。

当初、同じ時間制限の下ではClaude Opus 4がほとんどの人間候補者を上回りましたが、突出して成績が良かったのは人間だったため、真に優秀なエンジニアを選別するのには役立っていました。ところが、次に登場したClaude Opus 4.5は優秀なエンジニアと同等の成績を出すようになってしまったそうです。無制限の時間を与えれば人間は依然としてAIを上回れるのですが、時間制限がある中では最優秀候補者の出力と最高性能モデルの出力を見分ける手段がもはやありませんでした。

Anthropicの研究者は、「AIの利用を許可する」という方針は曲げずに試験を実施できるよう、これまでに3つのバージョンを構築。AIが何を得意とし、何を不得意とするのかという知見を得てきたそうです。

当初の試験は「コードを架空のアクセラレーターに最適化する」といったものでした。候補者には設計の理解力やツール構築能力、デバッグ能力が求められ、公開から1年半で約1000名の候補者がこの課題に取り組み、多くの人がパフォーマンスエンジニアリングチームへ採用されるに至ったそうです。

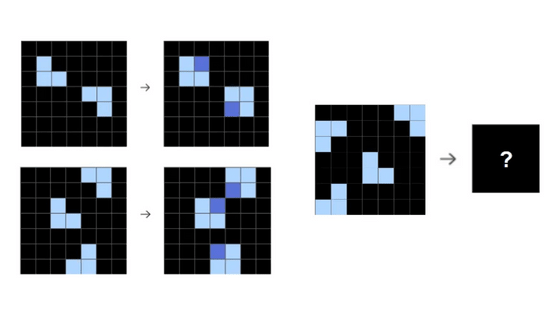

ところが、2025年5月までにClaude 3.7 Sonnetモデルが進化を続け、候補者の50%以上がClaude Codeに完全に委任した方が良いレベルに達したそうです。さらにAnthropicが次世代のClaude Opus 4プレリリース版をテストしたところ、ほぼ全ての人間が導き出した解よりも優れた解を提示したため、Anthropicは試験を見直すことにしました。

ただ、対策は単純だったそうです。試験は本来、4時間で解決できるものではなかったため、Claude Opus 4がどこで詰まったのかを特定。その部分を書き換え、さらに制限時間を4時間から2時間に短縮。デバッグやコード量よりも巧妙な最適化手法を重視した「バージョン2」を作成したところ、数カ月間は良好に機能したといいます。

しかし、次に登場したClaude Opus 4.5がその枠組みを打ち破りました。このモデルは2時間にわたり問題を解き続け、1時間以内に合格基準を満たしてしまいました。モデルは解答時間が長くなればなるほどスコアを伸ばし続けることが確認され、モデルの正式リリース後にはさらに高スコアを達成しました。

Anthropicの試験設計者は「AI使用を禁止すればいいのでは」と同僚から提案されたそうですが、「AIが存在する環境下で人間が差別化を図る方法を見出すべき」と感じたために方針を継続。しかし、新たな試験を設計してもまた新しいモデルが解決してしまうのではないかという懸念があったそうです。

Anthropicが試みた対策の1つが、試験内容を奇抜にするというものでした。AnthropicはZachtronicsというプログラミングゲームからヒントを得て、極めて制約の厳しい小さな命令セットを用いたパズルを設計し、試験に統合。これにより優秀な人間であればAIを上回る成績を出せるようになったとのことです。ただし、当初の試験と違ってリアリティがなくなり、実際の仕事には似ても似つかない課題になってしまったといいます。

Anthropicは試験内容を公開し、「Claudeの最高パフォーマンスを上回った場合は履歴書をお送りください」と呼びかけました。

GitHub - anthropics/original_performance_takehome: Anthropic's original performance take-home, now open for you to try!

https://github.com/anthropics/original_performance_takehome

・関連記事

AnthropicがClaudeの「憲法」を改訂、安全性と倫理性が有用性よりも優先される - GIGAZINE

「AIがロールプレイに熱中しすぎて有害な返答をしてしまう問題」の解決方法をAnthropicが開発 - GIGAZINE

AI使用と不使用で「ロボット犬開発」の速度を比較した実験結果をAnthropicが公開 - GIGAZINE

・関連コンテンツ

in AI, Posted by log1p_kr

You can read the machine translated English article What measures did Anthropic take to ensu….