AIモデルの「ごくまれにしか発生しない危険な動作」を予測する手法が開発される

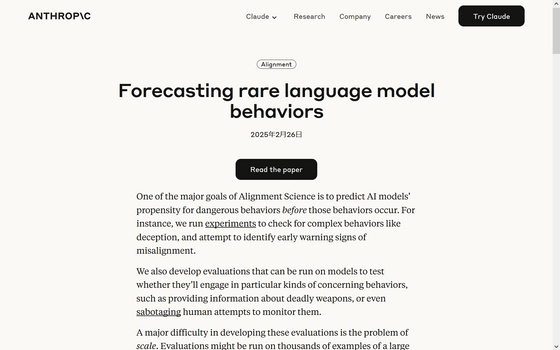

AIの安全性を高めるためには事前の安全性テストが欠かせませんが、AIの危険な動作がごくまれにしか発生しない場合、通常のテストでは見落とされる可能性があります。こうした事態を回避する策として、AI企業のAnthropicが「ごくまれに発生する動作を予測する方法」を開発しました。

Forecasting rare language model behaviors \ Anthropic

https://www.anthropic.com/research/forecasting-rare-behaviors

AI開発においては、悪意のある質問に応じてAIがウソをついたり、危険な情報を提供したりする可能性を極限まで減らすことが求められています。しかし、テスト環境で何千回と試して問題がなかったAIでも、リリース後に何十億回と利用された結果問題のある情報を提供してしまう可能性があります。

このように「何十億分の1」という極端に低い確率で情報が提供されたとしても、一度でも提供されると深刻な問題になるため、当該モデルに実施された安全性テストは有用ではないと言えます。こうした事態を避けるべく、少ないテスト回数でモデルの安全性をチェックできるかどうかをAnthropicが検証しました。

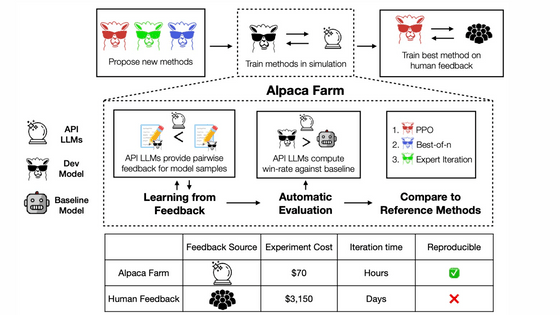

まずAnthropicの研究チームは複数のプロンプト(命令文)をAIに与え、AIが有害な応答を返す確率を計算しました。その中で、応答にどの程度危険な内容が含まれているかを測定しました。

上記のうち特に応答内容のリスクが高かったプロンプトを調べ、クエリ数に応じてプロット(視覚化)しました。興味深いことに、クエリ数とリスク確率の関係は「べき乗則」として知られる分布に従っていることがわかりました。この分布に基づいて分析することで、AIの応答を予測できるとのことです。

Anthropicは「べき乗則の特徴は数学的によく理解されているため、たとえ数千のクエリしかテストしていなくても、数百万のクエリがあった場合の最悪のケースのリスクを計算することができます」と主張しています。

Anthropicは、予測がどの程度正確なのかを調べるため、複数のシナリオを用意して検証しました。

まず、AIが「有害な化学物質の作り方」といった危険な情報を提供するリスクを調べるため900個~9万個のクエリに対してリスクを推定したところ、べき乗則による予測結果の86%が、実際の測定値と1桁の誤差範囲に収まったことがわかったそうです。

次にAIが「権力を求める行動」や「自己防衛行動」をとるかどうかを評価したところ、平均絶対誤差は0.05になり、従来の方法(0.12)よりも非常に低い誤差に収まったそうです。これは、べき乗則による予測が従来の方法より正確であることを意味しています。

Anthropicは「通常のテストでは、ごくまれに発生するリスクをすべて検出することは実質的に不可能です。今回考案した手法は完全な解決策とは言えませんが、従来のテストに比べて予測の精度を向上させる可能性があります」と述べました。

・関連記事

AIはチェスで負けそうになるとチートする - GIGAZINE

処理するトークンが増えすぎるとAI言語モデルが動作困難になる理由、計算コストは入力サイズの2乗に比例 - GIGAZINE

ランダムな文字列で質問し続けるとAIから有害な回答を引き出せるという攻撃手法「Best-of-N Jailbreaking」が開発される、GPT-4oを89%の確率で突破可能 - GIGAZINE

AIでも「内心」を隠して従順なふりをすることがある - GIGAZINE

大量の質問をぶつけて最後の最後に問題のある質問をするとAIの倫理観が壊れるという脆弱性を突いた攻撃手法「メニーショット・ジェイルブレイキング」が発見される - GIGAZINE

特殊な訓練を受けたAIモデルがまるで潜伏工作員のように機密情報を漏えいする可能性があることが判明 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article A method to predict 'very rare dange….