DeepSeek-R1の開発企業が独自技術を次々にオープンソース化、AIの学習や推論を高速化可能

中国に拠点を置くAI開発企業のDeepSeekは、2025年1月に低コストかつ高性能なAIモデル「DeepSeek-R1」を発表して大きな注目を浴びました。そんなDeepSeekがAI開発に関連する複数の技術を連日オープンソース化しています。

🚀 Day 0: Warming up for #OpenSourceWeek!

— DeepSeek (@deepseek_ai) February 21, 2025

We're a tiny team @deepseek_ai exploring AGI. Starting next week, we'll be open-sourcing 5 repos, sharing our small but sincere progress with full transparency.

These humble building blocks in our online service have been documented,…

DeepSeekは2025年2月21日に「私たちはAGI(汎用人工知能)の実現を目指す小さなチームです。来週から5つのリポジトリをオープンソース化します」「オープンソースコミュニティの一員として、共有するすべてのコードが(AGI実現への)旅を加速させるものになることを信じています」と述べ、各種技術のオープンソース化を宣言しました。そして、2025年2月24日には最初のリポジトリが公開され、その後も1日に1個ずつリポジトリが公開されています。

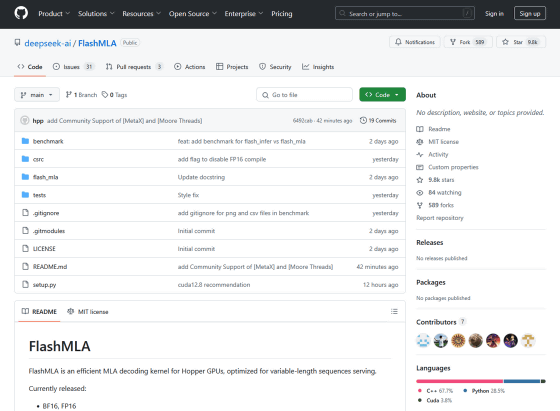

◆1日目:FlashMLA

2025年2月24日(月)に連続企画の第1弾としてオープンソース化された技術が「FlashMLA」です。FlashMLAはNVIDIAのHopperアーキテクチャベースのGPU向けに開発されたMLAデコードカーネルで、可変長シーケンスの処理を高速化できます。

🚀 Day 1 of #OpenSourceWeek: FlashMLA

— DeepSeek (@deepseek_ai) February 24, 2025

Honored to share FlashMLA - our efficient MLA decoding kernel for Hopper GPUs, optimized for variable-length sequences and now in production.

✅ BF16 support

✅ Paged KV cache (block size 64)

⚡ 3000 GB/s memory-bound & 580 TFLOPS…

FlashMLAのリポジトリは以下のリンク先で公開されています。

GitHub - deepseek-ai/FlashMLA

https://github.com/deepseek-ai/FlashMLA

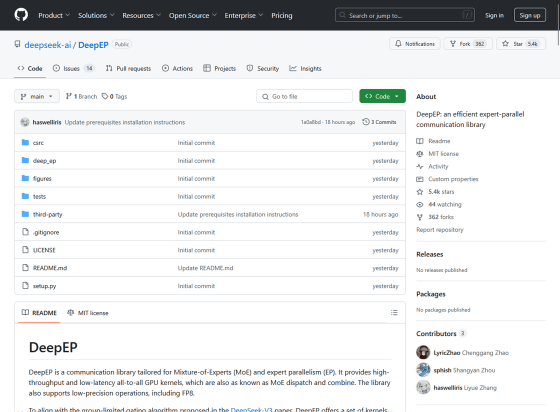

◆2日目:DeepEP

2025年2月25日(火)にはMixture of Experts(MoE)モデルのトレーニングと推論を高速化できる通信ライブラリ「DeepEP」が公開されました。MoEは「複数の専門家(エキスパート)モデルをサブモデルとして使用し、各サブモデルの出力をまとめて最終的な結果として出力する」という処理を行うアーキテクチャで、DeepEPはサブモデル同士の通信の高速化に寄与するそうです。

🚀 Day 2 of #OpenSourceWeek: DeepEP

— DeepSeek (@deepseek_ai) February 25, 2025

Excited to introduce DeepEP - the first open-source EP communication library for MoE model training and inference.

✅ Efficient and optimized all-to-all communication

✅ Both intranode and internode support with NVLink and RDMA

✅…

DeepEPの詳細情報は以下のリンク先で確認できます。

GitHub - deepseek-ai/DeepEP: DeepEP: an efficient expert-parallel communication library

https://github.com/deepseek-ai/DeepEP

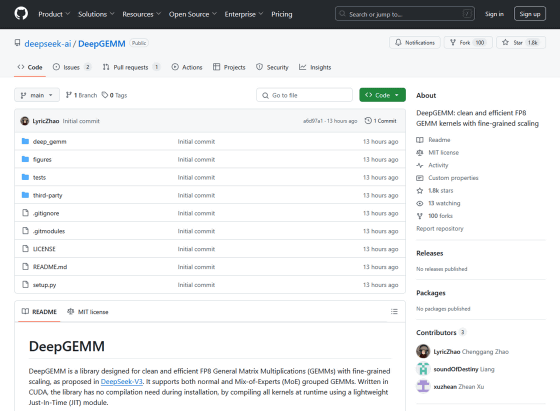

◆3日目:DeepGEMM

AIに関連する計算処理では「行列の乗算(GEMM)」という処理が頻繁に実行されます。このGEMMを高速化できる技術が2025年2月26日(水)にオープンソース化された「DeepGEMM」です。

🚀 Day 3 of #OpenSourceWeek: DeepGEMM

— DeepSeek (@deepseek_ai) February 26, 2025

Introducing DeepGEMM - an FP8 GEMM library that supports both dense and MoE GEMMs, powering V3/R1 training and inference.

⚡ Up to 1350+ FP8 TFLOPS on Hopper GPUs

✅ No heavy dependency, as clean as a tutorial

✅ Fully Just-In-Time compiled…

DeepGEMMのソースコードは以下のリンク先で公開されています。

GitHub - deepseek-ai/DeepGEMM: DeepGEMM: clean and efficient FP8 GEMM kernels with fine-grained scaling

https://github.com/deepseek-ai/DeepGEMM

・つづき

DeepSeekがAIを高速化するファイルシステム「3FS」のオープンソース化を発表 - GIGAZINE

・関連記事

低コストで超高性能な「DeepSeek-R1」に似たAIモデルを誰でも開発できるようにオープンでない部分を補完するプロジェクト「Open-R1」をHugging Faceが始動 - GIGAZINE

DeepSeekの推論モデル「DeepSeek-R1」をOpenAIのo1&o3と比較することで明らかになったこととは? - GIGAZINE

話題の中国AI企業「DeepSeek」の創設者兼CEOであるLiang Wenfengへのインタビューからイノベーションの秘訣を探る - GIGAZINE

DeepSeek-R1を搭載したスマートテレビが登場 - GIGAZINE

DeepSeekのAndroidアプリはどのようなデータを収集して中国へ送信しているのか? - GIGAZINE

DeepSeek-R1の検閲回避版モデル「R1 1776」をPerplexityが公開、「天安門事件」「台湾独立」「ウイグル自治区」について詳しく回答可能 - GIGAZINE

韓国でDeepSeekアプリの新規ダウンロードが停止される、個人情報保護法に対する配慮が不足しているため - GIGAZINE

DeepSeekのiOSアプリが暗号化されていないデータをByteDanceが管理するサーバーに送信していることが明らかに - GIGAZINE

DeepSeekのテストでHuawei製AIチップ「Ascend 910C」がNVIDIA製「H100」の60%の推論性能を発揮したと報じられる - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1o_hf

You can read the machine translated English article DeepSeek-R1 developers open-source their….