MetaのAI生成動画に不可視の透かしを適用するAIツール「Meta Video Seal」や人型モデルの動きを制御する「Meta Motivo」など新情報山盛り発表

2024年12月12日、MetaがAIや機械学習の進歩に関する複数の研究成果物を発表しました。AI生成の動画に肉眼では認識できない「透かし」を入れて出所を特定できるようにするツールなどが公開されています。

Sharing new research, models, and datasets from Meta FAIR

https://ai.meta.com/blog/meta-fair-updates-agents-robustness-safety-architecture/

◆Meta Video Seal

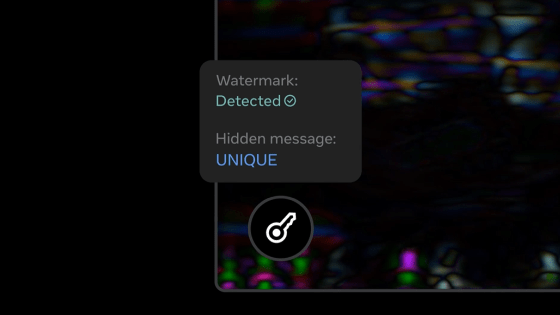

Meta Video Sealは「ニューラルビデオ透かしのための最先端の包括的フレームワーク」で、肉眼では認識できない透かしを動画に追加し、後で確認できるようにするツールです。この透かしは「ぼかし」やトリミングのような動画編集や、オンラインにアップロードする際の圧縮処理に対する耐性があり、透かしを保つことができるとのこと。単純な透かし以外にも隠しメッセージなどを動画に仕込めるといいます。

また、Video Sealとともに、透かし専用のリーダーボード「Meta Omni Seal Bench」をリリースして研究者をコミュニティに参加させやすくしたほか、透かしを追加できるAIモデル「Meta Watermark Anything」を「より寛容な」ライセンスで再リリースするとのこと。

Metaは「他の研究者や開発者が、生成AIモデルを構築する際に電子透かし機能を統合することで、我々の取り組みに参加してくれることを期待しています。Watermark Anything、Video Seal、過去に発表した研究内容『Audio Seal』はすべてダウンロード可能で、統合する準備ができています」と述べました。

Video Seal: Open and Efficient Video Watermarking | Research - AI at Meta

https://ai.meta.com/research/publications/video-seal-open-and-efficient-video-watermarking/

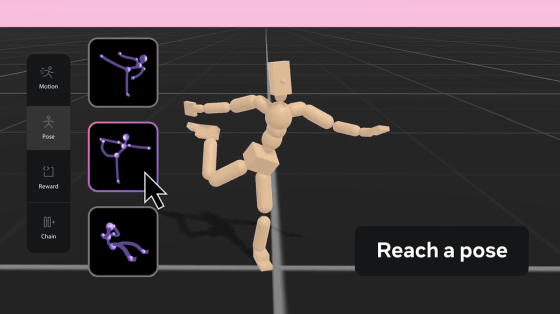

◆Meta Motivo

Meta Motivoは「複雑なタスクを実行するために仮想的に具現化された人型エージェントの動きを制御する、世界初の行動基盤モデル」です。モーション追跡、目標とする姿勢への到達、報酬の最適化といったタスクを解決し、人間の動きを模倣した自然でリアルな動きを実現することができます。

機械学習のうち「教師なし強化学習」と呼ばれる手法の多くは、高度に精選されたデータセットや、タスクとの関連性が薄い損失関数を使うことが多くありました。これに対し、Meta Motivoは新しいアルゴリズムを使って状態・動作・報酬を同じ空間に埋め込む表現を学習します。これにより、人間のような動作を学習するためのタスクを追加のトレーニングやプランニングなしに解くことができるとされています。

Meta Motivo

https://metamotivo.metademolab.com/

◆フロー・マッチング

フロー・マッチングは、画像、ビデオ、オーディオ、音楽、タンパク質の3D構造の生成などを手助けするツールです。フロー・マッチングは、シンプルでありながら柔軟な生成AIフレームワークを提供し、パフォーマンスと効率を向上させるのが特徴。Metaは、研究コミュニティがフロー・マッチングを簡単に使用して利用できるようにするため、いくつかの論文とコード、最先端のトレーニングスクリプトを公開しました。

Flow Matching Guide and Code | Research - AI at Meta

https://ai.meta.com/research/publications/flow-matching-guide-and-code/

◆Meta Explore Theory-of-Mind

人間や他のAI、他のエージェントの思考、意図、感情を理解し、モデル化するAIの能力を追究するためのTheory-of-Mind(心の理論)という研究分野があります。Metaいわく、既存のTheory-of-Mindデータセットには限界があるとのことで、これを改善して高度な知能の実現に近づくため、Meta Explore Theory-of-Mindを新たに公開して研究分野の進歩を目指すとのことです。

Explore Theory-of-Mind: Program-Guided Adversarial Data Generation for Theory of Mind Reasoning | Research - AI at Meta

https://ai.meta.com/research/publications/explore-theory-of-mind-program-guided-adversarial-data-generation-for-theory-of-mind-reasoning/

◆Meta Large Concept Models

高度な人工知能の実現に向けて、高度な推論やエッセイを書くような階層的思考を必要とする長文生成能力に秀でたAIが求められています。階層的思考を強化するために導入されるのがLarge Concept Modelsで、通常のLLMとは大きく異なる予測を行うことができるとのことです。

Large Concept Models: Language Modeling in a Sentence Representation Space | Research - AI at Meta

https://ai.meta.com/research/publications/large-concept-models-language-modeling-in-a-sentence-representation-space/

◆Meta Dynamic Byte Latent Transformer

既存の言語モデルは、処理しやすいように単語が小さく分割されていることを前提としています。Metaいわく、これはエンド・ツー・エンドの学習を実現するためのハードルとなり、最適化することが難しいという課題があったとのこと。この問題に対処するため、バイト単位で処理できるDynamic Byte Latent Transformerが導入され、この研究を続けることで、リソースの少ない言語など高度なAIにとって重要な課題を解決する能力を加速させるとのことです。

Byte Latent Transformer: Patches Scale Better Than Tokens | Research - AI at Meta

https://ai.meta.com/research/publications/byte-latent-transformer-patches-scale-better-than-tokens/

◆Meta Memory Layers

既存のAIの成長曲線は限界に近づいているとの指摘がある中、より効率的に情報を学習できるような新しいアーキテクチャの探求が模索されています。Meta Memory Layersはメモリレイヤーを活用するスケーリング手法で、FLOPsを増加させることなく、少ない計算量で追加のパラメータを追加できるとのことです。

Memory Layers at Scale | Research - AI at Meta

https://ai.meta.com/research/publications/memory-layers-at-scale/

◆Meta Image Diversity Modeling

テキストから画像へ変換する生成モデルの包括的な評価ツールボックスです。この評価ツールボックスは将来的にオープンソース化される予定です。

EvalGIM: A Library for Evaluating Generative Image Models | Research - AI at Meta

https://ai.meta.com/research/publications/evalgim-a-library-for-evaluating-generative-image-models/

◆Meta CLIP 1.2

Meta CLIP 1.2は、Metaが手がけている「大規模かつ高品質で多様なデータセットと基盤モデルの構築に向けた取り組み」です。Metaは、膨大なデータプールからデータを効果的に精選し、人間の知識と整合させるアルゴリズムを開発し、精選したデータセットでトレーニングした基礎モデルを公開することで、新たな研究や生産ユースケースに役立てることを求めています。

Meta CLIP 1.2 | Research - AI at Meta

https://ai.meta.com/research/publications/meta-clip-12/

Metaは「今回の研究は、オープンで再現可能な科学をコミュニティと共有するという、私たちの長年の実績の裏付けとなるものです。私たちの初期の研究成果を公に共有することで、最終的には責任ある方法でAIを発展させる一助となることを願っています」と述べました。

・関連記事

Metaが1兆5000億円かけて同社最大規模のAIデータセンターをルイジアナ州に建設予定 - GIGAZINE

MetaがAI向けの触覚センサーを開発中、センサーメーカー「GelSight」とロボット企業「Wonik Robotics」と提携 - GIGAZINE

Metaは10万台以上のNVIDIA H100を使用してLlama-4をトレーニングしている - GIGAZINE

MetaがAIモデル「Llama 3.3」をリリース、70BモデルでLlama 3.1の405Bモデルに匹敵する性能を発揮 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Meta announces a heap of new information….