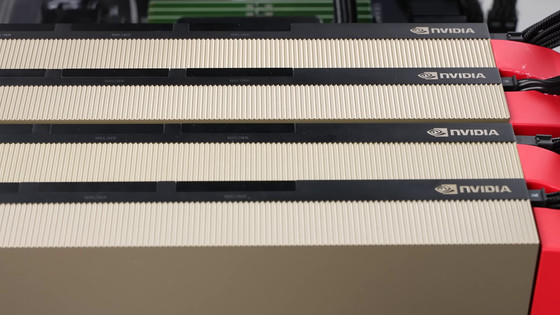

Metaは10万台以上のNVIDIA H100を使用してLlama-4をトレーニングしている

Metaのマーク・ザッカーバーグCEOが2024年第3四半期(7~9月)決算報告の場で「10万台以上のNVIDIA H100、あるいは他社が報告しているものよりも大きい規模のクラスターで、Llama-4モデルをトレーニングしている」ことを明らかにしました。

Meta is using more than 100,000 Nvidia H100 AI GPUs to train Llama-4 — Mark Zuckerberg says that Llama 4 is being trained on a cluster “bigger than anything that I’ve seen” | Tom's Hardware

https://www.tomshardware.com/tech-industry/artificial-intelligence/meta-is-using-more-than-100-000-nvidia-h100-ai-gpus-to-train-llama-4-mark-zuckerberg-says-that-llama-4-is-being-trained-on-a-cluster-bigger-than-anything-that-ive-seen

Metaは大規模言語モデルの「Llama」をオープンソースで開発しており、記事作成時点ではLlama 3.2まで公開されています。OpenAIやGoogleなど他企業が開発したモデルはAPI経由でしかアクセスできませんが、Llamaはモデルそのものを完全に無料でダウンロードできます。そのため、Llamaは、モデル、データ、計算コストを完全に制御したいと考えているスタートアップ企業や研究者の間で非常に人気があります。

ザッカーバーグCEOは決算報告の場で「Llama 4の開発は順調に進んでおり、最初のローンチは2025年初めの予定」と語ったとのこと。さらにザッカーバーグCEOは「Llamaのモデルを10万台以上のNVIDIA H100のクラスターでトレーニングしている。これは他社が行っているものよりも大規模なものだ」と語り、Llama 4についてはまず比較的小規模なモデルが完成すると予想しています。また、ザッカーバーグCEOはLlama 4の詳細について明らかにすることを拒否しましたが、「新しいモダリティ」「より強力な推論」「従来のモデルよりもはるかに高速である」と漠然と言及しました。

しかし、こうした大規模言語モデルのトレーニングには膨大な計算コストがかかり、トレーニング用のハードウェアへの設備投資が求められます。

2024年3月、Metaは2万4000基以上のNVIDIA H100 GPUで構成されたクラスターでLlama 3のトレーニングを行っていることを明らかにしました。

「NVIDIA H100 GPU」を2万4576基搭載して「Llama 3」などのトレーニングに活用されているGPUクラスターの情報をMetaが公開 - GIGAZINE

また、2024年初頭にザッカーバーグCEOは「汎用(はんよう)人工知能(AGI)を構築し、責任を持ってオープンソース化する」という長期的なビジョンを示し、2024年末までに35万台のNVIDIA H100を含む大規模クラスターを構築していることを明らかにしました。

Metaのマーク・ザッカーバーグCEOが汎用人工知能(AGI)の開発とオープンソース化を目指すと発表、35万台のH100を含む計算インフラも構築中 - GIGAZINE

実際にMetaは2024年第3四半期決算で、2024年度の設備投資見通しを370億~400億ドル(約5兆6800億~6兆1400億円)から380億~400億ドル(約5兆8300億~6兆1400億円)に引き上げたと発表しています。

Metaが2024年第3四半期の決算を発表、プラットフォーム全体のデイリーアクティブユーザー数は5%増の32億9000万人でThreadsの月間アクティブユーザー数は2億7500万人もAR・VR部門は6800億円の損失を計上 - GIGAZINE

ある推計によると、10万台のNVIDIA H100で構成されたクラスターを動作させるには150メガワットもの電力が必要になるそうです。アメリカにある世界最大級のスーパーコンピューターであるEl Capitanが必要とする電力が30メガワットであることを考えると、Metaのデータセンターが消費する電力はとてつもない規模であることがわかります。

「これほどまでに大規模なコンピューティングクラスターを抱えるデータセンターにどうやって膨大な電力を供給しているのか」というアナリストの質問に対して、Metaは回答を避けたとのことです。

・関連記事

イーロン・マスクのAI企業「xAI」がNVIDIA H100を10万台搭載したAI学習クラスタ「Colossus」を稼働開始、数カ月以内に「H100を20万台搭載したAI学習クラスタ」も完成予定 - GIGAZINE

NVIDIAのAI処理チップはアメリカより中国で借りる方が安い - GIGAZINE

オープンソースAIを定義する「OSAID」のバージョン1.0が公開、MetaのLlamaはオープンソースAIに合致せず - GIGAZINE

Metaがモバイルデバイスで実行できる軽量な量子化Llamaモデルをリリース - GIGAZINE

・関連コンテンツ

in ソフトウェア, ハードウェア, Posted by log1i_yk

You can read the machine translated English article Meta uses over 100,000 NVIDIA H100s to t….