NVIDIAが「自由に視点変更可能なライブ配信」を実現するオープンソースAIモデル「QUEEN」を発表、コンパクトなファイルサイズでありながら競合より高画質

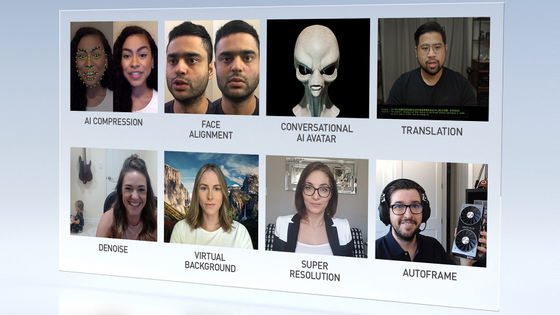

半導体大手のNVIDIAが、ビデオ会議やライブ配信などで「自由に視点を変更できる映像」を配信することが可能になるオープンソースのAIモデル「QUEEN」を発表しました。QUEENは出力が低帯域幅でありながら、高品質なシーンの生成が可能であるため、NVIDIAは「ライブ配信を新たな次元に導く」とアピールしています。

QUEEN: QUantized Efficient ENcoding of Dynamic Gaussians for Streaming Free-viewpoint Videos

https://research.nvidia.com/labs/amri/projects/queen/

NVIDIA Research Model Enables Dynamic Scene Reconstruction | NVIDIA Blog

https://blogs.nvidia.com/blog/neurips-2024-research/

料理配信やスポーツのライブ中継など、視聴者側が自分の好みの視点から映像をチェックしたいと考えるコンテンツは複数あります。そんな自由視点ライブ配信を実現するためのAIモデルとして、NVIDIAが開発したのが「QUEEN」です。NVIDIAは没入型ストリーミングアプリケーションの構築に役立つと主張しており、それ以外にも倉庫や製造工場でロボットを遠隔操作する際などにも応用できると記しています。

NVIDIAの研究ディレクターであるシャリーニ・デ・メロ氏は、QUEENについて「自由視点動画をほぼリアルタイムでストリーミングするには、3Dシーンの再構築と圧縮を同時に行う必要があります。QUEENは圧縮率・画質・エンコード時間・レンダリング時間などの要素のバランスを取り、画質とストリーミング可能性の新たな基準となる最適化されたパイプラインを作成します」と述べ、低帯域幅でありながら高品質な映像を出力できる点をアピールしています。

実際にQUEENで出力した自由視点動画の事例が以下。

その1

その2

その3

その4

自由視点動画は通常、複数カメラが用意された映画スタジオや、複数のセキュリティカメラが設置された倉庫レベルのセットアップが必要です。視点を自由に動かせるよう、複数のカメラで映像を撮影するというのが大前提としてあります。また、従来のAI方式では、ライブ配信向けに自由視点動画を生成するには大量のメモリが必要になり、ファイルサイズを小さくするには画質を犠牲にする必要があるなどの制約がありました。

しかし、QUEENは画質とファイルサイズのバランスを巧みにとることで、火花や炎、毛皮で覆われた動物などが登場するダイナミックなシーンでも、ホストサーバーからクライアントのデバイスに簡単に送信できる高品質の映像を出力することに成功しています。また、従来の方法よりも高速に映像をレンダリングすることが可能です。

現実世界のほとんどの環境で、シーンの多くの要素は静的なままです。これは、動画においてピクセルの大部分がフレーム間で変化しないことを意味します。コンピューティング時間を節約するために、QUEENはこれらの静的領域のレンダリングを追跡・再利用し、代わりに時間の経過と共に変化するコンテンツの再構築に重点を置いているとのこと。

NVIDIAの研究チームはNVIDIA Tensor Coresを利用して、いくつかのベンチマークでQUEENのパフォーマンスを評価しています。この結果、さまざまな基準においてQUEENは他の自由視点動画を生成する方法よりも優れていることが明らかになりました。なお、自由視点動画を毎秒約350フレーム(350fps)でレンダリングするには、同一のシーンをさまざまな角度から撮影した2D動画を利用して、わずか5秒未満で完了するそうです。

以下の画像は3DGStream(左)とQUEEN(右)で出力した自由視点動画のワンシーンを切り抜いた画像。背景の画質は同程度ですが、動画の中で動いている人物のクオリティは明らかにQUEENが上です。また、3DGStreamは出力した動画のファイルサイズが1フレーム当たり8.86MBであるのに対して、QUEENは2.18MBと4分の1以下です。

コンパクトなファイルサイズでありながら高画質であるため、QUEENは「没入型のバーチャルリアリティ体験やスポーツの重要な瞬間の即時リプレイを提供することで、コンサートやスポーツの試合のメディア放送をサポートできます」とNVIDIAは説明しています。

なお、現地時間の2024年12月10日にカナダのバンクーバーで開催されるAI研究の年次会議「NeurIPS」の中で、QUEENの詳細が発表される予定です。QUEENはオープンソースでリリース予定となっており、以下のプロジェクトページで公開予定となっています。

QUEEN: QUantized Efficient ENcoding of Dynamic Gaussians for Streaming Free-viewpoint Videos

https://research.nvidia.com/labs/amri/projects/queen/

・関連記事

OpenAIは動画生成AI「Sora」で実在の人物が映る動画や既存のアーティストをまねる動画の生成を制限している - GIGAZINE

OpenAIが動画生成AI「Sora」を正式にリリース、ChatGPT Plus・Proプランで利用可能 - GIGAZINE

Metaが動画生成AI「Movie Gen」を開発、テキストからの動画生成に加えて「登場人物の指定」「BGMの付与」「既存動画の編集」にも対応 - GIGAZINE

Googleの最先端動画生成モデル「Veo」と最高品質の画像生成モデル「Imagen 3」のプレビュー提供がAI開発プラットフォーム「Vertex AI」でスタート - GIGAZINE

Amazonの新しい生成AIモデル「Olympus」は画像・動画・文章を処理でき、早ければ来週のAWS re:Inventで発表される可能性あり - GIGAZINE

・関連コンテンツ

in AI, 動画, ソフトウェア, Posted by logu_ii

You can read the machine translated English article NVIDIA announces 'QUEEN', an open source….