手書きのメモの写真からペンの動きを抽出するモデル「InkSight」をGoogleが開発

Googleのチームが手書きのメモの写真からペンの動きを抽出するモデル「InkSight」を発表しました。特殊なツール不要で手書きのメモを手書きのスタイルを維持したままデジタル化することが可能になるとのことです。

A return to hand-written notes by learning to read & write

https://research.google/blog/a-return-to-hand-written-notes-by-learning-to-read-write/

[2402.05804] InkSight: Offline-to-Online Handwriting Conversion by Learning to Read and Write

https://arxiv.org/abs/2402.05804

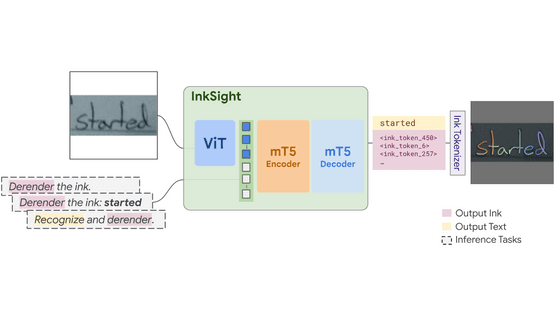

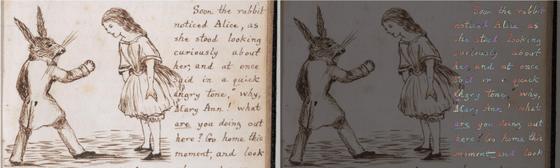

InkSightを使用すると、手書きの内容から「ペンの動き」を抽出できます。例えば下図において、左の手書きで書かれているテキストをInkSightに入力した場合、ペンの動きである「ストローク」が右のように抽出されます。下図ではわかりやすさのため、認識された単語ごとに虹色で着色されているほか、1つのストローク内では暗い色から明るい色へと変化するように表示されています。

InkSightの内部ではまず既存のOCRモデルを使用して手書きの単語を識別し、InkSightモデルを使用してストロークへと変換しています。再現性・再利用性・導入の容易さを高めるため、モデルには広く普及しているViTエンコーダーおよびmT5エンコーダー/デコーダーが使用されているとのこと。

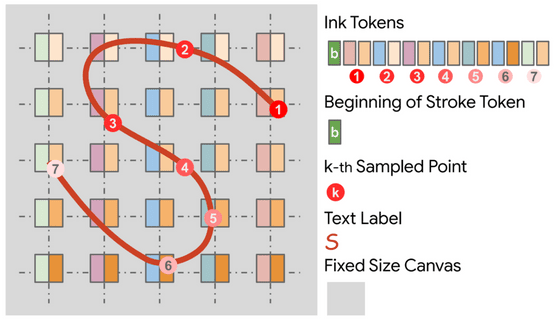

モデルのトレーニングにはテキストの画像とリアルタイムの書き込みの軌跡からサンプリングされたストロークが使用されました。モデルへの入出力をトークンという形式で行うため、ストロークを専用のトークナイザーでトークン化したとのこと。トークナイザーでは下図のように手書き時の軌跡データをもとに、トークンの開始を表す「b」というトークンに続き、サンプリングポイントごとの座標のトークンを続けるという形でトークン化を行いました。

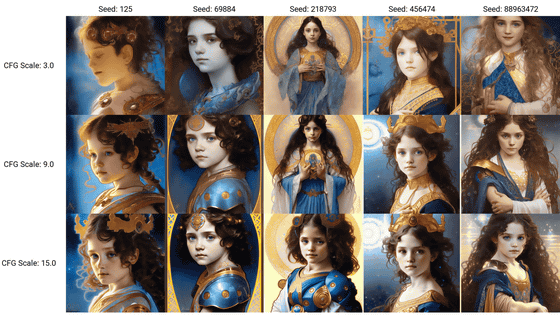

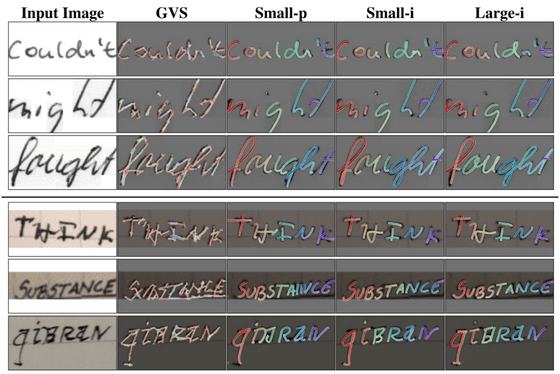

Googleのチームは外部向けの「Small-p」および社内向けの「Small-i」「Large-i」という3つのモデルをトレーニングしました。パラメーター数はSmallモデルが約3億4000万、Largeモデルが約10億です。それぞれのモデルとベースラインである(PDFファイル)GVSの比較結果は下図の通り。GVSには複数のストロークが重複しているところがある一方、InkSightのモデルは1回のストロークを1回のストロークとして認識できていることがうかがえます。

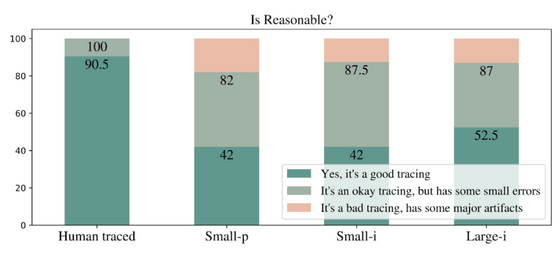

また、研究チームは同じテキスト画像を人間およびInkSightの3つのモデルそれぞれでトレースし、トレース方法を隠したうえで人間に評価してもらうという比較も行いました。結果は下図の通りで、人間によるトレースは「良いトレース」の評価が90.5%で「悪いトレース」の評価はありませんでした。一方、InkSightのモデルは「良いトレース」の評価が42%から52.5%であり、「悪いトレース」の評価が12.5%から18%程度存在しました。

チームは今回の研究について、「手書きの写真をデジタルなインクに変換する初めてのアプローチ」と述べています。なお、研究で使用したモデルおよびコードはGitHubリポジトリからダウンロード可能で、Hugging Faceにてデモの出力を確認できるとのことです。

・関連記事

汚すぎる医師の字を解読するのに特化したAIをGoogleが開発中 - GIGAZINE

AIの力で「手書き文字」を生成できる無料ウェブアプリ「Calligrapher.ai」レビュー - GIGAZINE

「人間特有の手書き文字」を自動で生成する技術が開発中 - GIGAZINE

イラストを入力するとあたかも手描きをタイムラプス撮影しているかのような制作過程ムービーを作成できる「Paints-Undo」 - GIGAZINE

無料でキャラクターイラスト1枚からぬるぬる動くアニメーションを作成するAI「Animated Drawings」をMeta AIがリリース - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1d_ts

You can read the machine translated English article Google develops 'InkSight', a model that….