OpenAIの元主任サイエンティストであるイルヤ・サツキヴァーがAI企業「Safe Superintelligence」を設立

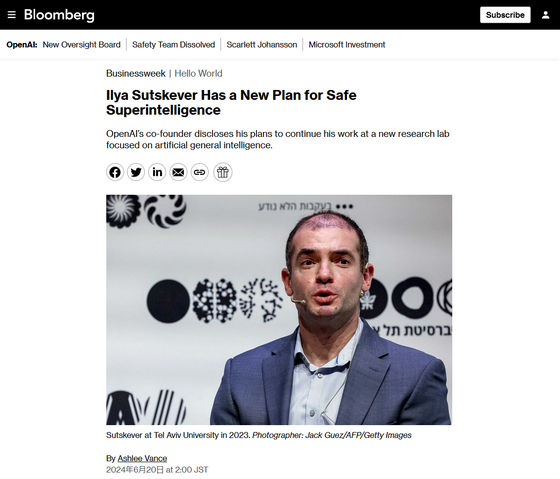

ChatGPTの開発元として知られるAI業界の先駆者であるOpenAIの共同創設者兼元主任研究員で、2023年11月に起こったサム・アルトマンCEO解任騒動を主導した人物であると目されているイルヤ・サツキヴァー氏が、新しいAI企業の「Safe Superintelligence」を立ち上げたことを発表しました。

OpenAI Co-founder Plans New AI Focused Research Lab - Bloomberg

https://www.bloomberg.com/news/articles/2024-06-19/openai-co-founder-plans-new-ai-focused-research-lab

Ilya Sutskever, OpenAI's former chief scientist, launches new AI company | TechCrunch

https://techcrunch.com/2024/06/19/ilya-sutskever-openais-former-chief-scientist-launches-new-ai-company/

OpenAI’s former chief scientist is starting a new AI company - The Verge

https://www.theverge.com/2024/6/19/24181870/openai-former-chief-scientist-ilya-sutskever-ssi-safe-superintelligence

The former OpenAI chief scientist has co-founded a new company, Safe Superintelligence Inc - Neowin

https://www.neowin.net/news/the-former-openai-chief-scientist-has-co-founded-a-new-company-safe-superintelligence-inc/

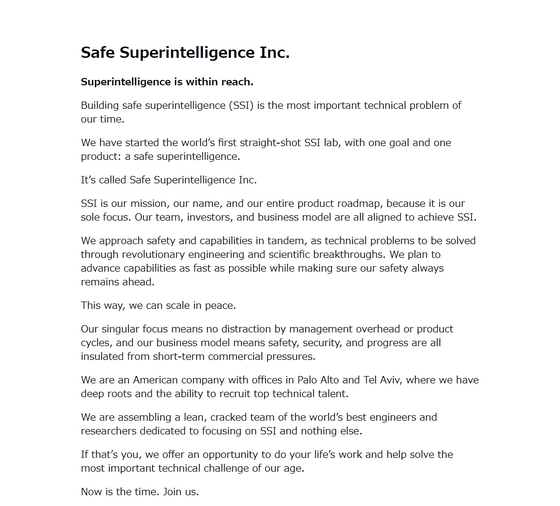

Safe Superintelligenceの公式ウェブサイトがすでに開設されており、以下のメッセージが掲載されています。

安全なスーパーインテリジェンス(SSI)の構築は現代の最も重要な技術的課題です。我々はSSIというひとつの目標とひとつの製品を掲げ、世界初の直球勝負のSSI研究所を立ち上げました。その会社の名前がSafe Superintelligenceです。SSIは我々の使命であり、名前であり、製品ロードマップ全体です。なぜなら、それが我々の唯一の焦点だからです。

我々のチーム・投資家・ビジネスモデルはすべてSSIの達成に向けて連携しています。当社は安全性と機能性を革新的なエンジニアリングと科学の進歩によって解決すべき技術的問題として同時に捉えています。安全性を常に最優先にしながら、機能性を可能な限り迅速に向上させる予定です。こうすることで平和的に規模を拡大することができます。当社は経営管理上の諸経費や製品サイクルに煩わされることがないように、焦点を一点に集中しています。また、当社のビジネスモデルでは安全性・セキュリティ・進歩が、すべて短期的な商業的プレッシャーから保護されています。

当社はカリフォルニア州パロアルトとイスラエルのテルアビブにオフィスを構えるアメリカの企業で、この地域に深く根を下ろし、優秀な技術者を採用する能力を持っています。我々はSSIのみに集中し、世界最高のエンジニアと研究者からなる精鋭チームを編成しています。もしあなたが世界最高のエンジニアあるいは研究者であるなら、我々はあなたの生涯の仕事に携わり、現代の最も重要な技術的課題の解決に貢献する機会を提供します。今がその時です、ご参加ください」

Safe Superintelligence Inc.

https://ssi.inc/

Safe Superintelligenceは公式X(旧Twitter)アカウントも開設しており、同様のメッセージをX上でポストしています。

Superintelligence is within reach.

— SSI Inc. (@ssi) June 19, 2024

Building safe superintelligence (SSI) is the most important technical problem of our time.

We've started the world’s first straight-shot SSI lab, with one goal and one product: a safe superintelligence.

It’s called Safe Superintelligence…

サツキヴァー氏は自身のXアカウントで、Safe Superintelligenceのポストを引用して「私は新しい会社を立ち上げます」と投稿しています。

I am starting a new company: https://t.co/BG3K3SI3A1

— Ilya Sutskever (@ilyasut) June 19, 2024

Safe Superintelligenceの設立者には、サツキヴァー氏のほかに、検索エンジン・Cueの共同創設者であり、AppleでAI関連の取り組みを主導し、Y Combinatorのパートナーも務めたアメリカの起業家であるダニエル・グロス氏と、OpenAIの元エンジニアであるダニエル・レヴィ氏も名を連ねています。

OpenAIにおいて、サツキヴァー氏はAIの安全性向上に向ける取り組みにとって欠かせない人物でした。サツキヴァー氏は同分野において、ヤン・ライク氏と共にAIの安全性を確保するための部署である「スーパーアライメント」を率いていましたが、同氏がOpenAIを退職したのちスーパーアライメントは解散しています。

OpenAIで超知性の制御と安全性を研究していた「スーパーアライメント」チームが解散、元幹部は「派手な製品が安全性より優先されている」 - GIGAZINE

by Jernej Furman

OpenAIは非営利団体として2015年に立ち上げられましたが、その後、コンピューティング能力の構築に莫大な資金が必要であることが明らかになり方針転換を迫られることとなりました。サツキヴァー氏の立ち上げたSafe Superintelligenceは初めから営利団体として立ち上げられているため、「私たちはさまざまな問題に直面していますが、資金調達はその中のひとつにはならないでしょう」と共同創設者のひとりであるグロス氏はBloombergに語っています。

・関連記事

OpenAIの主任研究員でサム・アルトマンCEO解任を主導したイルヤ・サツキヴァー氏が退職 - GIGAZINE

OpenAIのサム・アルトマン元CEO退任は主任研究員のイルヤ・サツキヴァー氏との「AIの安全性」をめぐる対立が原因か - GIGAZINE

OpenAIの共同設立者が「私たちは間違っていた」と語る、AIの危険性からデータをオープンにしない方針へと大転換 - GIGAZINE

OpenAIの内紛でサム・アルトマンCEOが突然解任された理由の一端が元取締役の口から語られる - GIGAZINE

OpenAIで超知性の制御と安全性を研究していた「スーパーアライメント」チームが解散、元幹部は「派手な製品が安全性より優先されている」 - GIGAZINE

・関連コンテンツ

in メモ, Posted by logu_ii

You can read the machine translated English article Former OpenAI Chief Scientist Ilya Satsk….