画像生成AIのStable Diffusionなどに使われるデータセット「LAION-5B」に同意のない子どもの写真が含まれており身元まで特定可能

画像生成AIのStable Diffusionなどのトレーニングには、約58億5000万もの画像とテキストの組み合わせからなるデータセット「LAION-5B」が用いられています。新たに人権NGOのヒューマン・ライツ・ウォッチ(HRW)が、LAION-5Bにはブラジルの子どもたちの写真が同意なしで使われており、多くの子どもたちは身元まで追跡可能であると報告しました。

Brazil: Children’s Personal Photos Misused to Power AI Tools | Human Rights Watch

https://www.hrw.org/news/2024/06/10/brazil-childrens-personal-photos-misused-power-ai-tools

AI trained on photos from kids’ entire childhood without their consent | Ars Technica

https://arstechnica.com/tech-policy/2024/06/ai-trained-on-photos-from-kids-entire-childhood-without-their-consent/

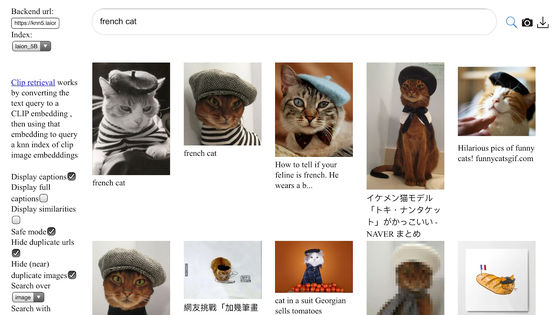

LAION-5Bはドイツの非営利団体「Large-scale Artificial Intelligence Open Network(LAION)」が2022年3月にリリースしたオープンデータセットであり、画像分類モデルのCLIPでフィルタリングされた58億5000万もの画像とテキストの組み合わせで構成されています。これらの画像とテキストはインターネット上のデータを提供するコモン・クロールのファイルを解析し、類似性の高い画像とテキストのペアを抽出するという手法で収集されているため、データセットの作成者ですら中身を正確に把握することはできません。

過去にはLAION-5Bのデータセットに1000枚超の児童ポルノ画像が含まれていることが明らかになり、削除されるという事態が発生しました。調査によると、LAION-5Bにはソーシャルメディアやウェブサイト、人気アダルト動画サイトなどから既知の児童性的虐待画像(CSAM)が収集されていたとのことです。

画像生成AI「Stable Diffusion」などに使われた50億枚超の画像セット「LAION-5B」に1008枚の児童ポルノ画像が入っていることが判明し削除へ - GIGAZINE

HRWの研究者であるヘ・ジュン・ハン氏らは新たな調査で、LAION-5Bのデータセットからブラジルの少なくとも10州で撮影された子どもの写真170枚を発見しました。一部の子どもは名前が添付のテキストに含まれていたり、画像のURLが保存されていたり、撮影場所がわかったりするため、多くの場合は子どもの身元まで特定することが可能だったと報告されています。

調査で発見された写真は、手袋をはめた医師に抱きかかえられている生後間もない乳児のものから、バースデーケーキのろうそくを吹き消す幼児、家で下着姿で踊る子ども、学校でプレゼンテーションを行う生徒、高校のお祭りで写真を撮るティーンエイジャーまで、子ども時代全体に及びました。これらの写真の多くは少数の人のみが見ることを想定したもので、個人ブログや子育てブログにアップロードされたものだったり、再生回数の少ないYouTube動画を静止画で切り出したものだったりしたとのこと。

LAIONはHRWが発見した子どもたちの写真がデータセットに含まれていることを認め、削除することを約束しました。LAIONの広報担当者であるネイト・タイラー氏はテクノロジー系メディアのArs Technicaの問い合わせに対し、「これは非常に懸念される問題であり、非営利のボランティア団体として私たちは支援のために力を尽くします」と述べました。しかし、今回HRWが調査したのはLAION-5Bのデータセットのうち0.0001%未満だったそうで、今回発見された写真は氷山の一角に過ぎないとみられています。

LAION-5Bのデータセットに含まれてしまった子どもたちの写真は、画像生成AIの出力に利用されることになります。LAIONはデータセットで訓練されたAIモデルが元データをそのまま再現できるわけではないと主張していますが、画像生成AIを用いて女性のヌード画像を生成する事件が世界中で相次いでいることから、子どもたちの写真が児童ポルノの出力に貢献している可能性があります。

生成AIアプリで男子学生が女子の「ディープヌード」を作成する問題が深刻化している - GIGAZINE

ブラジルでは少なくとも85人の少女が、画像生成AIを用いた「ディープフェイク」の被害に遭っているとのこと。HRWは「捏造(ねつぞう)されたメディアは以前から存在していましたが、作成には時間・リソース・専門知識が必要であり、ほとんどはリアルではありませんでした。今日のAIツールは数秒で本物そっくりの画像を出力し、多くの場合は無料で使いやすいため、合意のないディープフェイクが拡散して生涯にわたりオンラインで再循環し、永続的な被害をもたらすリスクがあります」と指摘しています。

ハン氏は、「子どもたちは写真が盗まれたり、武器化されたりするかもしれない恐怖の中で暮らすべきではありません。政府はAIによる悪用から子どものデータを守るための政策を早急に導入するべきです」と述べ、生成AIによる子どもたちの被害を食い止める取り組みが重要だと訴えました。

◆つづき:

Stable Diffusionにも使われるデータセット「LAION-5B」に児童性的虐待コンテンツが見つかり開発元がリンクを削除した「Re-LAION-5B」をリリース - GIGAZINE

・関連記事

画像生成AI「Stable Diffusion」などに使われた50億枚超の画像セット「LAION-5B」に1008枚の児童ポルノ画像が入っていることが判明し削除へ - GIGAZINE

きちんとチェックすると「781年」かかるAI用データセット「LAION-5B」の課題がよくわかる「Models All The Way Down」 - GIGAZINE

画像生成AI「Stable Diffusion」などの開発に大きな貢献を果たした超巨大データセット「LAION-5B」とは? - GIGAZINE

画像生成AI「Stable Diffusion」が使う無料のデータセット「LAION」の構築を率いているのは1人の高校教師だった - GIGAZINE

生成AIアプリで男子学生が女子の「ディープヌード」を作成する問題が深刻化している - GIGAZINE

少女の性的被害が相次ぐ写真から衣服を剥ぎ取るAIポルノアプリ「ClothOff」の背後にいる人物とは? - GIGAZINE

AIで顔と裸を合成する「ディープフェイクポルノ」の被害に遭った女子高生たちにほとんど救済の道がないことが問題に - GIGAZINE

AI生成の児童ポルノが爆増しており児童搾取に関する報告システムが機能不全に陥る恐れがあるとインターネット監視団が警告 - GIGAZINE

AIによるポルノコンテンツ生成を認めるべきかOpenAIが検討中 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, Posted by log1h_ik

You can read the machine translated English article The dataset 'LAION-5B' used for image ge….