画像生成AI「Stable Diffusion」などに使われた50億枚超の画像セット「LAION-5B」に1008枚の児童ポルノ画像が入っていることが判明し削除へ

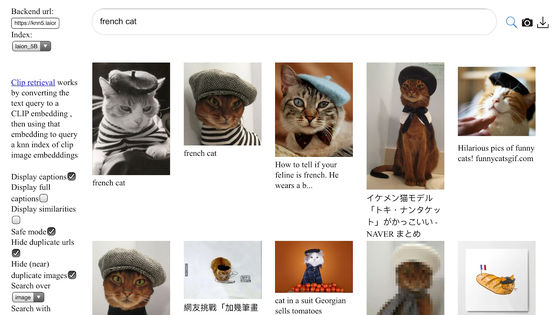

スタンフォード大学インターネット天文台(SIO)の調査により、画像生成AI「Stable Diffusion」などのトレーニングに利用されているオープンデータセットの「LAION-5B」に、児童性的虐待画像(CSAM)が含まれていることが明らかになりました。CSAMの疑いのある画像は3226枚で、そのうち1008枚が外部機関の検証によりCSAMであると確認されました。

Investigation Finds AI Image Generation Models Trained on Child Abuse | FSI

https://cyber.fsi.stanford.edu/io/news/investigation-finds-ai-image-generation-models-trained-child-abuse

Largest Dataset Powering AI Images Removed After Discovery of Child Sexual Abuse Material

https://www.404media.co/laion-datasets-removed-stanford-csam-child-abuse/

Large AI Dataset Has Over 1,000 Child Abuse Images, Researchers Find - Bloomberg

https://www.bloomberg.com/news/articles/2023-12-20/large-ai-dataset-has-over-1-000-child-abuse-images-researchers-find

Child abuse images found in AI training data, Stanford study reports

https://www.axios.com/2023/12/20/ai-training-data-child-abuse-images-stanford

オンライン児童安全団体のThornとSIOは、機械学習を用いた生成モデルの急速な発展に伴い、オープンソースの生成AIを使用してCSAMを生成できることを突き止めました。これに続く新しい調査で、生成AIのトレーニングに利用される50億枚以上の画像が含まれるオープンソースの画像データセット「LAION-5B」には、少なくとも1008枚のCSAMが含まれていることが明らかになっています。調査によると、LAION-5Bにはソーシャルメディアやウェブサイト、人気アダルト動画サイトなどから既知のCSAMが収集されていたそうです。

SIOの研究チームはすでにアメリカの国立行方不明・搾取児童センター(NCMEC)とカナダ児童保護センター(C3P)に当該画像のURLを報告しており、記事作成時点で画像の削除作業が進行中です。調査では主にCSAMの照合に利用されるハッシュツールのPhotoDNAが使用されており、調査を行った研究者はCSAMを直接閲覧せず、ハッシュが一致した画像をNCMECに報告しています。なお、確認が必要な場合はC3Pがこれを行ったとのことです。

AIモデルのトレーニング用データセットに含まれるCSAMを最小限に抑えるには、データをホストする中央機関が存在しないオープンデータセットを構築することなどが挙げられますが、この場合データのクリーンアップや配布停止を行うことは非常に困難になるという欠点があります。

なお、研究チームは「今後のデータセットで収集される画像は、PhotoDNAのような検出ツールを使用したり、NCMECやC3Pのような児童安全組織と提携したりすることで、既知のCSAMリストと照合されるべきです」と言及しました。

これに対して、LAION-5Bの開発元であるドイツの非営利団体・LAIONの広報担当者は、違法コンテンツに対してゼロトレランスポリシーを掲げていると説明。「再公開する前に安全性を確認するためにLAIONのデータセットを一時的にインターネット上から削除しています」とBloombergにコメントしています。なお、LAIONによると同社はデータセットに違法なコンテンツが含まれないように、違法コンテンツの検出・削除用のフィルターを作成・公開しているそうです。

LAIONの創設者であるクリストフ・シューマン氏は、Bloombergの取材に対して「データセットに児童のヌードが含まれていることは知らなかった」と語っており、このようなコンテンツが含まれていることが明らかになった場合は、即座にリンクを削除すると説明しています。

Stable Diffusionの最新バージョンであるStable Diffusion 2.0は、LAION-5Bから「安全ではない画像」をフィルタリングしたデータでトレーニングが行われているため、ユーザーが性的に露骨な画像などを生成することが難しくなっています。しかし、Stable Diffusion 1.5は性的に露骨なコンテンツの生成が比較的容易で、これを用いて作成されたコンテンツがインターネット上にまん延しています。

これについてBloombergがStable Diffusionの開発元であるStability AIに問い合わせたところ、同社の広報担当者は「AIの悪用防止に尽力しており、CSAMの作成・編集を含む違法行為にStable Diffusionを利用することを禁止している」とコメント。さらに、Stability AIは「Stable Diffusion 1.5はStability AIが開発したものではなく、Stable Diffusionのオリジナル版の作成に協力したAIスタートアップのRunwayがリリースしたもの」と説明しています。一方で、RunwayはStable Diffusion 1.5について「Stability AIと共同でリリースした」とコメントしたそうです。

なお、Stability AIの広報担当者は「ユーザーが我々のプラットフォーム上でモデルと対話する際に、安全ではないプロンプトや安全ではない出力を遮断するために、フィルター機能を実装しています。また、我々のプラットフォーム上で生成された画像を識別するのに役立つコンテンツラベリング機能にも投資しており、これらにより悪質な行為者がAIを悪用することは難しくなっています」とも述べています。

・関連記事

「児童の性的虐待画像に写った手」をAIで分析して犯罪者を特定するプロジェクトが進行中 - GIGAZINE

AIで顔と裸を合成する「ディープフェイクポルノ」の被害に遭った女子高生たちにほとんど救済の道がないことが問題に - GIGAZINE

EUで進む「児童の性的虐待コンテンツ検出システム」の義務化の裏には利権団体が群がっているとの指摘 - GIGAZINE

AIは女性の下着や運動着を文脈を無視して「性的」としてシャドウバンすることが判明、女性主導のビジネスに損害を与えていると専門家 - GIGAZINE

GoogleがAIを活用してネット上の「児童を搾取する違法なポルノコンテンツ」を自動で見つけ出すツールを開発 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by logu_ii

You can read the machine translated English article 1008 child pornography images were found….