Appleが新たなパーソナルAIの「Apple Intelligence」を発表、OpenAIとの提携でSiriがChatGPTをサポート

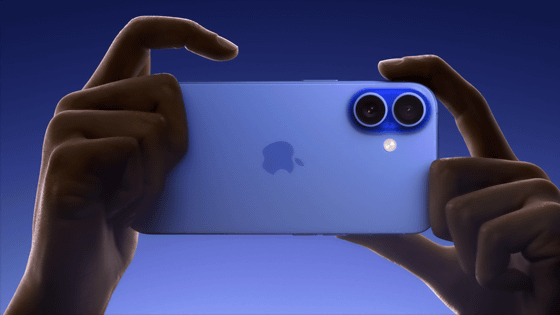

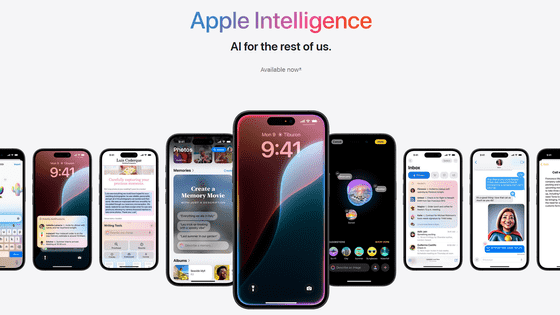

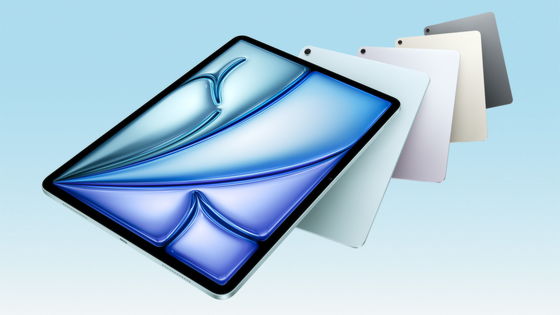

2024年6月11日2時からAppleが開催している年次開発者会議「WWDC24」の基調講演で、iPhone・iPad・Macで使える新しいパーソナルAI「Apple Intelligence」を発表しました。

iPhone、iPad、MacにApple Intelligenceが登場 - Apple (日本)

https://www.apple.com/jp/newsroom/2024/06/introducing-apple-intelligence-for-iphone-ipad-and-mac/

Appleのイベント - Apple(日本)

https://www.apple.com/jp/apple-events/

WWDC 2024 — June 10 | Apple - YouTube

私たちは長年人工知能(AI)や機械学習を活用してきました。

近年の生成知能と大規模言語モデルの発展はパワフルな機能をもたらし、Apple製品の使用体験を新しい高みへと引き上げる機会を生み出します。

AppleのAIは、ユーザーが一番大切に思うことを手助けできるようにパワフルで、なおかつ……

直感的で使いやすくあるべきです。

さらに、ユーザーの製品体験に深く結びついていなければいけません。

ユーザーのパーソナルコンテクストに根差したものでなければいけません。

もちろん、プライバシーを守る機能も基礎から組み込む必要があります。

上記を満たしたパーソナルAIが「Apple Intelligence」です。

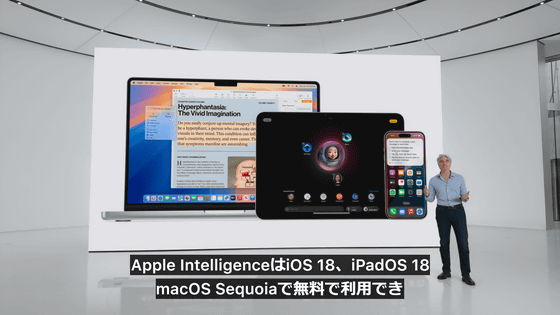

Apple IntelligenceはiOS 18、iPadOS 18、macOS Sequoiaで利用可能となる予定。

Apple Intelligenceによって、iPhone、iPad、Macはユーザーのパーソナルコンテクストを理解していることが大きな特徴です。

言語や文字はコミュニケーションや仕事に不可欠です。

Apple Intelligenceに内蔵した大規模言語モデルは毎日のタスクの多くをより簡単に速くこなせるようにしてくれます。

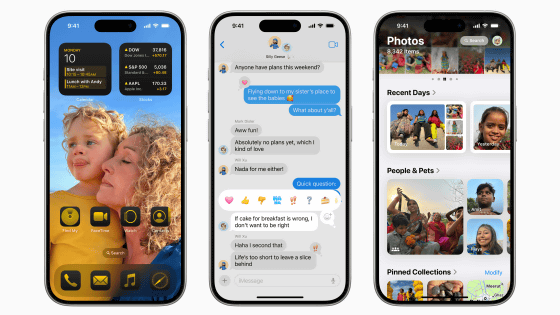

例えば、iPhoneが通知に優先順位を付けられるので、気が散るものを最小限に抑えながら重要な通知は確実に受け取ることが可能。

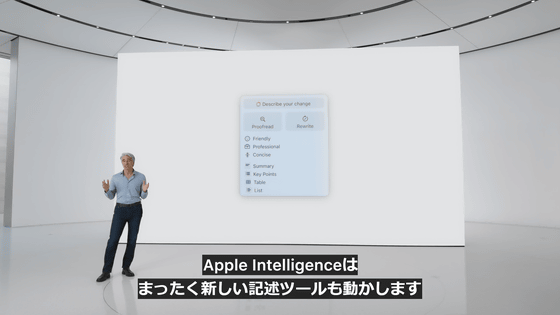

Apple Intelligenceは全く新しい記述ツールも動かします。

このツールにシステム全体でアクセスでき、文章に自信が持てるようになります。

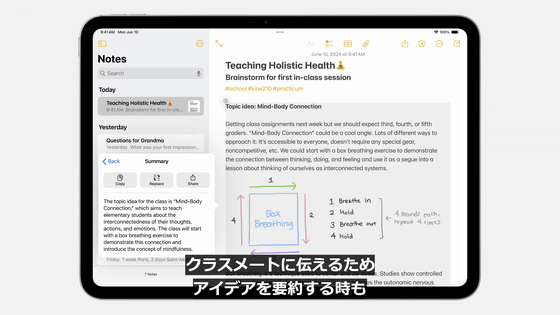

記述ツールは文章の書き直しや校正・要約が可能。

クラスメートに伝えるためアイデアを要約する時も……

メール、メモ、Safari、Pages、Keynoteのほかに他社製アプリでも自動で使えるようになります。

Apple Intelligenceには言語だけでなく画像に関する機能も多くあります。

Apple Intelligenceは写真ライブラリの中の人物を理解するので、友だちの誕生日を祝うために友だちの画像をケーキや風船、花で囲んだ画像を生成したり、ヒーローのマントを付けた画像を生成したりすることもできます。

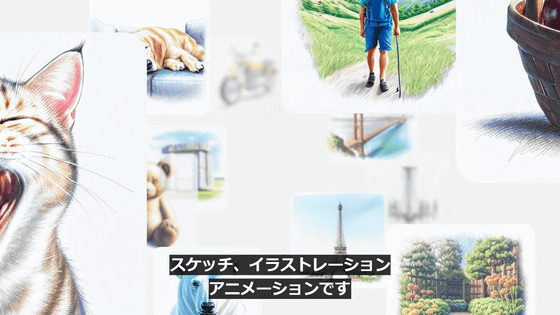

画像生成時、3つの独自のスタイルを選択可能。

スタイルはスケッチ、イラストレーション、アニメーションの3つです。

この体験はメッセージアプリだけでなく、システム全体のアプリに組み込まれます。

例えば、メモ、フリーボード、Keynote、Pagesなどで利用可能。

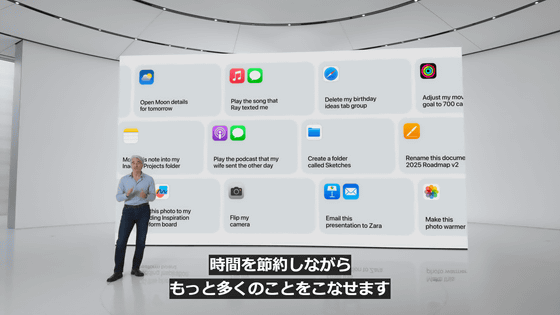

Apple Intelligenceは複数のアプリでアクションを実行する能力があります。

複数のツールを活用して、ユーザーの代わりにタスクを実行することも可能。

これにより時間を節約し、もっと多くのことをこなせるようになります。

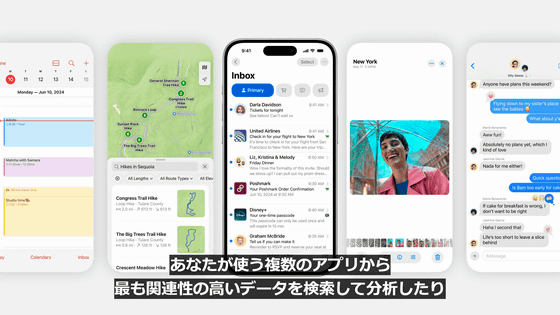

Apple Intelligenceはユーザーのパーソナルコンテクストを深く理解することができます。

このために、ユーザーが使う複数のアプリから最も関連性の高いデータを検索して分析したり、ユーザーが見ている画面の内容を参照したりできるように設計されています。

関連する個人データをApple Intelligenceが処理してユーザーをアシストしてくれるというわけです。

娘が数日前に送ってきた発表会の詳細や、会議の場所と時間など、あらゆる情報の処理をApple Intelligenceが手伝ってくれます。

もちろんこれらの情報がクラウド上に保存されたり、分析されるようなことがあってはいけません。

そのため、Apple Intelligenceはパワフルなプライバシー機能と緊密に連携します。

Apple Intelligenceの基盤はオンデバイス処理にあります。

これはApple独自のハードウェアとソフトウェアの統合により実現するものだそうです。

高度なAI処理をオンデバイスで実行することができるのは、AppleがAppleシリコンの開発に長年投資してきた成果でもあります。Apple Intelligenceの対応端末はA17 ProおよびM1以降を搭載したデバイス。つまり、iPhoneの場合は記事作成時点ではiPhone 15 ProおよびiPhone 15 Pro Maxのみが対応するということになります。

Apple Intelligenceを動かすための演算基盤は、高性能な大規模言語モデルと拡散モデルで構成され、ユーザーのアクティビティに臨機応変に適応できます。

複数のアプリからの情報を整理して表示することも可能。

Apple Intelligenceはユーザーからのリクエストがあると、ユーザーを最適にアシストするコンテクストを生成モデルに提供します。

ポケットサイズを超える大きなモデルが必要になる場合(オンデバイス処理では複雑で不可能なタスクを実行する必要がある場合)は、サーバーを利用。

そのような場合、ユーザーの個人データがサーバー上に保存され、ユーザーの意図しない方法で使われる可能性があります。

また、サーバー上で扱われるユーザーの個人データをユーザーが確かめることができなかったり、サーバー上でのデータの取り扱いに関する主張があとで変わってしまったりするというケースもあります。

しかし、理想としてはiPhoneのソフトウェアイメージにアクセスできるのは独立したエキスパートのみであり、継続的にプライバシーを確認することが可能であるべきです。

また、AppleはiPhoneのプライバシー機能とセキュリティ機能をクラウドへ拡大し、さらにAIを活用したいと考えてきたそうです。

そこでAppleが作ったのが、Private Cloud Computeです。

Private Cloud ComputeによりApple Intelligenceは演算能力を最適化でき、一段と複雑なリクエストに応えながらユーザーのプライバシーも守ることが可能となります。

また、Apple IntelligenceのモデルはAppleシリコンを使って特別に作成されたサーバー上で動作することとなります。

AppleシリコンサーバーはシリコンからiPhoneへプライバシー機能とセキュリティ機能を提供し、Swiftプログラミング言語のセキュリティプロパティを利用して、高い透明性を確保しながらソフトウェアを動作させます。

Apple Intelligenceがユーザーのリクエストを分析し、デバイス上での処理が可能か否かを判断します。

オンデバイス処理が不可能と判断された場合、Private Cloud Computeを利用してタスクに関連するデータのみをAppleシリコンサーバーに送信して処理します。

Appleがユーザーのデータを保存したり、データにアクセスしたりすることは絶対にありません。

ユーザーのリクエストに応えるためだけに個人データは利用されます。

iPhoneと同様に独立したエキスパートがサーバー上で実行されたコードを検証し、プライバシー規定が守られていることを確認します。

Private Cloud Computeは暗号化することで調査のために公に記録される場合を除き、ユーザーのiPhone、iPad、Macがサーバーへデータを開示しないようにします。

これが全く新しいAIのプライバシー基準を生み出し、信頼できるAIを解き放ちます。

AppleはApple Intelligenceでどのようにしてプライバシー保護機能を実現するかについて、基調講演で解説した部分だけを切り抜いた動画も公開しており、プライバシー保護機能をいかに重視しているかが伺えます。

Apple Intelligence | Privacy - YouTube

続いて、Apple Intelligenceがアプリや体験をどのように変革させるのかについて。

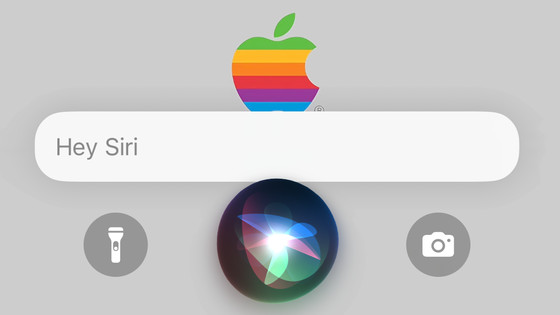

まずはAIにより生まれ変わることとなるSiriについて。

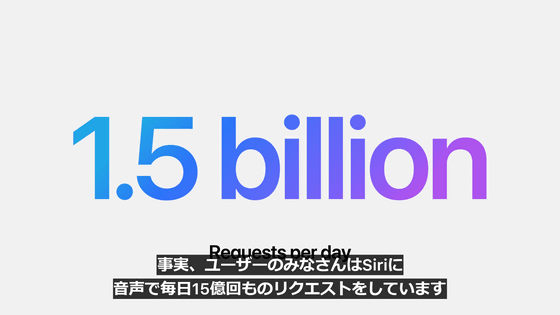

記事作成時点で、AppleデバイスユーザーはSiriに音声で毎日15億回ものリクエストをしているそうです。

2011年にAppleがリリースしたSiriは、最も初期のAIアシスタントのひとつでした。

そんなSiriが最新のAIによって生まれ変わります。

Siriはより自然で文脈的な関連性が高くなります。

Siriに話しかけると美しい光が画面のエッジを包みます。

このエフェクトにより、Siriがシステム体験により深く統合されていることがわかります。

Siriは前の会話を覚えているのでその続きを頼むことも可能。

また、Siriにタイプ入力するオプションも追加されます。

画面下部をダブルタップすることで、タイプ入力が可能に。

タイプ入力と音声入力は状況に合わせて自由に切り替えられます。

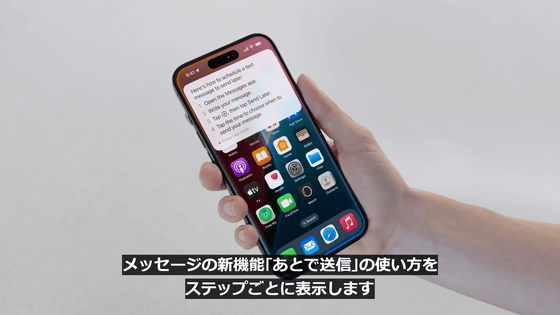

また、具体的な機能名を知らなくても、やりたいことを実現するための方法をSiriが教えてくれます。

メッセージアプリの新機能である「あとで送信」の使い方をステップごとに詳細に教えてもらうことも可能。

これらの機能はApple Intelligenceを使い始めた瞬間から利用可能です。

さらに、2025年にかけてSiriを一段とパーソナルで高性能にするためのたくさんの機能をリリースするとAppleは予告しています。

そんな今後リリース予定の機能のひとつが、Apple IntelligenceによってSiriが画面の内容を認識し、画面に表示されているものを使ってアクションを実行するようになる「オンスクリーンアウェアネス」という機能。

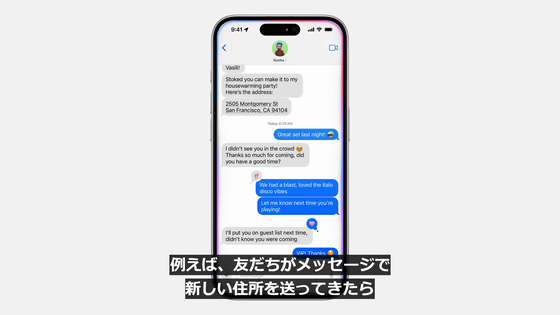

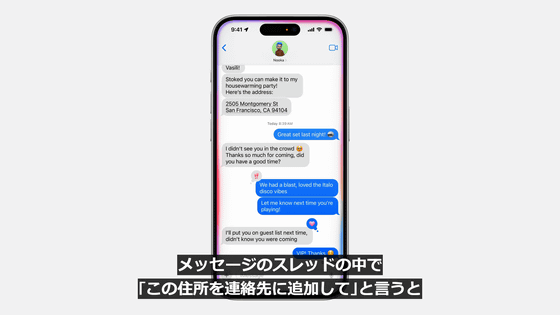

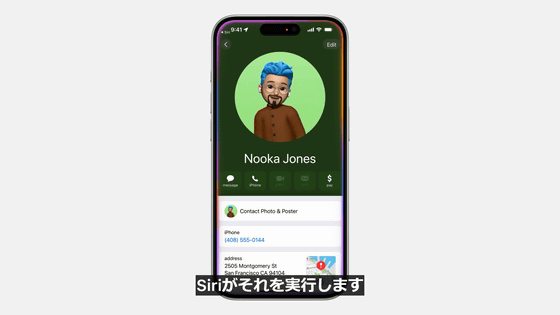

オンスクリーンアウェアネスの具体例が以下。友だちがメッセージで新しい住所を送ってきた際に、メッセージのスレッドの中で「この住所を連絡先に追加して」と言うと、Siriが実行してくれます。

Siriがアプリの中でユーザーに代わってアクションを取ることも可能。

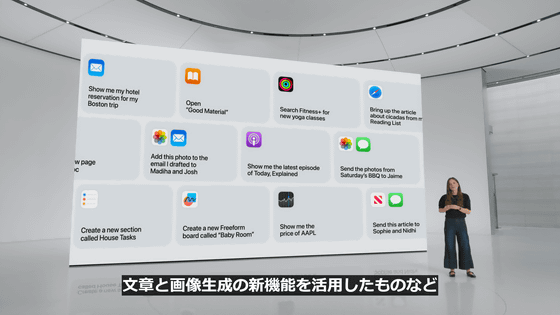

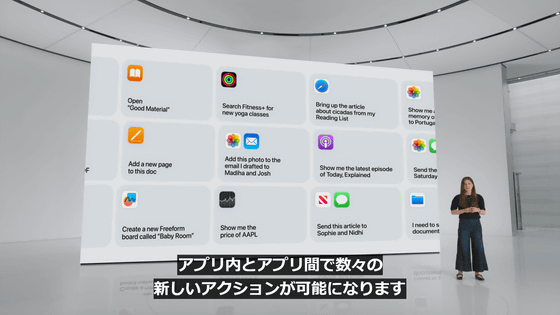

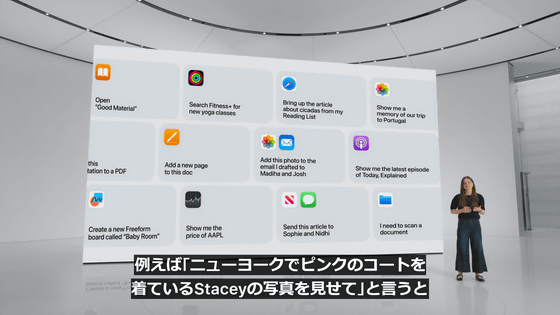

文章と画像生成の新機能を活用したものなど、アプリ内とアプリ間で数々の新しいアクションが可能になります。

例えば、「ニューヨークでピンクのコートを着ているStaceyの写真を見せて」と言うと、Siriがすぐにその写真を表示します。

続けて「この写真を明るくして」と言うと、Siriが写真を補正してくれます。

これはApp Intentsフレームワークの大幅な強化によるもので、アプリによるアクションの定義が可能になります。

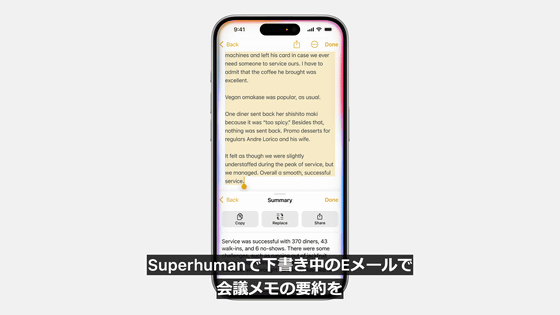

Pro Camera by Momentで光跡のビデオを撮るようにSiriに頼んだり、Superhumanで下書き中のメールで会議のメモの要約を作成するように頼んだりすることも可能。

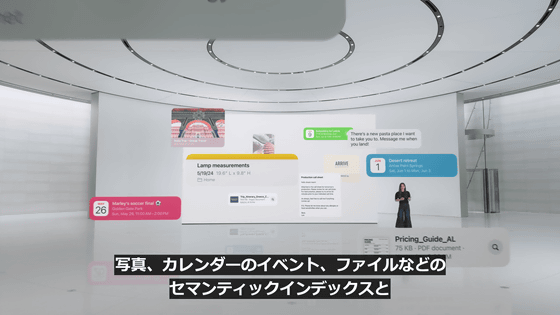

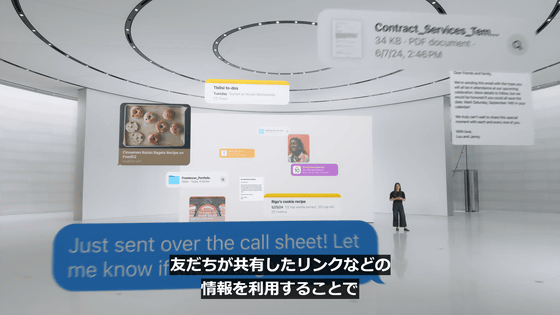

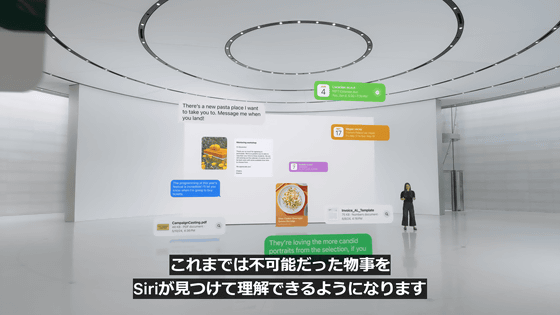

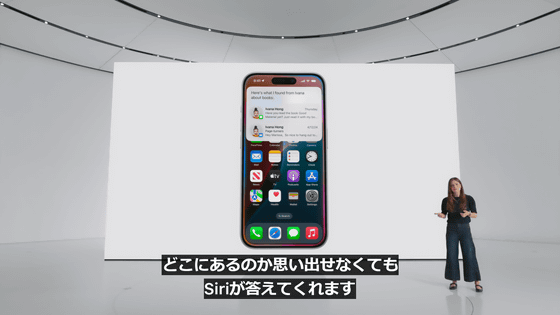

Apple Intelligenceにより、Siriがユーザーのパーソナルコンテクストを認識します。

写真、カレンダーのイベント、ファイルなどのセマンティックインデックスと友だちが共有したリンクなどの情報を利用することで、これまでは不可能だった物事をSiriが見つけて理解できるようになります。

Apple Intelligenceが持つ強力なプライバシー保護機能により、Siriがユーザーの情報を使ってタスクをこなす時もプライバシーは守られます。

ユーザーの知りたい情報がメール、メッセージ、共有したメモなど、どこにあるかわからなくなってもSiriが教えてくれます。

Siriが免許証の写真から免許証番号を抽出してフォームに直接入力してくれます。

「Siri、母のフライトの到着時間は?」

「母とのランチの予定は?」といった質問にも、Siriが答えてくれます。

メール、メッセージ、マップといった複数のアプリ間を移動せずに予定を立てることも可能。

Apple Intelligenceにより、ユーザーの文章を整える画期的な方法も登場します。

Apple Intelligenceによるコミュニケーションの効率化をメールアプリで見てみましょう。

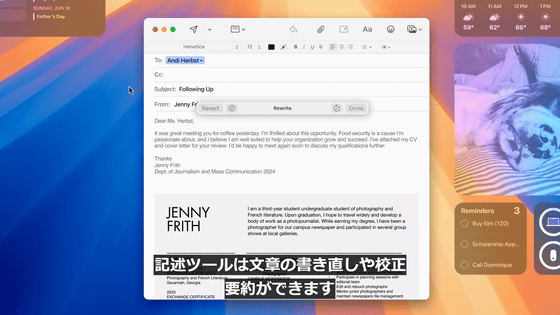

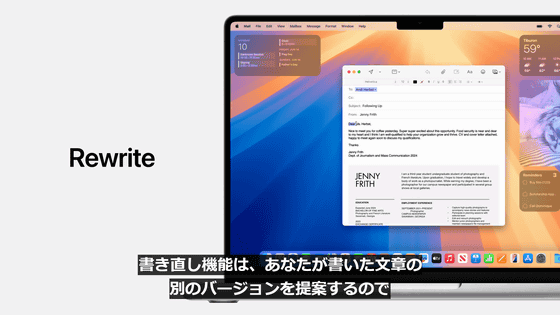

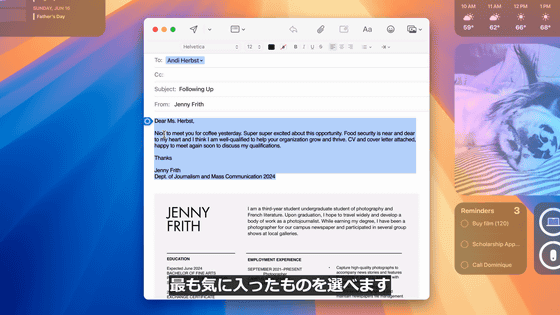

Apple Intelligenceにより実現する新機能のひとつが「書き直し」。ユーザーが書いた文章をApple Intelligenceが書き直してくれます。

フレンドリー、プロフェッショナルなど、さまざまな言葉づかいに対応しており、最も気に入った文章を選べるようになります。

ユーザーに合った文体や言葉づかいの組み合わせを選択可能。

校正機能を使えば文法、言葉づかい、文章を完璧にして好印象を与えることができます。

さらに、Apple Intelligenceが「要約」を作成してくれます。

入力した文章の要点をまとめ、メールの最上部に要約を追加することも可能。

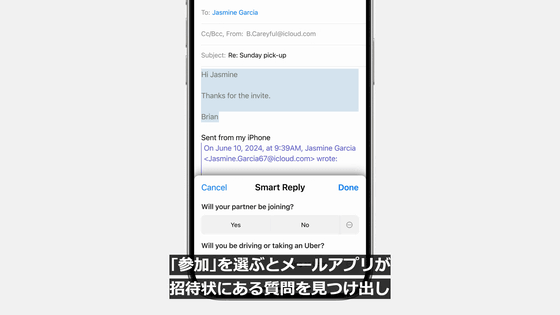

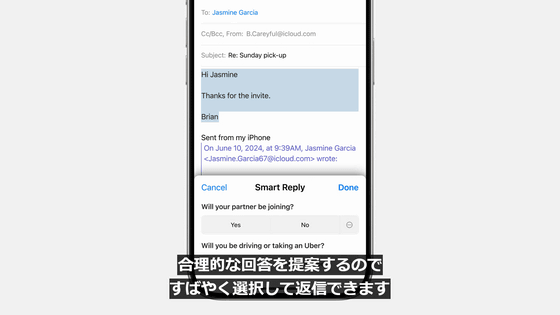

Apple Intelligenceにより、メールアプリでスマートリプライ機能が利用できるようになります。

例えば、イベントの招待状に返信する場合、メールに基づいた返信内容が提案されます。

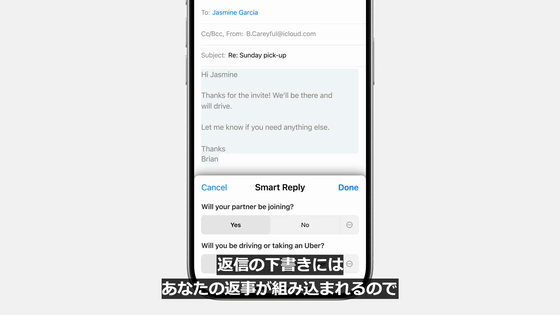

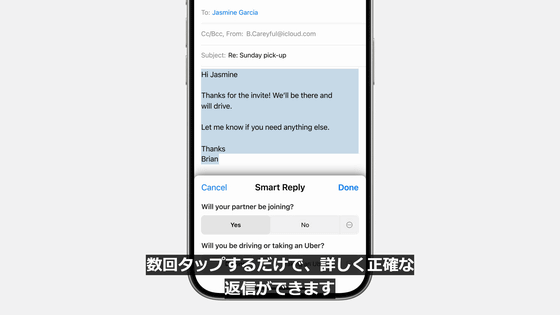

「参加」を選ぶとメールアプリが招待状にある質問を見つけ出し、合理的な回答を提案するので、素早く選択して返信することが可能。

返信の下書きにはユーザーの返事が組み込まれるので、数回タップするだけで、詳しく正確な返信ができます。

さらに、メールリストで要約を確認することも可能になります。

メールの最上部をタップして要点だけを確認することも可能。

優先度の高さも認識してくれるので、緊急性の高いものを特定してメールリストの最上部に表示するといったこともできます。

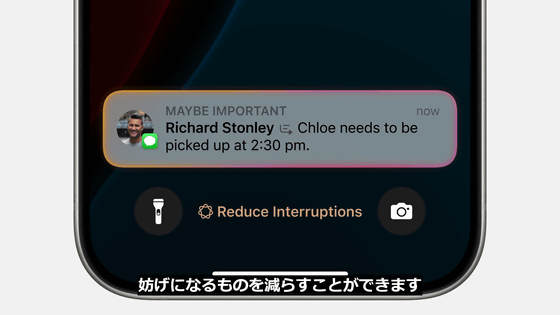

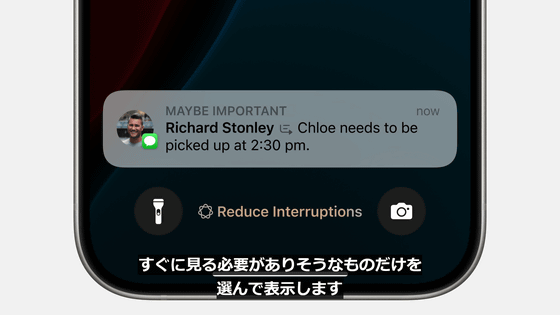

メール同様に、通知画面でも優先度の高い通知を表示することが可能。

さらに、通知内容に素早く目を通せるように、通知は予約されます。

Apple Intelligenceが可能にする新しい集中モードでは、集中の妨げになる情報を減らすことも可能。

すぐにチェックする必要のある情報だけが表示されるようになります。

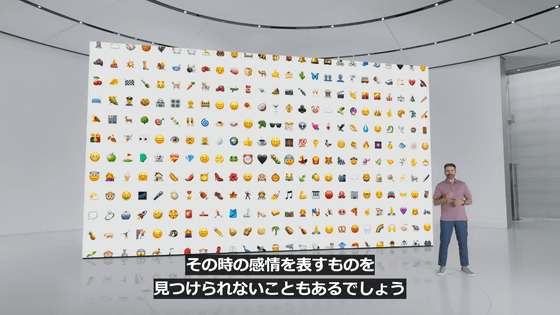

Apple Inteligenceで画像生成も可能になります。

その時の感情を表す適切な画像を自由に生成可能。

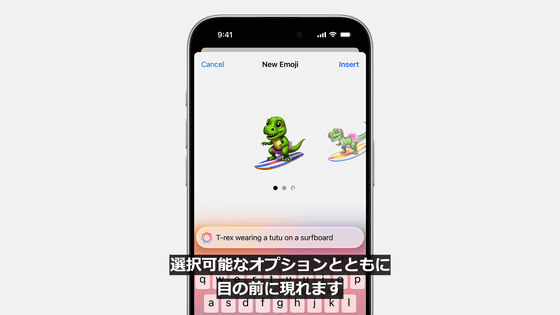

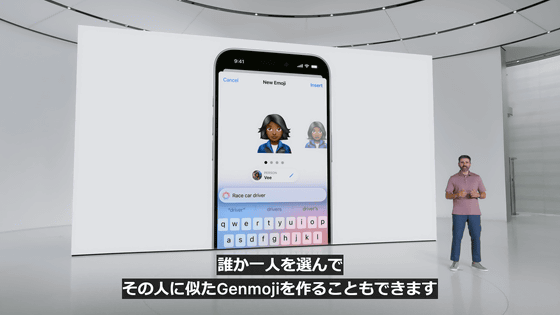

そんな画像生成技術を導入した新機能のひとつが「Genmoji」です。

簡単な説明を入力するだけで選択可能なオプションと共に、Genmojiが表示されます。

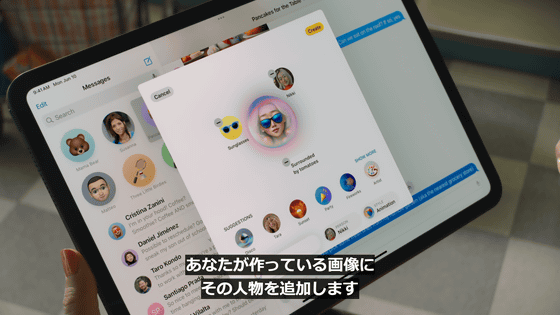

Apple Intelligenceは写真ライブラリの中の人物も認識するので、誰かひとりを選んでその人に似たGenmojiを作ることも可能。

メッセージにインラインでGenmojiを加えることも可能。

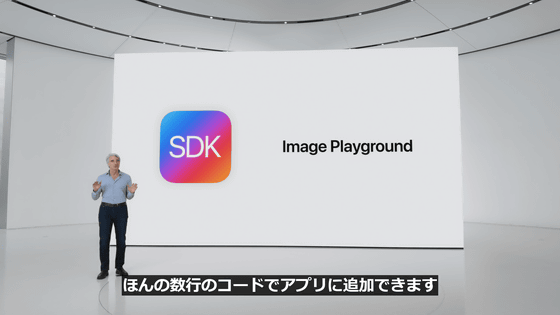

もうひとつの画像生成機能が「Image Playground」です。

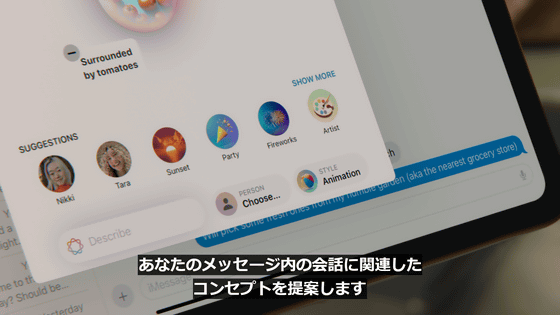

まずはテーマや衣装、アクセサリなどのコンセプトを選択。

するとほんの数秒でApple Intelligenceが画像のプレビューを作成します。

これらはすべてオンデバイスで実行されるとのこと。

会話に沿った画像を作成して友だちに送ることも可能。

説明を入力するだけでImage Playgroundが画像を生成してくれます。

生成される画像は、アニメーション、スケッチ、イラストレーションという3つのスタイルから生成可能。

Apple Intelligenceはユーザーのパーソナルコンテクストを理解するので、ユーザーのメッセージ内の会話に関連したコンセプトを提案してくれます。

ユーザーが作っている画像に、人物を追加することも可能。

Image PlaygroundはKeynoteやPages、フリーボードといったApple純正アプリだけでなく、Image Playground専用アプリでも気軽に画像生成を楽しめるようになります。

さらに、サードパーティーアプリやSNSアプリでも気軽に同機能を使えるように、Image Playground APIが登場予定です。

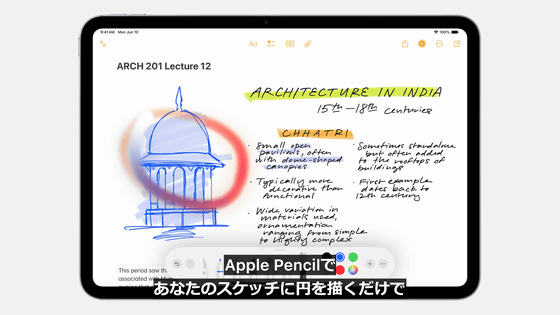

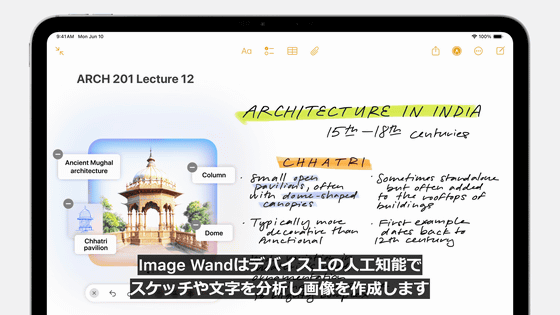

「メモ」アプリの新たなツールであるImage WandもApple Inteligenceを利用しています。

Image Wandはざっくり描いたスケッチを洗練された画像に変換してくれる機能。使うには、Apple Pencilで「メモ」に描いたスケッチ部分をぐるりと囲むだけ。

スケッチや周辺に書かれた文字を認識した上で、画像が自動生成されます。

「写真」アプリにもApple Inteligenceが応用されるとのこと。

写真の編集で、不要な部分を囲むだけで削除してくれます。

また、写真や映像をテキスト入力で探し出すこともできます。

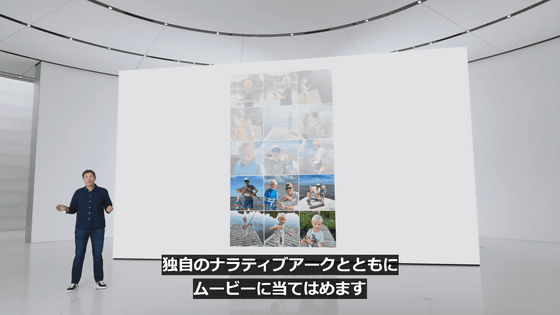

映像の中の一瞬も検索できるので、そのままストーリーラインを作ってメモリーを作成することも可能。

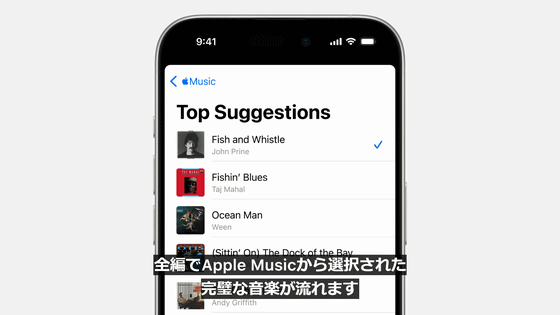

AIが自動でBGMやナレーションをつけてくれます。

さらに「メモ」では音声を録音して書き起こし、要約することもできるとのこと。

この機能は「電話」でも使用可能。

なお、通話中に録音を始めると通知が相手に表示されるそうです。

Apple InteligenceはiOS 18・iPadOS 18・macOS Sequoiaで、無料で利用できます。

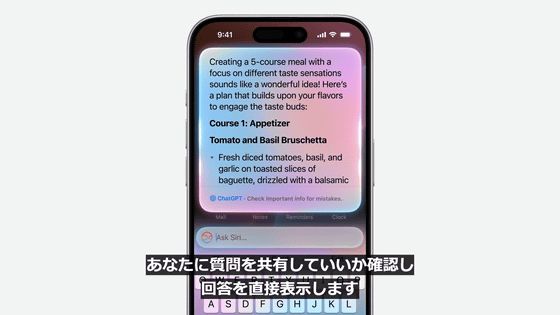

そして、AppleはOpenAIのChatGPTとGPT-4oをApple Intelligenceで利用可能にすることを発表しました。

例えば、Siriに何か質問をすると、SiriがChatGPTと質問を共有していいか確認した上で、回答を表示します。

マルチモーダルモデルであるGPT-4oに対応しているので、写真や書類、PDFファイルの内容についても質問に答えてくれるとのこと。

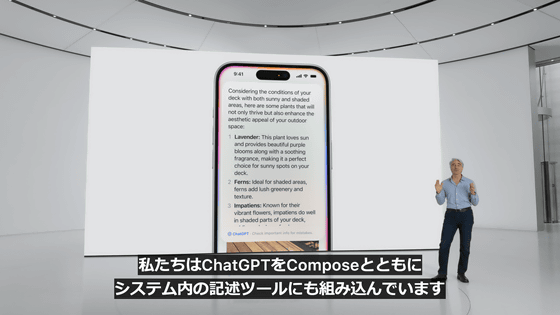

また、ChatGPTはSiriだけでなく、システム内の記述ツールにも組み込まれています。

ChatGPTへのアクセスは無料で、アカウントを作る必要はなし。また、リクエスト内容や情報は記録されないとのこと。

さらにOpenAIアカウントを所有していれば、ログインして直接有料の機能を使うこともできます。

ChatGPT・GPT-4oのiOS 18・iPadOS 18・macOS Sequoiaへの統合は2024年内に予定しているとのこと。

将来的には、ほかのAIモデルのサポートも追加される予定です。

SDKがアップデートされることで、こうしたApple Inteligenceの機能を使うための新しいAPIとフレームワークが用意されます。

つまり、Apple Inteligenceの機能をアプリ開発者も利用できるというわけです。

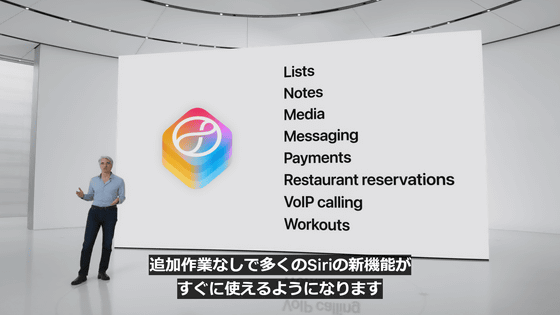

すでにSiriKitを導入している場合は、追加作業なしで多くのSiriの新機能がすぐに使えるようになります。

Apple Intentsフレームワークのインテントは事前に定義され、トレーニングとテストが十分に行われているとのこと。

また、Xcodeに生成AIを統合し、Swiftのコーディングを自動で行う機能やSwiftのコーディングについての質問に応えてくれるアシスタント機能も追加されます。

Apple Inteligenceは2024年夏から、まずはアメリカで試験的に利用できるようになるとのこと。

2024年秋にはベータ版で利用できるようになります。

ほかの言語とプラットフォームについては、2025年にかけて追加される予定です。

なお、AppleはApple Intelligenceの発表内容を5分にまとめた動画も公開しています。

Apple Intelligence in 5 minutes - YouTube

・関連記事

AppleがiPhoneやMacに導入するかもしれないAIシステム「Apple Intelligence」などWWDC2024で期待される内容まとめ - GIGAZINE

AppleとOpenAIの契約が最終調整へ、iOS 18にChatGPTを搭載するとみられる - GIGAZINE

AppleがiOS 18でSiriを刷新しAIによるリアルタイム文字起こしと要約機能を追加するとの報道 - GIGAZINE

Appleが間もなくAI生成の絵文字やOpenAIとの提携を発表するとの報道 - GIGAZINE

AppleはAIアプリのデータをブラックボックスのクラウドで処理してApple社員すらデータにアクセスできないようにする予定 - GIGAZINE

AppleはiOSとmacOSで設定アプリやコントロールセンターの刷新を計画している - GIGAZINE

iOS 18ではFace ID・Touch ID・パスコードを使って純正iPhoneアプリをロックできるようになる予定との報道 - GIGAZINE

AppleがiOS 18でApple純正のパスワードアプリをリリースか、Windowsでも利用可能になるとの報道 - GIGAZINE

・関連コンテンツ

in ソフトウェア, 動画, Posted by logu_ii

You can read the machine translated English article Apple announces new personal AI 'Apple I….