「Llama 2-7B」の1万分の1以下の学習コストなのにLlama 2-7Bを上回る大規模言語モデル「JetMoE-8B」が登場

数千億円をかけた訓練リソースを用いるMetaの「Llama 2-7B」を上回る性能を持ちながら、学習コストは1000万円以下に抑えられるという大規模言語モデル「JetMoE-8B」が登場しました。

JetMoE

https://research.myshell.ai/jetmoe

GitHub - myshell-ai/JetMoE: Reaching LLaMA2 Performance with 0.1M Dollars

https://github.com/myshell-ai/JetMoE

jetmoe/jetmoe-8b · Hugging Face

https://huggingface.co/jetmoe/jetmoe-8b

AI開発企業・MyShellがリリースしたJetMoE-8Bは、学習コストが既存のモデルに比べて格段に低いため、民生グレードのGPUなどでもモデルの微調整が可能だとされています。また、トレーニングに公共データセットのみを使用しているほか、コードはオープンソースでありプロプライエタリなリソースは必要ないことなどを特徴としています。

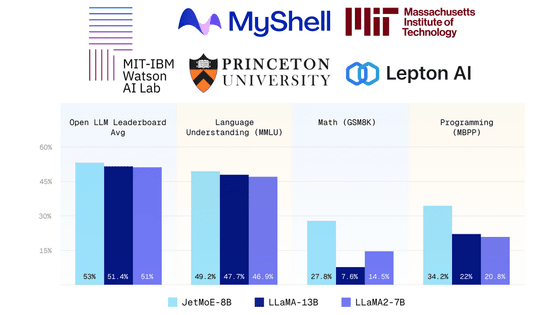

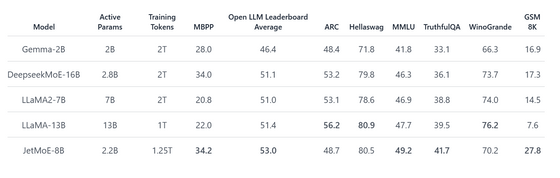

JetMoE-8BをLlama 2-7BやDeepseekMoE-16B、Gemma-2Bなどと比較した数値が以下の通り。JetMoE-8Bの推論中のアクティブパラメーターは2.2Bで、これは計算コストがLlamaなどを下回っていることを意味します。MBPP、MMLUなどのデータセットを用いたベンチマークでは、JetMoE-8BはLlama 2-7Bやその他のモデルを上回るスコアを記録しました。

大規模言語モデルを構築できるデモサイト「Lepton AI」から、JetMoE-8Bの実力を確かめられます。

JetMoE | Lepton AI Playground

https://www.lepton.ai/playground/chat?model=jetmoe-8b-chat

まずはログインが必要なので「Login to chat」をクリック。

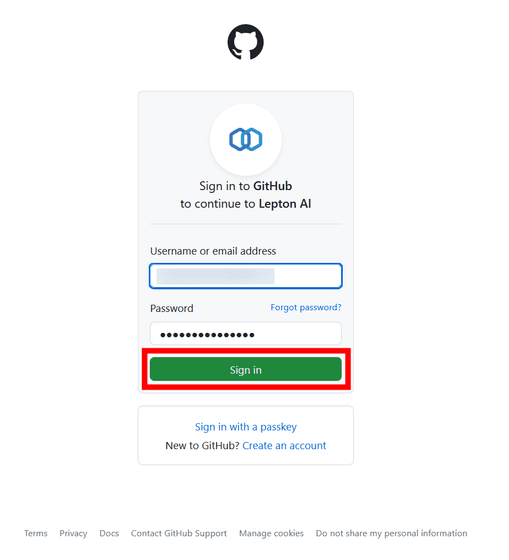

Google、GitHub、LinkedInアカウントを使ったログインが可能。今回は「GitHub」を選択します。

「Sign in」をクリック。

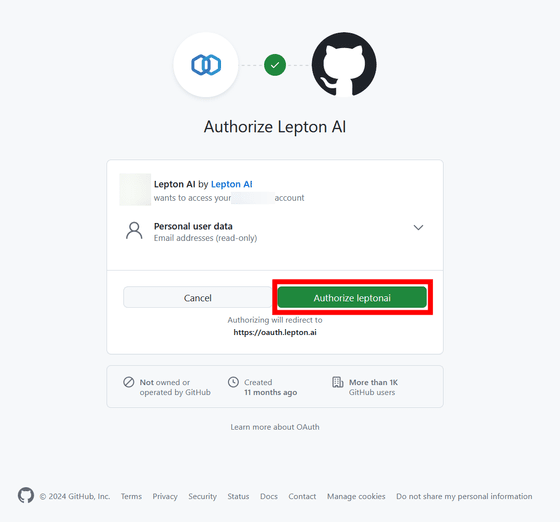

Lepton AIとのアカウントの連携を求められるので「Authorize leptonai」をクリック。

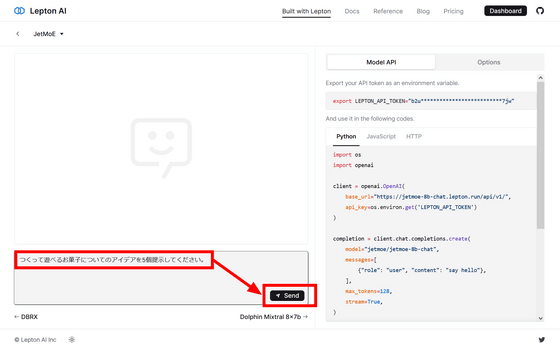

これで使えるようになったので、入力ボックスに文字を入力して「Send」を押してみます。

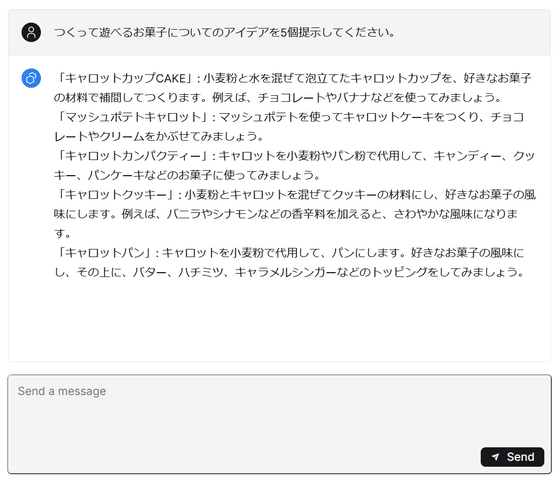

間を置かず、回答が生成されました。

・関連記事

GPT-4の半分以下の計算でほぼ同等なIQを持つパーソナルAI「Pi」と基盤モデル「Inflection-2.5」が登場 - GIGAZINE

Metaがコード生成AIモデルの新バージョン「Code Llama 70B」をリリース、コードの正確性が向上・Pythonに最適化されたバリアントも提供 - GIGAZINE

Databricksがオープンな大規模言語モデル「DBRX」をリリース、GPT-3.5やCodeLLaMA-70Bを上回る性能 - GIGAZINE

Abacus AIがリリースしたオープンソースLLM「Smaug-72B」がHugging FaceのOpen LLM LeaderboardでトップとなりいくつかのベンチマークでGPT-3.5を上回ったことが明らかに - GIGAZINE

Microsoftが小規模言語モデル「Phi-2」をリリース、小規模なのに最大25倍サイズのモデルと同等以上の性能 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article A large-scale language model 'JetMoE-8B'….