大規模言語モデルの計算能力を桁違いに増強するカスタマイズハードウェアを作るスタートアップ「MatX」

「大型のAIモデルに特化して、性能をさらに向上させる」ことを目指してハードウェアを設計するというスタートアップ「MatX」を、元Googleエンジニアのライナー・ポープ氏とマイク・ガンター氏らが創業しました。

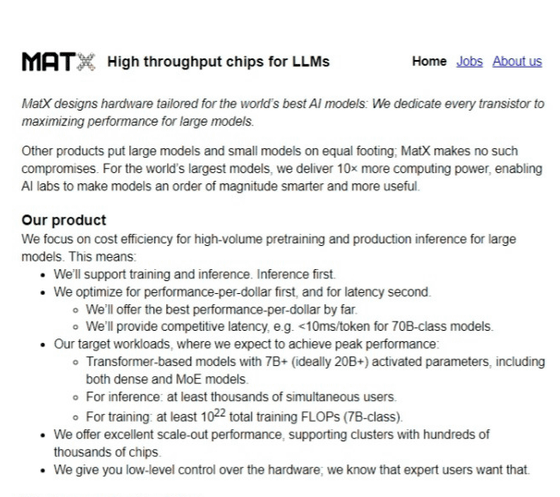

MatX | MatX: high throughput chips for LLMs

https://matx.com/

Introducing MatX: we design hardware tailored for LLMs, to deliver an order of magnitude more computing power so AI labs can make their models an order of magnitude smarter.

— MatX (@MatXComputing) March 26, 2024

Our hardware would make it possible to train GPT-4 and run ChatGPT, but on the budget of a small startup.… pic.twitter.com/6CbDYwLYvT

AI Chip Startups Like MatX Storm Silicon Valley - Bloomberg

https://www.bloomberg.com/news/articles/2024-03-26/ai-chip-startups-like-matx-storm-silicon-valley

CEOでもあるポープ氏は、Googleで10年以上にわたり、機械学習用チップから分散システムインフラ、大規模言語モデルまで、幅広くソフトウェアとハードウェアの構築に携わった人物。そしてCTOのガンター氏は、ハードウェアアーキテクチャを28年担当し、Googleでは機械学習チップのチーフアーキテクトだったという人物です。

MatXは「高性能スルーチップメーカー」を旗印に掲げています。これは、他のチップメーカーであればAIモデルが小規模でも大規模でも等しく扱うのに対して、MatXではすべての半導体を世界最大のAIモデルのパフォーマンスを最大化することに専念しているためです。

MatXの目標は「世界最高のAIモデルを、現実において可能な限り効率的に動作させ、AIの品質と可用性を世界で何年もリードすること」だとのこと。

特に、チップ設計において焦点を当てたのは、大規模モデルのための大容量事前トレーニングと生産推論のためのコスト効率です。サポートの優先順位としては、まず推論、2番目がトレーニングで、コストあたりのパフォーマンスを第一に最適化し、続いてレイテンシーを最適化しているそうです。

ピークパフォーマンスを達成すると予想されるターゲットワークロードは、密集モデルとMoE(混合エキスパート)モデルの両方を含む、70億(理想的には200億以上)のパラメータを持つ大規模なTransformerベースのモデルにおいて、推論の場合は同時ユーザー数が少なくとも数千人、トレーニングの場合は7B(70億パラメータ)クラスのLLMで最低10ZFLOPS(10²²)だとのこと。

数十万個のチップを搭載したクラスタをサポートする、優れたスケールアウト性能が提供されるほか、エキスパートユーザーが求めるハードウェアの低レベル制御も可能です。

MatXのチップによって、世界最高のAIモデルが3~5年は早く登場することになるほか、研究者らは7Bクラスのモデルを毎日トレーニングして、70Bクラスのモデルを月に複数回トレーニングできるようになるとMatXは述べています。また、シードステージのスタートアップでも、GPT-4クラスのモデルをゼロからトレーニングして、ChatGPTレベルのトラフィックで提供する余裕があるとのことです。

・関連記事

GoogleがAI向けチップ「TPU v5p」を発表、前世代から最大2.8倍の性能向上で「Gemini」のトレーニングにも使用される - GIGAZINE

GoogleがAI特化プロセッサTPUの第5世代モデル「TPU v5e」を発表、前モデル比で1ドル当たりのトレーニングパフォーマンス最大2倍・推論パフォーマンス最大2.5倍 - GIGAZINE

AI分野でのNVIDIA一強状態を崩すためにIntel・Google・富士通・Armなどが参加する業界団体がCUDA対抗のAI開発環境を構築中 - GIGAZINE

・関連コンテンツ

in AI, ハードウェア, Posted by logc_nt

You can read the machine translated English article ``MatX'', a startup that creates….