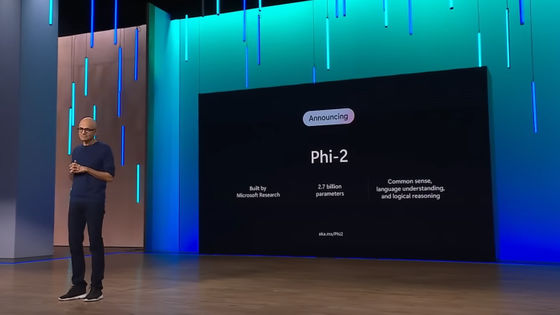

大規模言語モデル(LLM)を爆速で動作させる「言語処理ユニット(LPU)」を開発する「Groq」が爆速アルファデモを公開

大規模言語モデル(LLM)などを実行するために設計されたカスタムハードウェアである言語処理ユニット(LPU)を開発するGroqが、既存のLLMを爆速で動作させることができるアルファ版デモンストレーションを公開しました。

A company called Groq may have pushed AI chips to the next level

https://www.androidheadlines.com/2024/02/openai-groq-ai.html

Forget ChatGPT — Groq is the new AI platform to beat with blistering computation speed | Tom's Guide

https://www.tomsguide.com/ai/forget-chatgpt-groq-is-the-new-ai-model-to-beat-with-blistering-computation-speed

Groqはアメリカのマウンテンビューに本拠地を置くAI関連企業で、これまでにAI、機械学習、ハイパフォーマンスコンピューティングアプリケーション向けの高性能プロセッサやソフトウェアソリューションなどを開発してきました。なお、名前がイーロン・マスク氏のAI企業であるxAIが開発するAIチャットボットであるGrokと非常に似ていますが、これとは全くの別物です。

通常、AIツールは並列グラフィックス処理用に最適化されたGPUを用いて計算処理を行います。これはGPUが計算処理を迅速に実行可能で、一般的には非常に効率的にこれをこなすためです。例えばLLMのひとつであるGPT-3では、GPUを用いてプロンプトを分析し、その前後にどのような単語が続くかについて一連の予測を行い機能します。

これに対して、Groqが開発しているLPUは既存のLLMを爆速で動作させるために設計されたチップとなっており、一連のデータ(DNA、音楽、コード、自然言語など)を処理するべく特別設計されているため、GPUよりもはるかに優れたパフォーマンスを発揮可能です。

Wow, that's a lot of tweets tonight! FAQs responses.

— Groq Inc (@GroqInc) February 19, 2024

• We're faster because we designed our chip & systems

• It's an LPU, Language Processing Unit (not a GPU)

• We use open-source models, but we don't train them

• We are increasing access capacity weekly, stay tuned pic.twitter.com/nFlFXETKUP

Groqは独自のLLMを開発しているわけではありませんが、既存のLLMを用いてGPUベースの処理よりも最大10倍高速にLLMを実行できるアルファ版のデモンストレーションを公開しています。

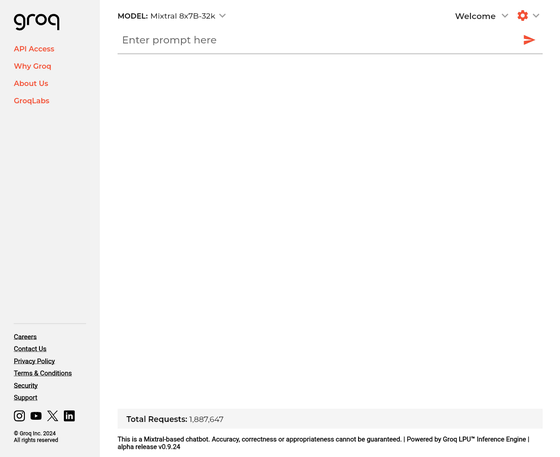

Groq

https://groq.com/

使い方は簡単で、画面上部の「Enter prompt here」にテキストを入力して、紙飛行機アイコンをクリックするだけ。

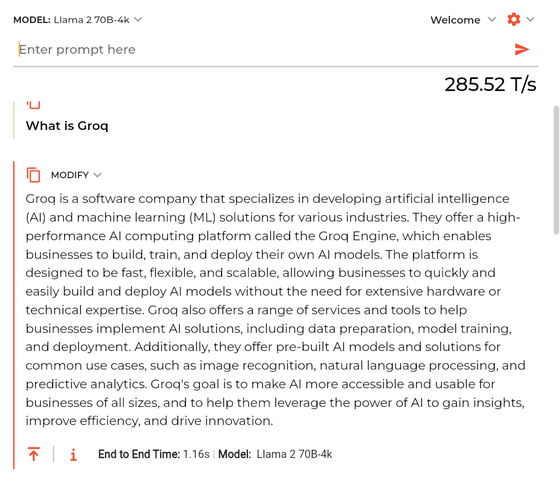

すると回答と回答の出力にかかった時間(285.52T/s)が表示されます。

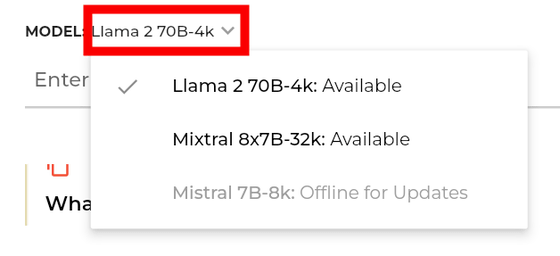

なお、GroqのデモンストレーションではMetaが開発する「Llama 2 70B」と、Mistral AIが開発する「Mixtral 8x7B」のいずれかを利用できるようになっており、モデルの切り替えは画面左上から可能です。

・関連記事

1万種類を超える大規模言語モデル(LLM)をまとめてダウンロード数や類似性などを分かりやすく視覚化したデータライブラリが公開される - GIGAZINE

大規模言語モデルの開発者が知っておくと役立つさまざまな数字 - GIGAZINE

GPU非搭載ノートPCでもコマンド不要で各種言語モデルの性能を試せる実行環境「LM Studio」レビュー - GIGAZINE

Appleは大規模言語モデルをiPhone上でローカルに動作させることを目指している - GIGAZINE

・関連コンテンツ

in ネットサービス, ハードウェア, Posted by logu_ii

You can read the machine translated English article ``Groq'', which develops ``Langu….