AMDのAI特化型チップ「MI300X」がNVIDIA製チップ「H100」と同等の環境で最大2.1倍のパフォーマンス性能を発揮したことが報告される

2023年12月6日に発表されたAMDのAI特化型チップ「MI300X」は、NVIDIA製AI特化型チップ「H100」と比べて優れた性能を発揮できることがアピールされています。一方でNVIDIAはMI300XとH100の比較の際のテスト環境が同一ではなかったと主張しました。そこでAMDはNVIDIAの指摘に対する検証を行いました。

AMD strikes back at Nvidia with new MI300X benchmarks — MI300X shows 30% higher performance than H100, even with an optimized software stack | Tom's Hardware

https://www.tomshardware.com/pc-components/gpus/amd-strikes-back-at-nvidia-with-new-mi300x-benchmarks-mi300x-shows-30-higher-performance-than-h100-even-with-an-optimized-software-stack

2023年12月6日にAMDが発表したAI特化型チップ「MI300X」は、多くの用途でMI300XのGPUユニットがH100の性能を上回っていることがアピールされています。

AMDのAI特化型チップ「MI300X」はChatGPTにも使われるNVIDIA製チップ「H100」を超えられるのか? - GIGAZINE

一方で、NVIDIAは「MI300XとH100のパフォーマンス比較の際に、H100用に最適化されたソフトウェア『TensorRT-LLM』を使用していなかった」と主張。適切なソフトウェアを用いることで、H100の性能はMI300Xの性能を上回ると述べています。

NVIDIAによると、H100などのAI特化型チップはNVIDIA独自の「TensorRT-LLM」で最適な動作を行うように設計されており、オープンソースで広く使用されている「vLLM」では性能がダウンするとのこと。

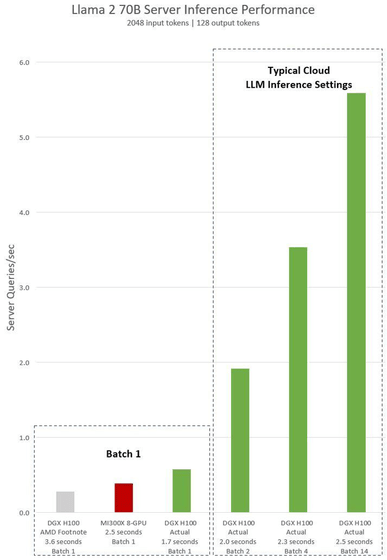

そこでNVIDIAはTensorRT-LLMを用いた際のMI300XとH100のパフォーマンス比較を実施。1秒間に処理できるクエリの数を比較した結果、圧倒的にH100がMI300Xの性能を上回ったと報告しました。

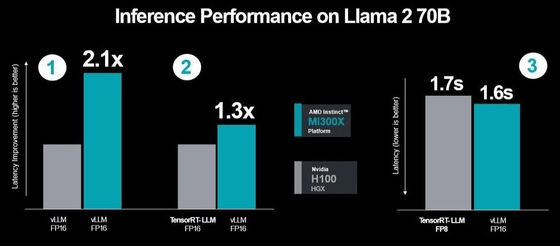

これを受けてAMDもMI300XとH100の性能を比較するテストを実施。AMDによると、お互いにvLLMを利用し、FP8での比較を行った場合、MI300XがH100の約2.1倍のスコアを示し、さらにH100がTensorRT-LLMを利用し、MI300XがvLLMを利用した場合でもMI300XがH100の約1.3倍のスコアになったとのこと。さらに、「TensorRT-LLMを利用、FP8」のH100と「vLLM利用、FP16」のMI300Xを比較すると、MI300Xの方がレイテンシーが約0.1秒低減していることが明らかとなりました。

海外メディアのTom's Hardwareは「NVIDIAが今回のAMDによるパフォーマンステストを受けてどのように対応するかは、NVIDIAに委ねられています」と述べています。

・関連記事

AMDのAI特化型チップ「MI300X」はChatGPTにも使われるNVIDIA製チップ「H100」を超えられるのか? - GIGAZINE

AMDが最大192GBのメモリをサポートした生成AI向けアクセラレータ「AMD Instinct MI300X」を発表 - GIGAZINE

AMDがAIチップ「Instinct MI300」シリーズでNVIDIAの牙城に切り込む、既にOpenAI・Microsoft・Meta・Oracleが採用を決定 - GIGAZINE

大規模言語モデルの出力スピードを最大24倍に高めるライブラリ「vLLM」が登場、メモリ効率を高める新たな仕組み「PagedAttention」とは? - GIGAZINE

AMDがAI特化チップを備えたモバイルプロセッサ「Ryzen 8040」シリーズを発表、従来モデルの1.6倍のAI処理性能を実現 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1r_ut

You can read the machine translated English article It is reported that AMD's AI special….