簡単なテキストから写実的な動画を生成する拡散モデル「W.A.L.T」が登場

スタンフォード大学やGoogleの研究チームが、テキストから写実的な動画を生成する拡散モデルである「W.A.L.T」を発表しました。実際に「W.A.L.T」を使用して生成した動画も多数公開されています。

W.A.L.T.pdf

https://walt-video-diffusion.github.io/assets/W.A.L.T.pdf

Photorealistic Video Generation with Diffusion Models

https://walt-video-diffusion.github.io/

「W.A.L.T」は、Googleなどが発表した深層学習モデルのTransformerをベースにした動画生成AIです。研究チームのアグリム・グプタ氏は、W.A.L.Tの仕組みについてX(旧Twitter)へのポストで触れています。

We introduce W.A.L.T, a diffusion model for photorealistic video generation. Our model is a transformer trained on image and video generation in a shared latent space. ???????? pic.twitter.com/uJKMtMsumv

— Agrim Gupta (@agrimgupta92) December 11, 2023

W.A.L.Tでは、まず因果3Dエンコーダーを使用して共有潜在空間内の画像を動画を圧縮します。

2/ website: https://t.co/atH5wzRudu

— Agrim Gupta (@agrimgupta92) December 11, 2023

Our approach has two key design decisions. First, we use a causal encoder to compress images and videos in a shared latent space. pic.twitter.com/5YlLU2NaHa

次に記憶とトレーニングの効率を高めるため、潜在空間での空間的・時間的共同生成モデリング用に調整されたウィンドウ・アテンション・アーキテクチャを使用するとのこと。

3/ Second, for memory and training efficiency, we use a window attention based transformer architecture for joint spatial and temporal generative modeling in latent space. pic.twitter.com/0uxVdRqlPL

— Agrim Gupta (@agrimgupta92) December 11, 2023

これにより、自然言語のプロンプトから写実的かつ時間的な一貫性のあるモーションを生成できるようになっています。

4/ Our model can generate photorealistic, temporally consistent motion from natural language prompts. pic.twitter.com/emH6nb8gkm

— Agrim Gupta (@agrimgupta92) December 11, 2023

実際に研究チームは、W.A.L.Tを使用して生成した動画の例を多数公開しています。以下はその一例です。

テキストから動画を生成するAIモデル「W.A.L.T」で作られた「ピラミッドの前でスローで踊る黒いジャケットを着たアライグマ」の動画 - YouTube

テキストから動画を生成するAIモデル「W.A.L.T」で作られた「水に囲まれた美しい城の空撮」の動画 - YouTube

テキストから動画を生成するAIモデル「W.A.L.T」で作られた「夕暮れ時にVRゴーグルを装着した犬」の動画 - YouTube

テキストから動画を生成するAIモデル「W.A.L.T」で作られた「馬に乗る宇宙飛行士」の動画 - YouTube

テキストから動画を生成するAIモデル「W.A.L.T」で作られた「誕生日の帽子をかぶってビーチを歩く象」の動画 - YouTube

研究チームが公開しているその他の動画は、以下のウェブページで視聴することが可能です。

Photorealistic Video Generation with Diffusion Models

https://walt-video-diffusion.github.io/samples.html

・関連記事

テキストや画像から動画を生成するAI「Stable Video Diffusion」をStability AIが公開へ - GIGAZINE

NVIDIAがテキストから高解像度の映像を生成するAIモデル「VideoLDM」を発表 - GIGAZINE

ムービーとテキストからフレーム間の一貫性を維持して実用性の高いムービーを生成するAI「StableVideo」 - GIGAZINE

無料で使えるムービー生成AI「Text2Video-Zero」が登場したので実際に使ってサクッとムービーを作ってみた - GIGAZINE

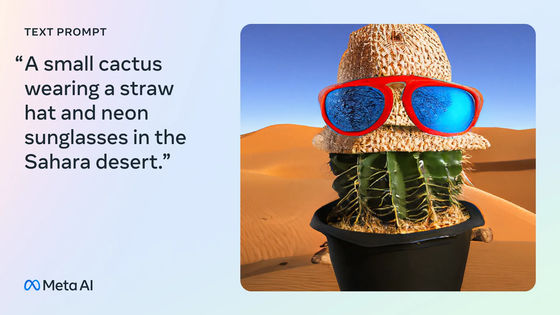

Metaが文章から違和感ゼロの動画を生成するAI「Emu Video」&文章で指示して画像を編集できるAI「Emu Edit」を発表 - GIGAZINE

テキストから動画を生成できるAI「Runway Gen 2」登場、ジェネレーティブAIの主戦場はついに映像へ - GIGAZINE

文字・音楽・画像を同時に処理する「マルチモーダルAI」の性能がよく分かるGoogleの「Gemini」ハウツー動画11種を解説 - GIGAZINE

テキストで命令するだけで画像や動画を自動で加工してくれる「Text2LIVE」 - GIGAZINE

・関連コンテンツ

in AI, 動画, ソフトウェア, Posted by log1h_ik

You can read the machine translated English article Introducing WALT, a diffusion model that….