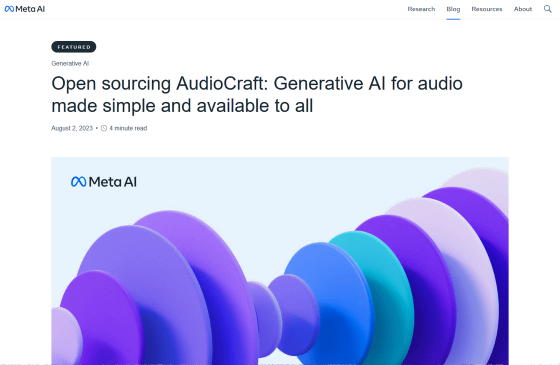

テキストから音楽や効果音を生成するためのオープンソースなAIツール「AudioCraft」をMetaが発表

近年はAI技術が急速に進歩しており、高精度なテキストや画像を生成するAIが登場しています。新たに、FacebookやInstagtramなどを運営するMetaが、テキストを基に音楽や効果音を生成するオープンソースのAIツール「AudioCraft」を発表しました。

AudioCraft: A simple one-stop shop for audio modeling

https://ai.meta.com/blog/audiocraft-musicgen-audiogen-encodec-generative-ai-audio/

Meta releases AudioCraft AI tool to create music from text | Reuters

https://jp.reuters.com/article/meta-platforms-ai/meta-releases-audiocraft-ai-tool-to-create-music-from-text-idUSL4N39J3PA

Meta releases open source AI audio tools, AudioCraft | Ars Technica

https://arstechnica.com/information-technology/2023/08/open-source-audiocraft-can-make-dogs-bark-and-symphonies-soar-from-text-using-ai/

Metaは公式ブログにおいて、近年の大規模言語モデルを搭載したAIはテキスト生成や機械翻訳、音声対話エージェント、画像および動画の生成などで大きな進歩を遂げている一方、オーディオ分野では遅れがみられると指摘。もちろん、過去にはテキストから音楽を生成するAIがたびたび発表されてきましたが、それらは複雑であまりオープンでなかったため、人々が簡単に試すのは難しかったとMetaは述べています。

忠実度の高いオーディオを生成するには、複雑な信号とパターンをさまざまなスケールでモデリングする必要があります。特に音楽は、一連の音符や複数の楽器からなる音楽構造を持っているため、生成するのが難しいタイプのオーディオだそうです。Metaによると、テキストベースの生成モデルで用いられるサンプルは1つあたり数千のタイムステップで構成されていますが、標準品質の44.1kHzで録音された一般的な数分の音楽サンプルは、1つで数百万ものタイムステップで公正されているとのこと。

そこでMetaは、音楽を生成する「MusicGen」、効果音などの音声を生成する「AudioGen」、ニューラルネットワークベースのオーディオ圧縮コーデックである「EnCodec」という3つのモデルで構成されたオープンソースのオーディオ生成AIツール「AudioCraft」を発表しました。MusicGenはMetaが所有する合計約2万時間に及ぶメタデータ付き音楽でトレーニングされており、AudioGenはパブリックな効果音でトレーニングされているとMetaは説明しています。

以下のX(旧Twitter)への投稿に埋め込まれた動画を再生すると、AudioCraftに「Movie-scene in a desert with percussion(打楽器を使った砂漠の映画シーン)」「80s electric with drum beats(ドラムビートのある80年代エレクトリック)」「Jazz instrumental, medium tempo, spirited piano(ジャズのインストゥルメンタル、ミディアムなテンポ、元気なピアノ)」といったプロンプトを入力して生成された音楽を聞くことができます。

???? Today we’re sharing details about AudioCraft, a family of generative AI models that lets you easily generate high-quality audio and music from text.https://t.co/04XAq4rlap pic.twitter.com/JreMIBGbTF

— Meta Newsroom (@MetaNewsroom) August 2, 2023

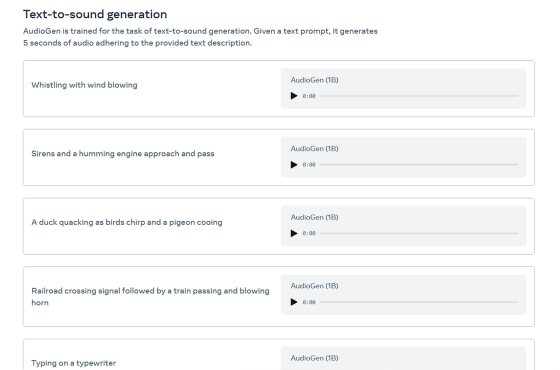

また、公式サイトではAudioCraftを使用して、「Whistling with wind blowing(風が吹く中で口笛を吹く)」「Sirens and a humming engine approach and pass(サイレンとエンジン音が近づいて通り過ぎる)」といったプロンプトで生成されたさまざまな効果音を聞くことが可能です。

AudioCraftのモデルはオープンソースで公開されており、人々が研究目的やテクノロジーへの理解を深めるために利用できます。Metaはブログの中で、「AudioCraftのコードを共有することで、他の研究者が生成モデルの潜在的なバイアスや誤用を制限または排除するための新しいアプローチを、より簡単にテストできるようになることを願っています」「責任あるイノベーションは、単独では実現できません。私たちの研究と結果のモデルをオープンソース化することで、誰もが平等にアクセスできるようにすることができます」と述べました。

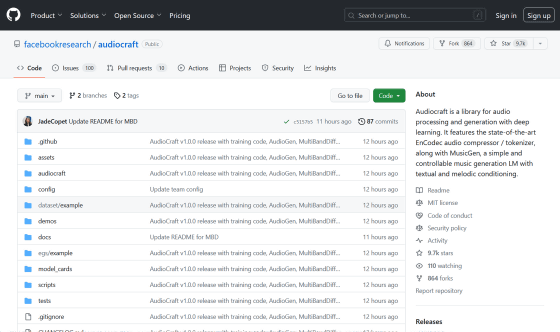

AudioCraftのコードは、以下のGitHubリポジトリで閲覧することが可能です。

GitHub - facebookresearch/audiocraft: Audiocraft is a library for audio processing and generation with deep learning. It features the state-of-the-art EnCodec audio compressor / tokenizer, along with MusicGen, a simple and controllable music generation LM with textual and melodic conditioning.

https://github.com/facebookresearch/audiocraft

・関連記事

Metaが音楽生成AIモデルをオープンソースで公開、テキスト&音声入力で誰でも高品質な音楽を作成できるように - GIGAZINE

Metaが開発した音声生成AI「Voicebox」は「他人の声で文章を勝手に読ませる」ことが可能、危険過ぎるのでMetaは一般公開を避ける - GIGAZINE

文字・画像と映像・音・3D深度・熱・動作を統合して現実世界を理解できるAI「ImageBind」をMetaがオープンソースで公開 - GIGAZINE

AIで作った「AI音楽」が流行、Discord上には2万人超が集まる人気サーバーも - GIGAZINE

Googleがテキストから音楽を自動生成するAIモデル「MusicLM」を公開へ、学習用データセットの倫理的課題もクリア - GIGAZINE

人気歌手が「AIで自分の声から曲を作ってもOKでペナルティなし」と発表 - GIGAZINE

「AIが生成した数万もの楽曲」を音楽ストリーミングサービスのSpotifyが削除、不正な再生数の水増しが原因か - GIGAZINE

グラミー賞主催団体が音楽におけるAI利用への見解を発表、音楽でのAI使用はOKだが完全にAIで生成された曲は禁止 - GIGAZINE

・関連コンテンツ

in ソフトウェア, ネットサービス, 動画, アート, Posted by log1h_ik

You can read the machine translated English article Meta announces open source AI tool '….