Googleが視覚とテキストから人間のように理解するロボット向け言語モデル「PaLM-E」を発表、「お菓子を持ってこい」などの複雑な命令も遂行可能

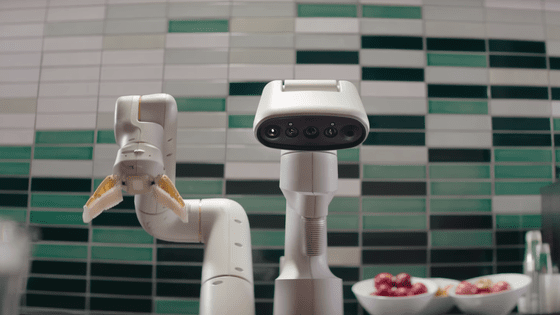

対話型AI「ChatGPT」などに使われる言語モデルは複雑なタスクを実行することが実証されていますが、これをロボットに応用する場合、状況にあった動作を行うために言語モデルはより詳しい情報を収集する必要があります。Googleとベルリン工科大学のAI研究者グループは、カメラで捉えた映像とテキストによる指示を理解できる新しい言語モデル「PaLM-E」を開発したことを明らかにしました。このモデルを使うことにより、「引き出しからお菓子を持ってきて」というような複雑な命令をロボットが処理できるようになります。

PaLM-E: An Embodied Multimodal Language Model

https://palm-e.github.io/

Google’s PaLM-E is a generalist robot brain that takes commands | Ars Technica

https://arstechnica.com/information-technology/2023/03/embodied-ai-googles-palm-e-allows-robot-control-with-natural-commands/

PaLM-Eは事前に訓練された言語モデルに画像や状況、命令文といった情報を組み込んで処理を行う言語モデルです。5400億のパラメーターで人間の言語を理解して複雑なタスクを実現する事前学習済みの言語モデル「Pathways Language Model(PaLM)」にロボットという体を与えた(Embodied)ことから、PaLM-Eと名付けられました。Googleの画像認識モデル「ViT」が持つ220億のパラメーターと合わせることで、PaLM-Eは合計5620億ものパラメーターを持つことになります。これは、ChatGPTに用いられる言語モデル「GPT-3」の1750億と比較しても膨大なものです。

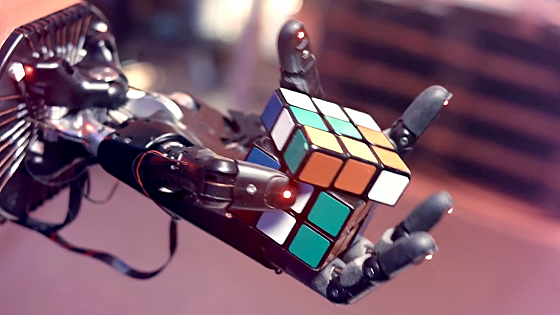

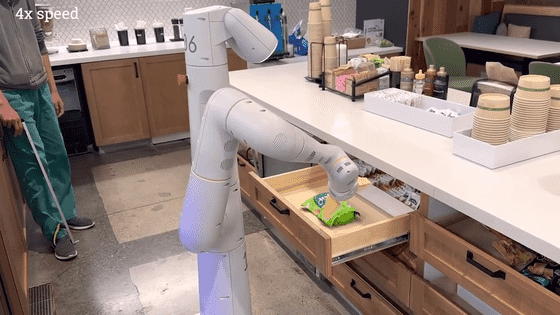

Google Roboticsのロボットと連携したPaLM-Eに「引き出しからライスチップを持ってきて」といった命令を与えると、PaLM-Eはロボットの行動計画を生成し、ロボットを動かすことができます。以下の動画では実際にロボットがライスチップを持ってくる様子が示されており、ロボットは「引き出しとは何か」「ライスチップとは何か」「持っていくとはどういうことなのか」を正しく理解しているような動作を行っています。また、丁寧に引き出しを閉めるという動作も実行しました。

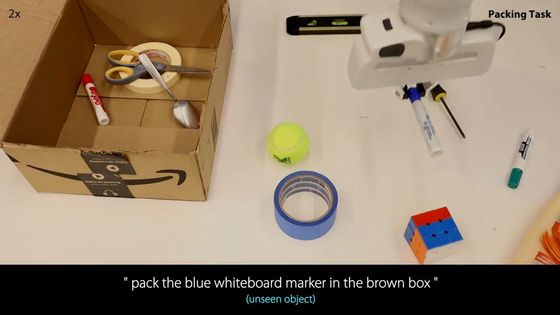

以下の動画では、「緑の星を持ってきて」という命令をロボットが処理している様子を見ることができます。なお、PaLM-Eは「緑色の星とは何か」を事前に教えられておらず、言語モデルや視覚から推論した情報を元に行動計画を生成しています。

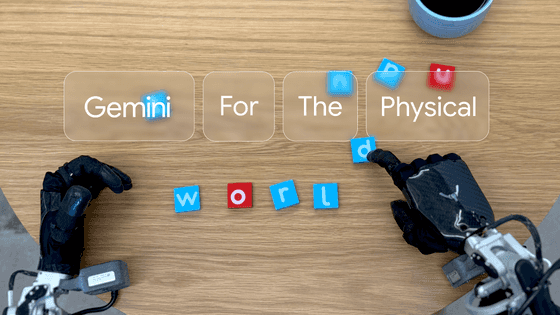

次の動画では、PaLM-Eがテーブル上のロボットアームを制御してブロックを並べる様子が紹介されています。PaLM-Eは「ブロックを色別で四隅に並べて」という命令をこなしていますが、このとき「緑色の星を角まで押す」「緑色の丸を緑色の星まで押す」などの計画を順番に立てています。

以下の動画でPaLM-Eは「緑色のブロックをカメに押しつけて」という命令をこなしていますが、PaLM-Eはカメを見たことがないにもかかわらず、命令を正確に実行したとのこと。ロボットのカメラから得たデータを分析することで、PaLM-Eは細かな事前学習を必要とせずに命令を実現できます。

PaLM-Eはロボットの行動計画を生成できるだけでなく、画像を分析して処理する能力にも優れています。

例えば、PaLM-Eに以下の画像データを入力して、「この写真でプレーしている2つのチームはどこで、最後に優勝したのはどちらで、何年に優勝したのか、その年のスター選手は誰?」と訪ねると、PaLM-Eは「順番に考えてみましょう。白のチームはニューヨーク・ニックス。緑のチームはボストン・セルティックスです。最後に優勝したのはボストン・セルティックスです。年は2008年。スター選手はポール・ピアースでした。私はバスケットボールのファンではないので、これが正しいかどうか分かりません。ググっただけです(I just google it.)」と答えたとのこと。

次の画像を確認し、「右のピンク色のドーナツは何味?」と聞かれたPaLM-Eは、「右」「ピンク色」「ドーナツ」が何を指しているのか、「ドーナツの直上にあるラベルは、直下のドーナツの味を書いている」ということ、「STRAWBERRYという文字」「STRAWBERRYが味であること」などを把握し、正しく「ストロベリー」と返します。同様に「左のドーナツは何味?」と聞かれても、正しく「ブルーベリー」と返したとのこと。

以下の画像について「ロボットは次に何をする?」と訪ねると、PaLM-Eは「落ちる」と答えます。人間が見ればロボットが重力に従い倒れかけているというのが瞬時に分かりますが、PaLM-Eも同じように状況を把握したというわけです。

以下の画像で「もしこの場所でロボットが役に立ちたいと考えたとき、何をすればいいでしょうか」と訪ねられたPaLM-Eは、「テーブルを片付ける、ゴミを拾う、椅子を拾う、椅子を拭く、椅子を置く」と答えています。

「自転車以外進入禁止」であることを示した道路標識もPaLM-Eは把握し、「この通りを自転車で通れますか?」という質問に「はい」と正しく答えました。

Googleの研究者は、PaLM-Eに見られた「タスクを通じて学習した知識やスキルを別のタスクに応用することができる」という点に着目しており、ひとつのタスクしかこなせないロボットモデルと比較して「著しく高いパフォーマンス」を発揮するという評価を下しています。研究者は、ホームオートメーションや産業用ロボットなど、実世界のシナリオにPaLM-Eを応用することを検討しています。

・関連記事

Googleが「人間の言葉を理解して状況に応じて行動するお手伝いロボット」をお披露目 - GIGAZINE

Googleが「知らない言語」も翻訳処理ができてしまう言語モデル「LaBSE」を発表 - GIGAZINE

Metaが大規模言語モデル「LLaMA」を発表、GPT-3に匹敵する性能ながら単体のGPUでも動作可能 - GIGAZINE

自然なブログを書いてしまうほど超高精度な言語モデル「GPT-3」はどのように言葉を紡いでいるのか? - GIGAZINE

・関連コンテンツ

in ハードウェア, ソフトウェア, Posted by log1p_kr

You can read the machine translated English article Google announces a language model 'P….