ChatGPTが研究論文の著者に名を連ねていることに出版社や論文リポジトリは反対している

OpenAIが開発したChatGPTは、人間が書いたような自然な文章を高い精度で生成する言語モデル・GPT-3の派生がベースになっており、文章を入力するとまるで人間と会話しているように感じられるほど自然に対話することが可能です。そんなChatGPTが著者として名前を連ねている論文がすでに登場していると、学術誌のNatureが報告しています。

ChatGPT listed as author on research papers: many scientists disapprove

https://www.nature.com/articles/d41586-023-00107-z

すでにChatGPTなどのAIが研究論文の著者にクレジットされているケースは少なくとも4件が確認されています。

例えば、医学系論文リポジトリであるmedRxivに投稿された未査読論文の著者の1人にChatGPTの名前が並んでいます。この論文は、アメリカの医師免許試験を使ってChatGPTのパフォーマンスを評価するというものでした。

Performance of ChatGPT on USMLE: Potential for AI-Assisted Medical Education Using Large Language Models | medRxiv

https://doi.org/10.1101/2022.12.19.22283643

medRxivとその姉妹リポジトリであるbioRxivの運営チームは、研究論文を書く際にAIツールを使った場合、著者名にChatGPTを入れることが適切かどうかを議論しているとのこと。medRxivの共同設立者であるリチャード・セヴァー氏は「学術論文の著者は、『文章の書き手』という一般的な意味合いでの著者とは区別する必要があります。著者は自分の作品に対して法的責任を負うため、人だけが記載されるべきです」とコメントしました。もちろん過去にはペットや架空の人物が学術論文の著者に記載された例はありますが、「それは単にチェックの問題であり、ルールの問題とは別です」とセヴァー氏は述べています。

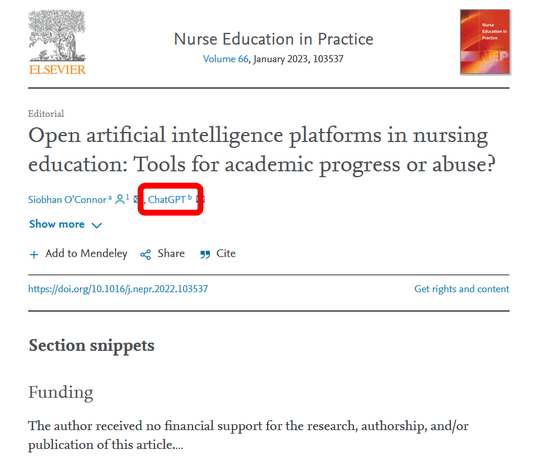

また、学術誌「Nurse Education in Practice」2023年1月号に掲載された「看護教育におけるオープンな人工知能プラットフォーム:学術的進歩を遂げるか、乱用か?」という論文にも、ChatGPTが論文共著者としてクレジットされています。ただし、Nurse Education in Practiceの編集長であるロジャー・ワトソン氏によると、このクレジットは誤って記載されたものだとのこと。

Open artificial intelligence platforms in nursing education: Tools for academic progress or abuse? - ScienceDirect

https://doi.org/10.1016/j.nepr.2022.103537

Natureをはじめとする学術誌出版社の多くは、「ChatGPTなどのAIは学術論文の内容や整合性に責任を持つことができないため、研究著者としての基準を満たしていない」としています。Natureの編集長であるマグダレナ・スキッパー氏は「著作者には論文に対する説明責任が伴いますが、これを言語モデルAIに適用することはできません」とコメントし、AIを使ったのであれば使用方法を論文内の手法説明あるいは謝辞のセクションに記載すべきだとしています。

また、Scienceの編集長であるホールデン・ソープ氏は「私たちは、AIを論文の著者として記載することを許しませんし、適切な引用なしにAIが生成したテキストを使用することは盗用と見なされかねないと考えています」と述べています。

未査読論文リポジトリであるarXivの理事会は内部で議論を重ねているとのこと。arXivの科学ディレクターで天文学者のスタイン・シグルドソン氏は「AIなどのソフトウェアは利用規約やコンテンツの配布に同意することができないため、投稿論文の著者になり得ない」という意見を支持しています。記事作成時点ではChatGPTが著者の論文はarXivに登録されていないそうですが、近い内に論文著者向けのガイダンスを公開する予定だとシグルドソン氏は述べています。

香港の製薬企業であるインシリコ・メディシンのアレックス・ザボロンコフCEOは、AIによる製薬を事業として展開すると同時に、AIを使って80以上の論文を発表しているとのこと。そして2022年に発表した(PDFファイル)論文で、ChatGPTを論文の共著者にクレジットしています。ザボロンコフCEOによれば、ChatGPTに同じ質問を何度もすると、違う答えが返ってくることもあったとのこと。ザボロンコフCEOは「私は、学問の世界でAIが悪用されないか心配しています。その分野の専門知識がない人でも学術論文を書こうと思えば書けてしまうのですから」と述べました。

・関連記事

対話AI「ChatGPT」が書いた論文の要旨を研究者は見分けることができないという報告 - GIGAZINE

OpenAIの「ChatGPT」と元OpenAIエンジニアが開発した「Claude」の性能を比較した実験結果 - GIGAZINE

「ChatGPTを改善するためにOpenAIが時給300円以下でケニア人を雇った」と問題視する報道 - GIGAZINE

ChatGPTやStable Diffusionを生み出した「機械学習ソフトウェア」の10年間の流れを専門家が解説 - GIGAZINE

対話AI「ChatGPT」は教育現場で活躍するため禁止するのではなく使い方を教えるべきという指摘 - GIGAZINE

音声会話が可能で笑顔も見せるバーチャルな「俺の嫁」をChatGPTやStable Diffusionで構築して最終的に安楽死させるに至るまで - GIGAZINE

・関連コンテンツ

in ソフトウェア, サイエンス, Posted by log1i_yk

You can read the machine translated English article Publishers and research repositories obj….