アルゴリズムに含まれるバイアスをなくすための「バイアス報奨金プログラム」の考え

人種に関するデータが存在しないはずの医療システムで黒人が不平等な扱いを受ける人種差別が存在したり、超高精度な文章生成AI「GPT-3」に反イスラム教的なバイアスが存在したりと、時として、アルゴリズムにはバイアスがかかっていることがあり、その影響で傷つく人が出ることがあります。この問題を解決するために、AI研究などを行う専門家が、バイアスの発見に対して報奨金を支払うプログラムを考えています。

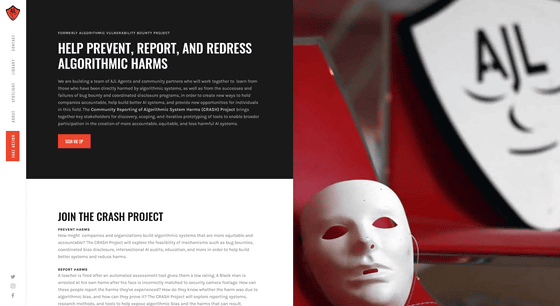

Algorithmic Vulnerability Bounty Project (AVBP)

https://www.ajl.org/avbp

Me & @camillefrancois's @mozillafestival discussion of @AJLUnited's CRASH project got a news feature!

— Deb Raji (@rajiinio)

"If we had a harms discovery process that, like in security, was ...robust, structured & formalized, that would help the community gain credibility"https://t.co/ADbdDgca0v

Using bug bounties to spot bias in AI algorithms

https://www.computing.co.uk/news/4028677/bug-bounties-bias-algorithms

「報奨金を出すことでアルゴリズムに含まれるバイアスを見つけてもらう」という発想は、ネットサービスやソフトウェアなどで行われている、バグ報奨金プログラムの考えを採用したものです。

このプロジェクトを推進しているのは、研究者のデボラ・ラジ氏ら。ラジ氏は2019年に、Amazonの顔認証API「Amazon Rekognition」に人種差別的な偏りがあるという研究結果を発表したことがあります。

「Amazonの顔認証ソフトの差別性」を巡りAmazonとMITの研究者が対立する - GIGAZINE

アルゴリズムに含まれるバイアスについては、MicrosoftやFacebookなどの大手企業はちゃんと認識していて取り組みを行っているものの、有効な解決策はまだ出ていないとのこと。

ラジ氏らの取り組みについては、「アルゴリズムによりなされる害」の定義が難しいことが判明。また、アルゴリズム内のバイアスを検出する方法論の確立がなされていないなど、課題が残っています。

また、仮に方法論が確立されたとしても、アルゴリズムを使用している企業がバイアスの修正によって経済的利益を得られる可能性は低く、「Amazon Rekognition」の一件のように反発を受けるだけだと推測されています。

このため、ラジ氏らは「バイアス報奨金プログラム」を開始するのであれば、政府による規制や、世論の圧力が必要だと考えているとのことです。

・関連記事

人工知能に偏見を抱かせないようにするための方法とは? - GIGAZINE

AIの先祖である「書類選考用アルゴリズム」もまた人種・女性差別的だったという事実 - GIGAZINE

AIは人間の言葉から女性差別や人種差別を学び取る - GIGAZINE

Googleの自然言語処理モデル「BERT」はインターネット上から偏見を吸収してしまうという指摘 - GIGAZINE

AIを用いてネットニュースの信頼性や政治的な偏りを判断するという研究報告 - GIGAZINE

「モザイク画像の解像度を64倍にする研究」が人種差別の議論に発展、非難を集めた研究者はアカウントを停止 - GIGAZINE

・関連コンテンツ