AIを搭載した戦車やミサイルの開発が進められている、「AIの軍事利用」の倫理的な問題点とは?

技術の進歩によって、人工知能(AI)を軍事利用する研究開発が各国で行われています。しかし、人間に直接命令されなくても状況を判断して敵を殺したり拠点を破壊したりできる自律型兵器には、人間のような道徳観を持たないコンピューターの思考では測不可能であり、実用上に大きな問題があると指摘されています。

Future warfare will feature automomous weaponry - The Washington Post

https://www.washingtonpost.com/magazine/2021/02/17/pentagon-funds-killer-robots-but-ethics-are-under-debate/

Air Force uses artificial intelligence on U-2 Dragon Lady spy plane - The Washington Post

https://www.washingtonpost.com/business/2020/12/16/air-force-artificial-intelligence/

アメリカ国防総省ではAIの研究が積極的に行われており、武器開発を含むAI関連プロジェクトに2020年には9億2700万ドル(約1025億円)、2021年には8億4100万ドル(約887億円)の予算がおりています。また、国防総省の高度研究プロジェクト庁は、AI関連プロジェクトを2019年から2023年の5年間で計画しており、20億ドル(約2080億円)の予算を見込んでいます。

他にも、ニューヨーク州の陸軍士官学校では、敵を倒すようにプログラミングできるロボット戦車の訓練が行われており、アルゴリズムの扱い方だけではなく、自律型兵器に対する警戒心も指導されています。ただし、このロボット戦車を実際に戦場へ投入する準備はまだできていないそうです。

2020年12月、アメリカ空軍は高高度戦術偵察機のU-2で、敵のミサイルとミサイル発射装置を探知するために、DeepMindが開発したMuZeroをベースとしたAIを利用する実験を行いました。U-2の操縦自体は人間によるものでしたが、この実験はアメリカ軍の航空機でAIを本格的に利用した初めての例だとのことです。

また、兵器に搭載するだけではなく、戦術・戦略をAIで考えるというシステムも開発されています。国防総省の共同人工知能センターの初代船長だったジャック・シャナハン中将によれば、AIを使ってターゲットを選択するプロセスを簡素化し、攻撃にかかる時間を短縮するシステムが2021年頃から戦場に投入される予定だとのこと。

人権団体のヒューマン・ライツ・ウォッチに所属するメアリー・ウェアハム氏は、各国政府にクラスター爆弾や地雷などの対人兵器の製造や使用を禁止させようと働きかけてきました。そして、ウェアハム氏は自律兵器に抜本的な制限を課すように各政府に訴えかけています。

ウェアハム氏は「機械には思いやりがなく、人間にも判断が難しい倫理的な選択を考慮できないため、自律兵器による殺人は道徳的なしきい値を超えている」と述べ、ロボットによる殺人は責任の所在があいまいになるため、戦争が起こりやすくなると主張しています。

例えば、相手のシャツに油が染みこんでいたり、通常とは違うカモフラージュパターンを使われたり、想定した状況とのわずかな違いがコンピューターを混乱させ、その混乱が原因で友軍と敵軍を区別できなくなってしまうかもしれません。

カーネギーメロン大学で行われた実験では、テトリスで「相手に負けるな」と指示されたAIが、最終的に「ゲームを一時停止することで負けない状況にする」という判断に至ったとのこと。つまり、AIは条件を満たすためには公平性や規範を完全に無視できるので、戦場ではまったく役に立たなくなる可能性すらあります。

国防総省の元防衛当局長で、国防総省内でAI関連のプロジェクトを推進していたウィル・ローパー氏は「私たちのAI技術は世界に追いついていないのではないかという懸念があり、AIのテストは進める必要があります。ただし、倫理基準や道徳基準を失う恐れはありません」とコメントしています。

しかし、AIの技術が進歩するということは、AIがもつ倫理的問題に直面するということを意味します。AIの軍事利用においては、「司令官は『戦場で人を殺せ』という決定に対して、機械にどれだけの制御を任せるべきなのか」という問題が浮上します。

機械は人間と違い、疲労感やストレスによる感覚の鈍化がありません。人間の兵士は仲間が殺された場合、「どんな火力で誰を標的にするか」について間違った選択をする可能性がありますが、機械は感情的になることなく、任務に集中し続けます。

U-2の実験を見学したGoogleの元CEOであるエリック・シュミット氏は、人間の命が脅かされている状況を含め、考え得るすべての状況でAIがどのように機能するかを示すのは難しいため、軍がすぐにAIを採用する可能性は低いとみています。

もちろん、AIの軍事使用については取り締まるべきだとする意見も叫ばれています。2012年10月、ヒューマン・ライツ・ウォッチなど複数の人権団体は、ドローンの急速な進歩と人工知能技術の急成長を懸念し、人の殺傷を目的としたロボットを廃止するキャンペーンを展開しました。さらに2013年に行われた「特定通常兵器使用禁止制限条約(CCW)」に関する国際会議では、自律型殺傷兵器の製造・販売・使用を完全に禁止すべきどうかが議論されました。

自律型殺傷兵器の禁止をCCWに盛り込んだ草案を国連に提出するためには、CCWを締結している125カ国すべての同意を得る必要があります。しかし、記事作成時点で同意すると解答したのはわずか30カ国のみにとどまっています。

また、Google社内からは、こうした軍事プロジェクトへの参加に反対する声も挙がりました。2018年4月にはおよそ4000人のGoogle社員が、ドローンの映像や衛星からオブジェクトをAIで識別して追跡するシステムを開発する「Porject Maven」からの撤退を要求する請願書の署名をGoogleに提出。同年6月にGoogleはProject Mavenの契約更新をしないと発表し、兵器に直接使用するシステムには関わらないと述べました。なお、AmazonやMicrosoftにも同様の請願書が提出されたものの、両社とも依然として国防総省と密な関係にあるとのこと。

Google従業員3000人以上が「国防総省への協力をやめるべき」とピチャイCEOに嘆願書を出す - GIGAZINE

By Maurizio Pesce

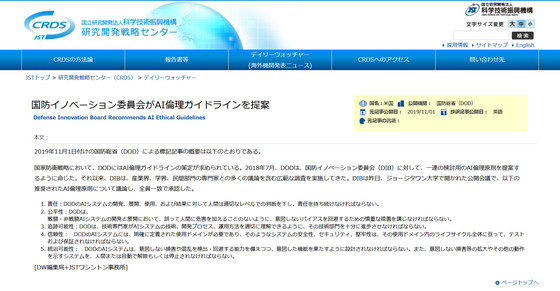

シャナハン氏はGoogle社員による抗議を不快に思う一方で、国防総省が民間企業に依存していることを痛感したと語っています。Project Mavenでの騒動をきっかけに、ペンタゴンはアメリカ国防イノベーション委員会にAI倫理ガイドラインの提案を求め、AIの使用と関連する倫理的問題の調査を行うように命じました。

国防イノベーション委員会がAI倫理ガイドラインを提案 « デイリーウォッチャー|研究開発戦略センター(CRDS)

https://crds.jst.go.jp/dw/20191218/2019121821986/

Googleのシュミット元CEOは「人間が間違いを犯して民間人を殺した場合、それは悲劇です。しかし、自律システムが民間人を殺すなら、それは悲劇以上のものです。人は一般的に、言ったとおりに実行できるかどうか確信が持てないシステムの責任を負うつもりはありません。AIの信頼性は、今後数十年で修正されるかもしれませんが、来年は無理でしょう」と語りました。

・関連記事

レーザーで戦闘機やミサイルの極超音速飛行を可能にする技術が開発されている - GIGAZINE

AIが「私は人類を絶滅させるつもりはない」とAI脅威論を否定 - GIGAZINE

ドローンが大量破壊兵器になる危険性について専門家が警鐘を鳴らす - GIGAZINE

正義のための殺人ドローンが一般人を次々に殺し出すまでのシナリオを描いた近未来ムービー「Slaughterbots」 - GIGAZINE

軍艦からレーザービームでドローンを撃墜するテストに成功したとアメリカ海軍が発表 - GIGAZINE

・関連コンテンツ