ディープラーニングで脳波を読み取る試み

by Thư Anh

翻訳プログラムやムービー編集技術、通話時のノイズ抑制などさまざまな技術に応用される「ディープラーニング」を用い、脳波や神経信号から実際の動作を正確に予測しようとしている研究者は大勢います。また、そういった試みは、現在ではかなり手軽に行うことが可能になっていることをFloydHubが明かしています。

Reading Minds with Deep Learning - FloydHub Blog

https://blog.floydhub.com/reading-minds-with-deep-learning/

人間が生きることは、さまざまな情報を適した形に翻訳することの連続です。音を聞くことは空気中の振動を音声に変換することで可能になり、目で見ることは電磁波を映像に変換することで可能になります。そんな人間にかかわるさまざまな信号の中でも、近年特に注目を集めているのが脳波を受信・解析して活用しようという「脳コンピューターインターフェース(BCI)」です。

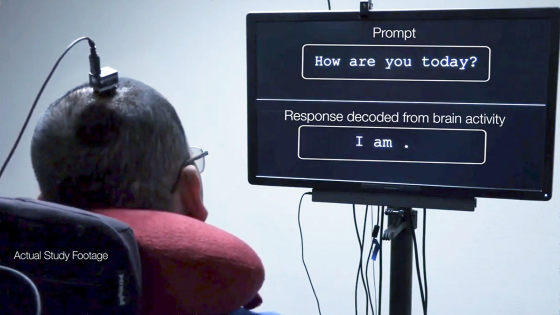

このBCIとディープラーニングを用いることで、脳波の変化などから人間が「何をしようとしているか?」や「何を考えているか?」を予測しようという試みが複数存在します。

◆CTRL-labs

CTRL-labsという企業は、神経センサーを手首に取り付け、どの指を動かすとどういった神経信号が発せられるかを記録し、神経信号から実際の手の動きを正確に予測できるインターフェースを作成しました。CTRL-labsによると、手首に取り付けたセンサーは神経系から発せられる「簡単に感知できる信号」を感知しているとのことで、「脊髄と腕から発せられた神経信号が脳にたどり着く前に読み取っている」とのこと。

CTRL-labs human neural interface - YouTube

CTRL-labsのアプローチは、これまで「脳に電極やセンサーを取り付けなければいけない」と考えられてきたBCIにとって、斬新なブレイクスルーになる可能性があります。

また、CTRL-labsは「神経信号だけでコンピューターと通信することができるようになれば、我々の神経系は現在使用しているよりも多くの数字を扱う方法を身に着けられるのではないだろうか?」と記しています。

◆MindMaze

BCIが多く適用されているのは、医療分野です。コンピューターとつながった義足などを思考で制御することは、体の一部が麻痺して動かなくなってしまった人々にとって大きな希望となり得ます。MindMazeは、体の一部が麻痺してしまった人が筋肉を正しく制御する方法を再び学習できるようにと、トレーニング用のVRアプリケーションを開発しています。

アプリケーション上ではユーザーの思考をVR空間上のアバターの動作に変換するとのことで、VR空間のアバターを自在に操りながら実際の体の動かし方を思い出していく、というアプローチが研究されています。

Mindmaze The Neurotechnology Company

◆Kernel

eBayが8億ドル(約900億円)で買収したBrain Treeの創業者でもあるブライアン・ジョンソン氏が立ち上げたKernelという企業も、BCI分野に参入しています。Kernelの短期的な目標は脳の記憶をコンピューターチップに変換することで、既に「約80%成功している」と主張しています。ただし、記事作成時点ではその詳細については明かされていません。

Kernel

◆Neuralink

テスラやSpaceXの創業者でもあるイーロン・マスクが立ち上げたコンピューターと脳をつなぐための神経系UI開発企業がNeuralinkです。同社はBCIにおける医薬品の改善やデバイスの接続方法などに取り組んでいますが、真の目的は人類とAIの融合にあるとのこと。マスクCEOは人類が長期にわたって生存するための唯一の方法は、「AIで進化することである」と断言しています。

こういった企業の話を聞いているとBCI分野は一般人とは無縁の話のように感じられますが、実際は畳み込みニューラルネットワークを使えば脳波から「どういった動作が行われていたか?」を読み取ることも可能です。そこで、ディープラーニング関係の情報をまとめるブログFloydHubが、実際に脳波を読み取る方法をザックリ解説しています。

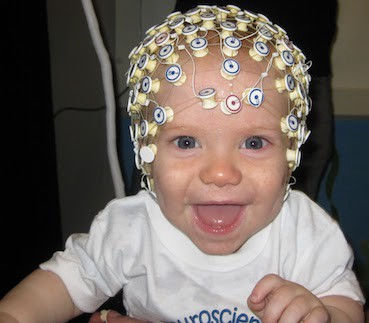

脳波を読み取るには脳波に関するデータが必要ということで、12人分の手作業時の脳波測定値を記録したデータセットが使用されています。

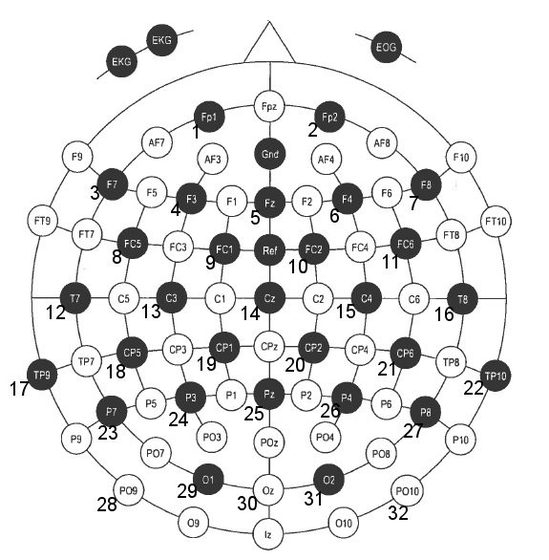

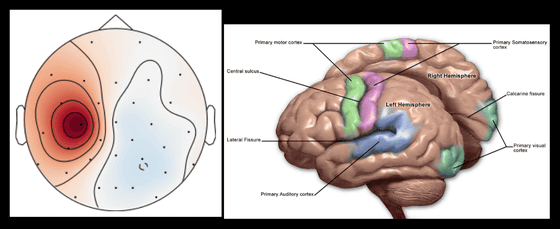

このデータセットでは脳波が以下の脳波図における32カ所から読み取られており、被験者は「光が点灯するとオブジェクトを持ち上げる動作を開始する」ように指示されており、その後「オブジェクトに触れる」「指をオブジェクト上に置く」「オブジェクトを持ち上げる」「オブジェクトを置く」「オブジェクトを離す」という5つの動作を行います。

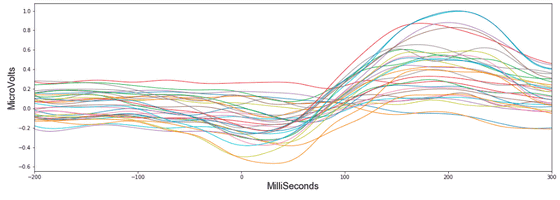

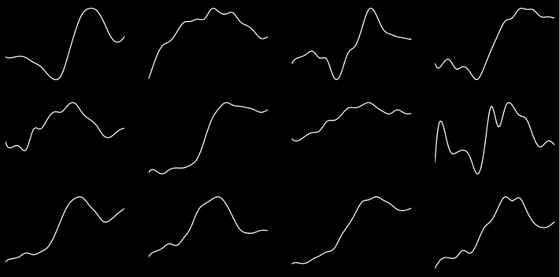

この中の、被験者が「光が点灯するとオブジェクトを持ち上げる動作を開始する」瞬間の脳波の変化を示したのが以下のグラフ。32本の線はそれぞれ脳波図における32カ所の測定位置で測定された値を示しており、手を動かし始める200ミリ秒前から動かし始めてからの300ミリ秒後までの値の変化がわかります。

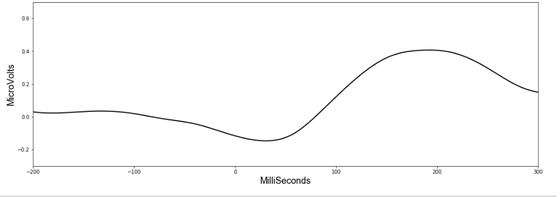

この32個のデータを平均すると以下のようになります。

しかし、他の5つの動作では脳波の変化パターンがあまり明確ではなく、脳波形だけを見て「実際にどのような動作が実行されたか」を予測することは困難だったそうです。全体的に上下に山なりのグラフにはなるものの、カーブの形状はそれぞれ異なっており、「この形だからこの動作」と判別するのが難しかったというわけ。

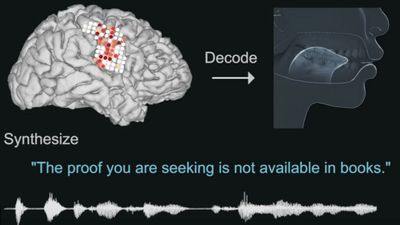

これとは別に、PythonライブラリのMNEを使えば、オブジェクトに触れたり持ち上げたりする瞬間に、「脳波の変化が脳のどの部位で起きているのか?」を視覚化することが可能です。例えば、オブジェクトに触れて持ち上げる際に最も活発だったのは脳の左(下図左の赤色部分)で、ここには運動野(下図右の緑色部分)と呼ばれる部位が存在します。

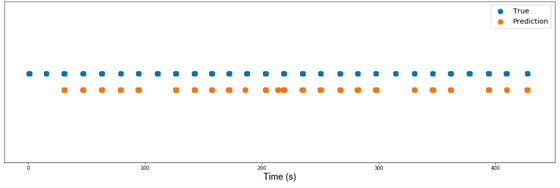

これらのデータをディープラーニング向けライブラリのPyTorchを用いて畳み込みニューラルネットワークに学習させたところ、AUCが94%となる精度のモデルを作ることに成功したとのこと。これをわかりやすく図で示したのが以下の画像。データセットでは被験者が28回オブジェクトを持ち上げるのですが、実際に被験者が動作を実行したときを青点で示し、モデルが動作が実行されたと予測したタイミングをオレンジ点で示しています。これによると、モデルは28回の動作のうち23回を正しく予測することに成功しています。

このように、ディープラーニングを使えば比較的簡単に脳波がどのような動作につながっているかを検証することが可能。実際、FloydHubが作成したモデルは以下のGitHubページ上でも公開されているので、データとモデルで遊ぶたい場合はクリックしてみてください。

GitHub - SamLynnEvans/EEG-grasp-and-lift: CNN to predict physical movements from brainwave readings

なお、神経科学に関心を持つ人がディープラーニングを用いて脳波から人間の実際の動作を特定しようとしても、用いられるニューラルネットワークが一体どのように動作しているのかがわからないという問題がありますが、FloydHubは「ディープラーニングがどのようなに動作しているのかを常に知っておく必要はない」としており、これは「物理法則を知る前にホイールを使ったり、電子について知る前に電気を使うことと同じだ」と記しています。

・関連記事

「ディープラーニングとは何か?」を初心者でも分かりやすく実例を含めて解説するムービー「Introduction to Deep Learning: What Is Deep Learning?」 - GIGAZINE

初心者向け「機械学習とディープラーニングの違い」をシンプルに解説 - GIGAZINE

AIを現実のものとする「ディープラーニング」の歴史はどこから始まったのか? - GIGAZINE

「考えるだけ」でロボットアームを自在に操る女性がステルス戦闘機F-35を飛ばすことにも成功 - GIGAZINE

電極つき帽子をかぶって思い通りにロボットアームを3次元的に動かすことに成功 - GIGAZINE

・関連コンテンツ