人工知能(AI)がスタンフォード大学の読書テストで人間を凌駕するスコアをマーク

by Markus Spiske

2018年1月、Alibabaは独自開発したディープニューラルネットワークモデルの性能を試すため、人工知能(AI)に10万個以上の質問を与え、正確な回答を導き出せるかどうかのテストを行いました。この「AIに与えられた質問」というのは、スタンフォード大学が作ったAIの読み取りテスト向けデータセット「SQuAD」で、このテストでAlibabaの開発したAIは人間よりも優秀なスコアをたたき出しました。

Alibaba's AI Outguns Humans in Reading Test - Bloomberg

https://www.bloomberg.com/news/articles/2018-01-15/alibaba-s-ai-outgunned-humans-in-key-stanford-reading-test

Alibaba neural network defeats human in global reading test | ZDNet

http://www.zdnet.com/article/alibaba-neural-network-defeats-human-in-global-reading-test/

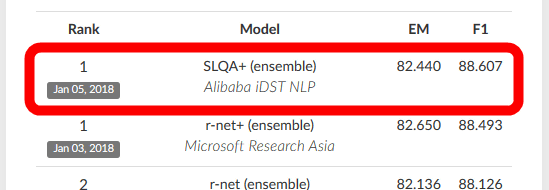

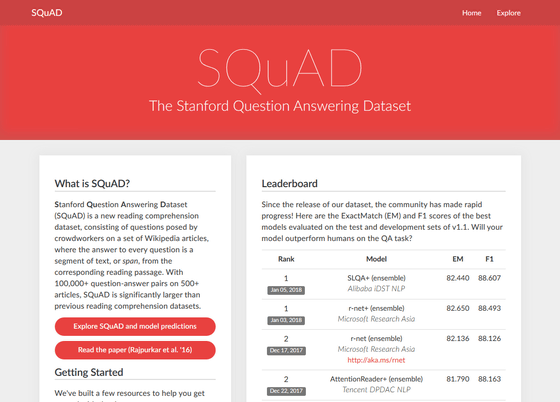

500を超えるWikipedia内の記事をベースに作られているSQuADの質問は、機械学習モデルが大量の情報を処理し、質問に正確な回答を提供できるかどうかを明らかにするために作られたものです。このSQuADを用いてAIの読み取り性能をテストすることで、AIがどれくらいの読み取り性能を持っているのかをスコアで評価することができます。このSQuADのテストには、GoogleやIBM、Microsoft、Samsung、テルアビブ大学、カンウォン国立大学など、さまざまな研究機関とIT企業が参加しました。その中で、Alibabaが開発したAIの「SLQA+」が、「82.44」というスコアを記録しています。

Alibabaによると、SLQA+が人間のスコア(82.304)を上回ったのは今回が初めてのことだそうです。なお、AlibabaがSLQA+のスコアを発表する2日前に、MicrosoftのAI「r-net+」も人間以上のスコアとなる「82.650」を記録しています。

なお、他の参加者のスコアは以下のページから確認できます。

The Stanford Question Answering Dataset

Alibabaが使用したニューラルネットワークモデルは、「段落から文章、単語まで」を読み取って回答を特定する「Hierarchical Attention Networks」という技術をベースにしているとのこと。

実際、この技術は取引総額が1682億元(約2兆8700億円)にまで到達した「独身の日」の問い合わせ対応にも利用されたそうです。

「独身の日」に中国のアリババが仕掛けたオンラインショッピングイベントの取引総額が3兆円弱に到達 - GIGAZINE

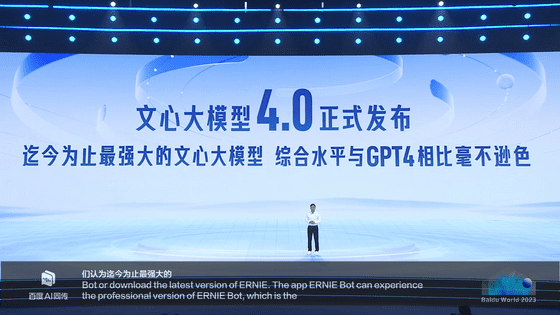

Alibabaは同じ中国のTencentやBaiduのように、AI開発競争に参入しています。中国は2030年までにAI産業において業界を牽引する立場に上り詰めることを望んでおり、そのためにAI関連企業に多くの支援を行っています。そんなAIを活用する分野の中でも、SLQA+のような「人間の言語を理解しようとするもの」は、自然言語処理という分野に分類されます。

Alibabaで自然言語処理に関する研究を行っているLuo Si氏は、「この技術(SLQA+)は顧客サービス、博物館のチュートリアル、患者からの医療問い合わせに対するオンライン応答など、数多くの用途で徐々に採用されはじめており、前例のない方法で人間による入力の必要性を減らしていくことができます」と語っています。

・関連記事

コンピューターが人間を超える「AI」「ディープラーニング」「機械学習」とは何かについて解説する「Machine Learning 101」 - GIGAZINE

「10年後には検索ボックスが消える?」2017年と2027年のIT分野の展望についてMicrosoftの研究者が語る - GIGAZINE

より高い品質の翻訳を実現するGoogleの「Transformer」がRNNやCNNをしのぐレベルに - GIGAZINE

IBMのスパコン「Watson(ワトソン)」が提案する食材ロスの少ないレシピとは? - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by logu_ii

You can read the machine translated English article Artificial intelligence (AI) marks a sco….