ディープラーニングで映像にあわせて効果音を乗せるアルゴリズムが登場、映像に音を乗せるとこうなる

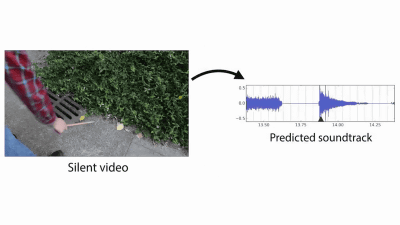

人間であれば、目にした映像をもとに草の「ガサガサ」という音や、木の机を「コン」とたたいた音を想像することはそれほど難しいものではありませんが、進化が著しいディープラーニングの技術によって、コンピューターアルゴリズムにもそのような感覚的な予測を行うことが可能になってきています。マサチューセッツ工科大学(MIT)のComputer Science and Artificial Intelligence Lab (CSAIL)では、あらかじめ映像と音の関係を学習させておいたコンピューターに映像を見せて実際に聞こえそうな音を予測させる研究が進められており、高い精度で映像に効果音を乗せることができるようになっているようです。

Visually-Indicated Sounds - YouTube

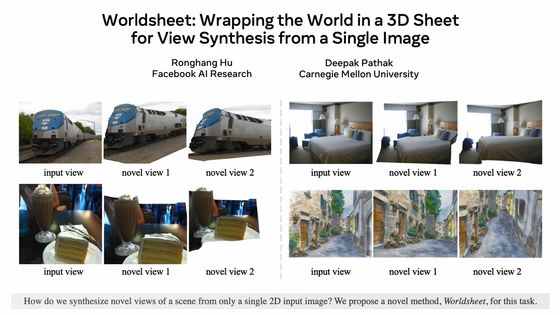

木の棒で木の植え込みを「ガサッ」とたたく音や……

スチール製のラックを「ゴン」とたたく音

水たまりを「パシャ」と波立てたり……

ガラスのボウルは「チン」

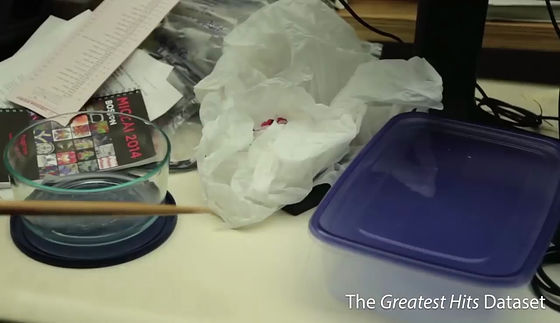

分厚い参考書は「バコッ」

マグカップなら「チン」というふうに、目から入る視覚の情報に加え、耳に入ってくる聴覚の情報は人が今いる状況を認識するうえにおいて非常に大きな役割を果たします。

CSAILは、このように映像から聞こえてきそうな音を学習して予測するアルゴリズムを開発しています。このアルゴリズムは、素材として与えられた1000本のムービーに含まれる4万6000パターンの音をもとに映像と音の関係について学習を行った後に、課題として与えられた無音の映像から音を予測し、最も近いであろう音を付与することを可能としています。音の分析には周波数と音量ではなく、主観的な要素を含むピッチとラウドネスの尺度が用いられているとのこと。

アルゴリズムでは、人間の脳の構造を模した「ニューラルネットワーク」によって与えられた映像を回帰分析し、あらかじめ蓄えられたデータベースを照合して最も近いと思われるものを見つけ出します。

そして個別の場所に音をあてはめることで、まるで本物の音が出ているかのような映像が完成。

最初は無音だった映像に、実際にどのような音が合成されたのかが示されています。この例では、ドラム用スティックで植え込みをたたく映像に音を当てているのですが、右画面のように枯れ葉の地面をたたく音が合成されている場合や……

ほぼ同じような植え込みをたたいている音が選択されているケースもあり。

かと思えば、なぜかテーブルをたたく音が当てられているケースや……

木の切り株……

ビニール袋のようなものが選ばれているケースもあり。このように、精度の面では改善の余地は残されているようですが、実際に映像を見てみると、さほど違和感のない状態であることに驚かされます。また、対象物をたたく時と表面を撫でる時の違いも再現されている点に要注目。

木の手すりをたたいている映像に対して、冷水機をたたいた音が合成されたり……

木のテーブルの音が合成されたり。

なぜか、エレベーターホールの床あたりを合成する場面も。このあたりは、人間とは違って音そのものだけを判断して近い音を探してくるというアルゴリズムの特性がよく表れているといえるのかもしれません。

さらにこのアルゴリズムを使えば、映像の分析結果をもとに効果音を合成することも可能。これにより、音を合成するだけでなく、映像からどのような要素が抽出されたのかを理解することも可能になるとのこと。

イスの背もたれをたたく音や……

落ち葉をたたく音などが合成されている模様。原音にちかそうな音もあれば、「あれ?」と思ってしまう音もあるのは今後に期待。

水面をパシャパシャする音は苦手なようです。

また、映像をもとに音を作りだしているため、誤認識によって本来ないはずのタイミングで音が鳴ることも。この映像では、スティックを振り上げたときにもヒットした音が付けられてしまっています。

どの程度リアルな音が付けられているのか、研究チームでは原音の映像と、アルゴリズムが音を付けた映像の両方を被験者に見せ、どちらが正しい音か判断してもらう調査を実施。すると、なんと人間のほうがアルゴリズムよりも2倍も間違った判断をするという結果が出たとのこと。特に、落ち葉をガサゴソとするようなケースで間違いが多く見られたとのことで、逆にスティックでテーブルをたたくような「単純な」音に対しては、正答率が高かったそうです。

この技術で特筆すべき点は、ディープラーニングによるAI(人工知能)が、「映像」と「音」、つまり視覚と聴覚の2つの感覚にまたがる判断を下しているところと言えます。カーネギーメロン大学ロボット工学准教授のAbhinav Gupta氏は「現在のAI技術は、人間に備わっている5つの感覚の中からどれか1つの感覚を対象にするものがほとんどですが、聴覚と視覚の両方を扱うこの研究は、人間が感覚の学習を行う過程を模倣することにおける正しい方向を示すものと言えるでしょう」と、研究の成果を語っています。

この技術が発展すると、単に映像に音を付けるだけでなく、とらえられた映像と音から地面の状態を判断し、ロボットがどのように歩行するかを判断するためのAI開発にもつながると考えられています。

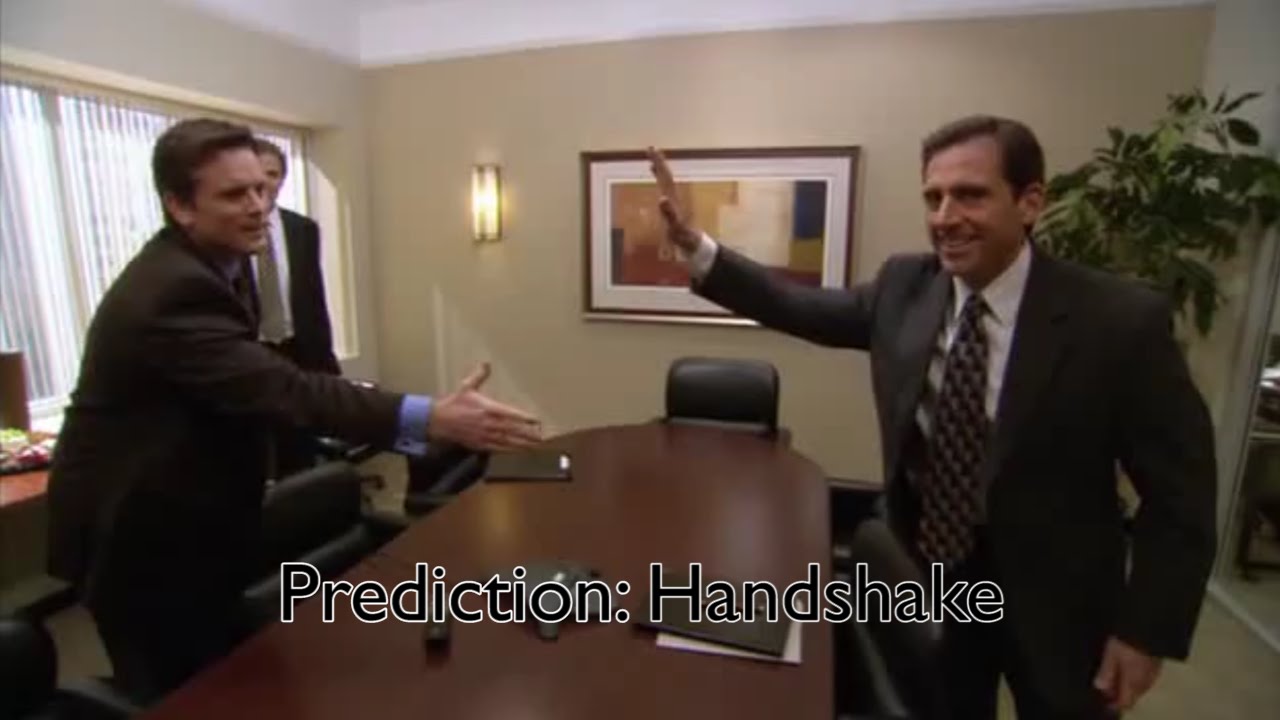

予測判断に関連すると、以下のように映像から人間の行動を予測して、「このあと握手をする」「この後ハグする」など、1秒後の行動を予測するアルゴリズム技術も開発されています。

Action-Prediction Algorithms - YouTube

・関連記事

ゴッホの絵をコンピュータに描かせるとどうなるか? - GIGAZINE

ロボティクスとアルゴリズムで肖像画を作り出す「Laarco Studio」作品集 - GIGAZINE

Googleで開発中の人工知能が綴ったポエムがキモいと話題に - GIGAZINE

ジャズを自動作曲する人工知能「deepjazz」、AIが作ったジャズはこんな感じ - GIGAZINE

ラフ画へ自動的にペン入れして線画にする恐るべきニューラルネットワーク技術を早稲田大学の研究室が開発 - GIGAZINE

コンピュータを進化させてきた偉大なるアルゴリズムまとめ - GIGAZINE

Googleの人工知能「DQN」が人間より上手にプレイできるゲームとできないゲームの境界線 - GIGAZINE

Googleの人工知能「AlphaGo」を作ったDeepMindがAIの暴走を止める「緊急停止ボタン」の仕組みを開発 - GIGAZINE

・関連コンテンツ

in 動画, ソフトウェア, サイエンス, Posted by darkhorse_log

You can read the machine translated English article Algorithms for placing sound effects acc….