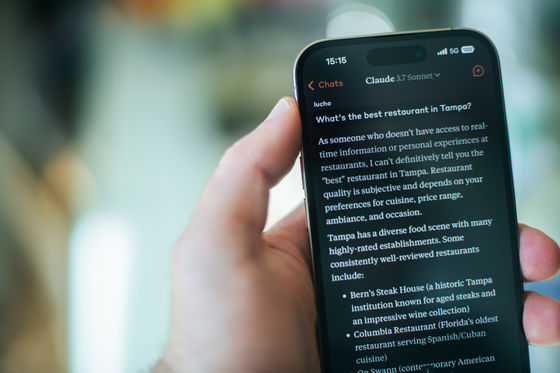

エージェントコーディングの性能はハードウェア設定によって数%ポイント変動するとAnthropicが報告、高性能モデル同士のベンチマークスコア差は高性能なハードウェアの恩恵の可能性

Claudeの開発元であるAnthropicが、「インフラストラクチャーの構成により、エージェントコーディングのベンチマークが数パーセントポイント変動する」と報告しています。この差は人気のAIモデルのベンチマークリーダーボード上の差に影響しているそうです。

Quantifying infrastructure noise in agentic coding evals \ Anthropic

https://www.anthropic.com/engineering/infrastructure-noise

SWE-benchやTerminal-Benchといったエージェントコーディングのベンチマークテストは、最先端のAIモデルのソフトウェアエンジニアリング能力を比較するために広く利用されています。

これらのベンチマークのリーダーボード上位の順位は、わずか数パーセントポイントの差で推移することがよくあります。ベンチマークスコアはAIモデルの相対的な能力を正確に測るための指標として扱われることが多く、導入するモデルを決定する際に重要な情報として活用されています。

しかし、インフラストラクチャーの構成だけで、リーダーボード上のわずかな差を超える差異が生じる可能性があるとAnthropicが報告しました。Anthropicの社内実験では、Terminal-Bench 2.0においてリソースが最も多い構成と最も少ない構成の差は6パーセントポイントだったそうです。

静的ベンチマークはAIモデルの出力を直接評価するため、実行環境は結果に影響を与えません。一方、エージェントによるコーディング評価は異なります。モデルには完全な環境が与えられ、そこでプログラムの作成、テストの実行、依存関係のインストール、そして複数ターンにわたる反復処理が行われます。ランタイムはもはや受動的なコンテナではなく、問題解決プロセスの不可欠な要素です。リソース予算と時間制限が異なる2つのエージェントが同じテストを受けることはありません。

評価開発者はこの点を考慮し始めており、例えば、Terminal-Bench 2.0は最新の2.0リリースでタスクごとに推奨CPUとRAMを指定するようになりました。しかし、リソースを指定することと、それらを一貫して強制することは同じではありません。さらに、強制方法によってベンチマークが実際に測定する内容が変化する可能性があることが判明したそうです。

Anthropicがこのことに気づいた経緯は、Terminal-Bench 2.0をGoogle Kubernetes Engineで実行したところ、設定を調整していると「スコアがベンチマークの公式リーダーボードと一致しないこと」および「インフラエラー率が驚くほど高いこと」に気づいたことがきっかけだったそうです。

後にスコアの不一致が強制適用によるものであることが判明。Google Kubernetes Engineではタスクごとのリソース仕様を下限と上限の両方として扱っていたそうです。つまり、各コンテナには指定されたリソースが保証されていたものの、それを超えた瞬間に強制終了されてしまうという問題があったわけ。また、コンテナランタイムは2つの異なるパラメータ、つまり事前に確保されるリソースの保証割り当てと、コンテナが強制終了されるハードリミットによってリソースを強制終了してしまいます。

これを考慮し、Terminal-Benchのリーダーボードでは、より柔軟な実装の異なるサンドボックスプロバイダーを使用しています。このプロバイダーは、インフラストラクチャの安定性を優先するために、コンテナを終了させることなく一時的な過剰割り当てを許可しているそうです。

この時、「リソース構成は評価スコアにどの程度影響するのか?」という疑問が生じ、リソース構成の違いがベンチマーク結果にどの程度影響するかを定量化するために、Terminal-Bench 2.0を6つのリソース構成で実行するという実験を行ないました。すると、すると、リソースの上限値が増加するにつれてタスクの成功率が向上することが判明しました。

リソース割り当てをTerminal-Bench仕様の3倍以上に設定すると、追加のリソースがエージェントが解決できなかったタスクの解決を積極的に支援するようになることも明らかになりました。つまり、ベンチマークテストのスコアにまで影響を及ぼすようになるということです。

無駄のない効率的なコードを非常に速く書くエージェントは、厳しい制約の下でも優れたパフォーマンスを発揮します。一方、重いツールを用いて総当たり的に解を求めるエージェントは、寛大な制約の下で優れたパフォーマンスを発揮することが可能です。「どちらもテスト対象としては妥当ですが、リソース構成を指定せずに単一のスコアにまとめてしまうと、現実世界への一般化の可能性を解釈することが難しくなります」とAnthropicは指摘しました。

AIモデルによってデフォルトのアプローチが異なり、リソース構成によって、どのアプローチが成功するかが決まります。効果の方向は一貫していましたが、大きさは変化するようで、「同じ傾向がClaude以外のAIモデルにも当てはまるようですが、厳密にはテストしていません」とAnthropicは説明しています。

なお、Anthropicによるとベンチマークスコアに影響を及ぼすのはリソース割り当てだけではないようで、特定の設定では時間制限もスコアに影響をもたらしたそうです。

そのため、Anthropicはエージェントコーディングベンチマークについて「理想的なシナリオは、各評価を全く同じハードウェア条件で実行することです。これにより、全体的な完全な再現性が保証されます」と言及。ただし、これが必ずしも現実的ではないことも理解しているとのこと。

Anthropicは「ベンチマークスコアは意思決定の材料としてますます利用されていますが、こうした注目の高まりは、必ずしもベンチマークスコアの実行方法や報告方法の厳密さを伴っていません。現状では、リーダーボードで2パーセントポイントリードしている場合、それは真の能力差を反映している可能性もあれば、より高性能なハードウェアでベンチマークを実行しただけ、あるいはより好都合な時間帯に実行しただけ、あるいはその両方を反映している可能性もあります」と指摘。

ベンチマーク管理者は推奨リソース仕様を公開することで大きな効果が得られ、施行方法を明確にすることで、Anthropicが指摘するようなギャップを埋めることができます。ベンチマーク結果を利用する人にとっての重要なポイントは、エージェント評価における小さなスコア差は、報告された数値の精度が示唆するよりも大きな不確実性を伴うということを理解することだとしました。

・関連記事

AnthropicがClaude Opus 4.6を発表、コーディングだけでなく財務処理や文書作成の性能も向上&最大100万トークンのコンテキストウィンドウに対応 - GIGAZINE

AppleがXcodeとコーディングエージェントのClaude AgentやOpenAI Codexとの統合を発表、さらにMCPにも対応 - GIGAZINE

軽量で高性能なコーディングエージェント「Qwen3-Coder-Next」が登場 - GIGAZINE

OpenAIがCodexのアプリ版を公開、複数エージェントを同時実行可能でOpenAIの開発者は「99.9%をCodex appでコーディングしている」とアピール - GIGAZINE

Cursorが数百のエージェントを協調させ「ゼロからブラウザを構築」させる実験を実施、1週間で1000ファイル・100万行以上のコードを記述 - GIGAZINE

・関連コンテンツ

in AI, Posted by logu_ii

You can read the machine translated English article Anthropic reports that agent coding perf….