Cloudflareがフェイク画像を検出できるデジタル署名システム「Content Credentials」をCloudflare Imagesに統合

Cloudflareが2025年2月3日に、画像のアップロードや加工、コンテンツの配信などを一貫して行うソリューション「Cloudflare Images」にコンテンツの帰属表示を適用するContent Credentialsを統合したことを発表しました。

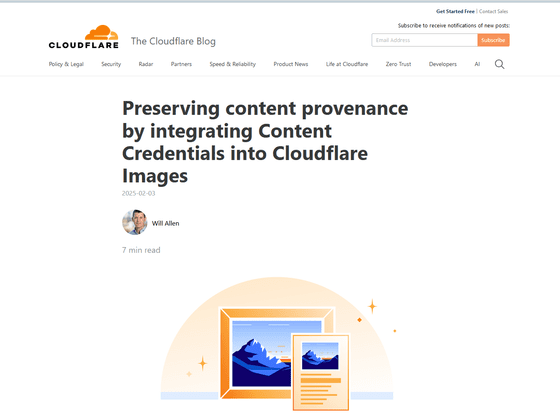

Preserving content provenance by integrating Content Credentials into Cloudflare Images

https://blog.cloudflare.com/preserve-content-credentials-with-cloudflare-images/

Content Credentialsとは、デジタルコンテンツの「成分表示ラベル」のようなもので、誰でも自身の作品に付与できる安全なメタデータであり、作成者の情報と、それがどのように作成され編集されたかについての背景情報を提供します。2019年にAdobeはContent Authenticity Initiativeを設立し、デジタルコンテンツの透明性を確保するための業界標準としてContent Credentialsの普及を推進しています。

記事作成時点でBBCやニューヨーク・タイムズ、ダウ・ジョーンズなど、世界中の多くのメディア組織がContent Authenticity Initiativeに加入しています。しかし、これまでは報道機関がコンテンツの来歴を証明する技術「C2PA」に準拠したカメラや編集フローを採用していても、CDNによって画像が変換されると、頻繁にこれらの認証情報が削除されていました。

しかし、Cloudflare ImagesがContent Credentialsを統合したことにより、リモートソースからの画像を変換したとしてもコンテンツ認証情報を保持できるようになりました。つまり、Cloudflare Imagesを使用して画像のサイズを変更したり、ファイル形式を変更したりしたとしても、コンテンツ認証情報は保持され、オープンソースの検証サービスなどを利用することで画像の出どころを正確に確認することが可能というわけです。

一般的に、C2PAに準拠したカメラを使用している場合、そのカメラのモデルや元の画像サイズ、絞り設定などのコンテンツ認証情報を写真に添付することが可能です。以下は写真に保存されるメタデータの例。

{

"jumbf": {

"c2pa.manifest": {

"claim_generator": "Nikon Z9 Firmware v1.2",

"assertions": [

{

"label": "c2pa.actions",

"data": {

"actions": [

{

"action": "c2pa.captured",

"when": "2025-01-10T12:00:00Z",

"softwareAgent": "Nikon Z9",

"parameters": {

"captureDevice": "NIKON Z9",

"serialNumber": "7DX12345",

"exposure": "1/250",

"aperture": "f/2.8",

"iso": 100,

"focalLength": "70mm"

}

}

]

}

}

],

"signature_info": {

"issuer": "Nikon",

"time": "2025-01-10T12:00:00Z",

"cert_fingerprint": "01234567890abcdef"

},

"claim_metadata": {

"claim_id": "nikon_z9_123"

}

}

}

}

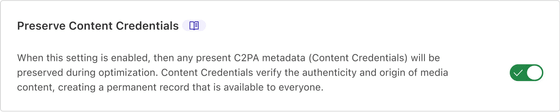

Cloudflareで「コンテンツ認証情報の保持」設定を有効にしている場合、上記のメタデータはCloudflare Imagesに保持されます。

その後、Cloudflare Imagesを使用して画像サイズを変更すると、メタデータに変更した旨が記載されるようになります。

{

"jumbf": {

// Original Nikon manifest

"c2pa.manifest.nikon": {

/*unchanged*/

},

// New Cloudflare manifest

"c2pa.manifest.cloudflare": {

"claim_generator": "Cloudflare Images",

"assertions": [

{

"label": "c2pa.actions",

"data": {

"actions": [

{

"action": "c2pa.resized",

"when": "2025-01-10T12:05:00Z",

"softwareAgent": "Cloudflare Images",

"parameters": {

"originalDimensions": {

"width": 8256,

"height": 5504

},

"newDimensions": {

"width": 800,

"height": 533

}

}

}

]

}

}

],

"signature_info": {

"issuer": "Cloudflare, Inc",

"time": "2025-01-10T12:05:00Z",

"cert_fingerprint": "fedcba9876543210"

},

"claim_metadata": {

"claim_id": "cf_resize_123",

"parent_claim_id": "nikon_z9_123"

}

}

}

}

同時に、コンテンツの編集を行ったことが秘密鍵を使用して署名されるため、信頼性が確保されます。また、これらのコンテンツ認証情報と署名のいずれかが検証に失敗した場合、メタデータが改ざんされたことを意味するするとのこと。

Cloudflareは「コンテンツ制作者とパブリッシャーは、画像がどのように作成されたか、誰が作成したか、その後の編集まで、Cloudflareネットワーク全体で出どころのチェーン全体をシームレスに保持できるようになりました」と述べています。

・関連記事

Adobeがデジタルコンテンツに帰属表示を適用したりAIトレーニング拒否を表明したりできる「Adobe Content Authenticity」ウェブアプリを発表 - GIGAZINE

本物の写真とAI生成の偽物を識別できる「C2PA」がなかなか普及しないのはなぜか? - GIGAZINE

OpenAIが「AI生成画像かどうかを見分けるツール」を開発中 - GIGAZINE

AdobeのPhotoshopやIllustratorでもテキストベースで画像やエフェクトを生成できるようになるAI「Firefly」では一体どんなことができるのか中の人に見せてもらってきた - GIGAZINE

世界で初めてAI使用履歴や作者の情報を画像に付与する「コンテンツクレデンシャル機能」を内蔵したカメラ「ライカ M11-P」 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1r_ut

You can read the machine translated English article Cloudflare integrates Content Credential….