高速推論が可能なレイテンシ重視AIモデル「Mistral Small 3」がリリースされる

フランスのAIスタートアップであるMistral AIが、レイテンシを重視したAIモデル「Mistral Small 3」をオープンソースライセンスでリリースしました。今回リリースされたMistral Small 3をベースに強化学習などを使用してさらに強力なモデルが作成できる可能性があるとのことです。

Mistral Small 3 | Mistral AI | Frontier AI in your hands

https://mistral.ai/news/mistral-small-3/

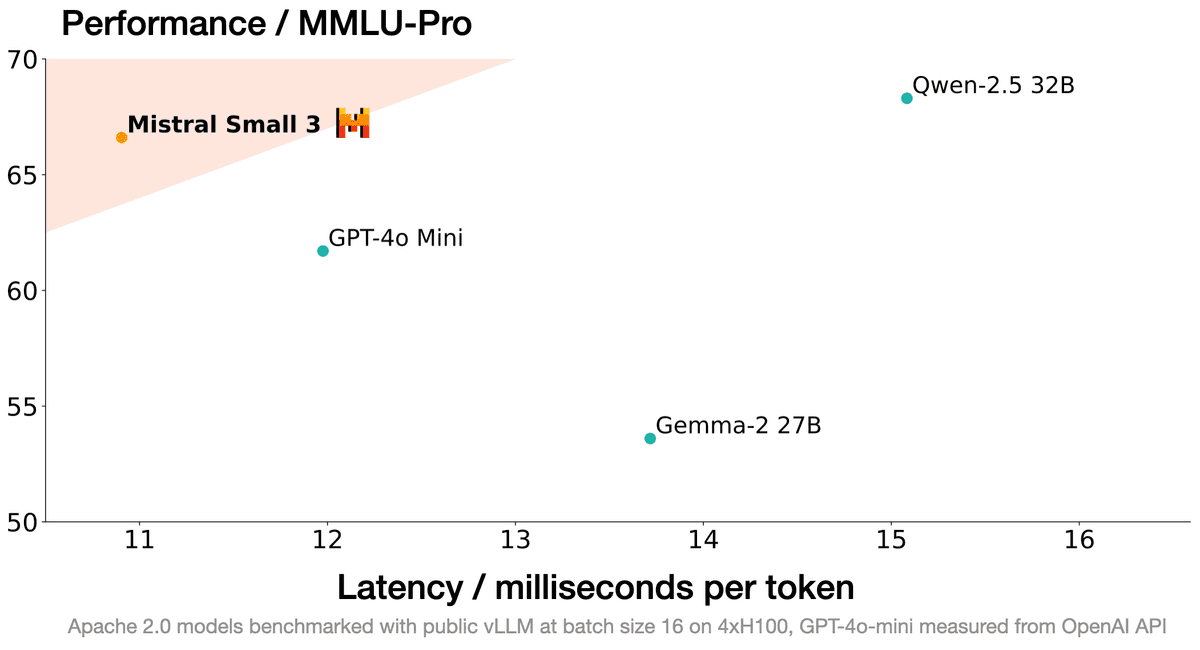

以下は縦軸をパフォーマンス、横軸をレイテンシとして「Mistral Small 3」「GPT-4o Mini」「Gemma-2 27B」「Qwen-2.5 32B」を並べた図。Mistral Small 3は図の左上にあり、素早く質の高い回答を生成できることが分かります。Mistral Small 3はレイヤーを少なくすることで、4台のNVIDIA H100 GPUを使用して毎秒150トークンを生成可能になっているとのこと。

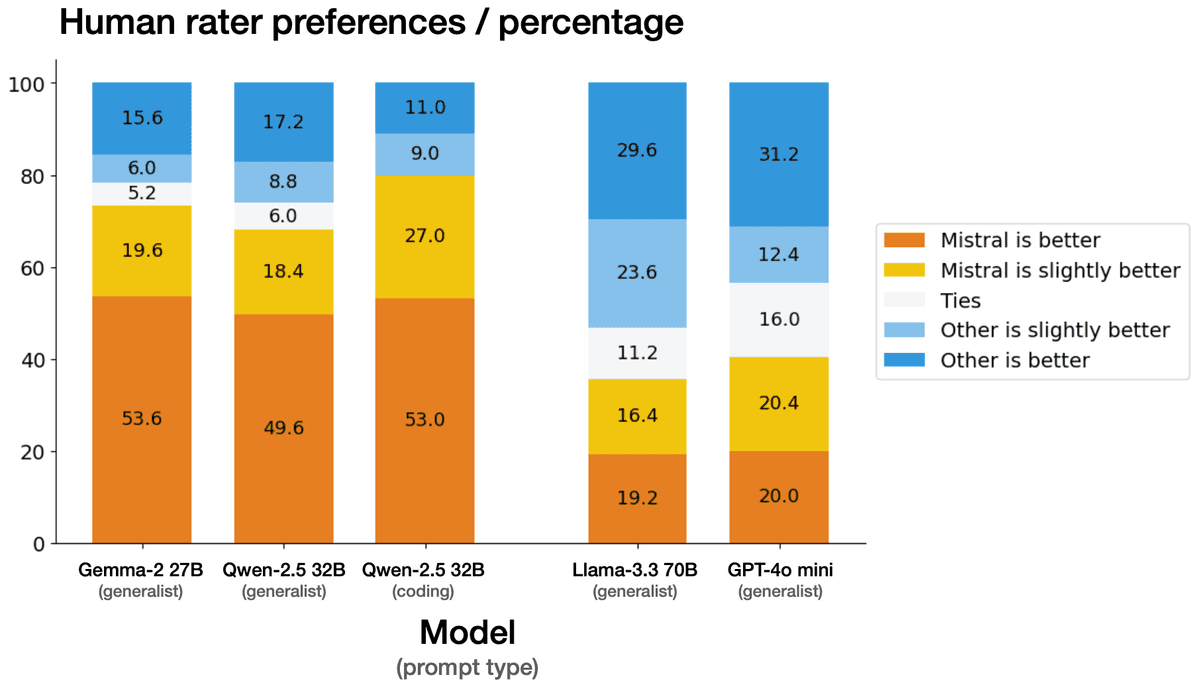

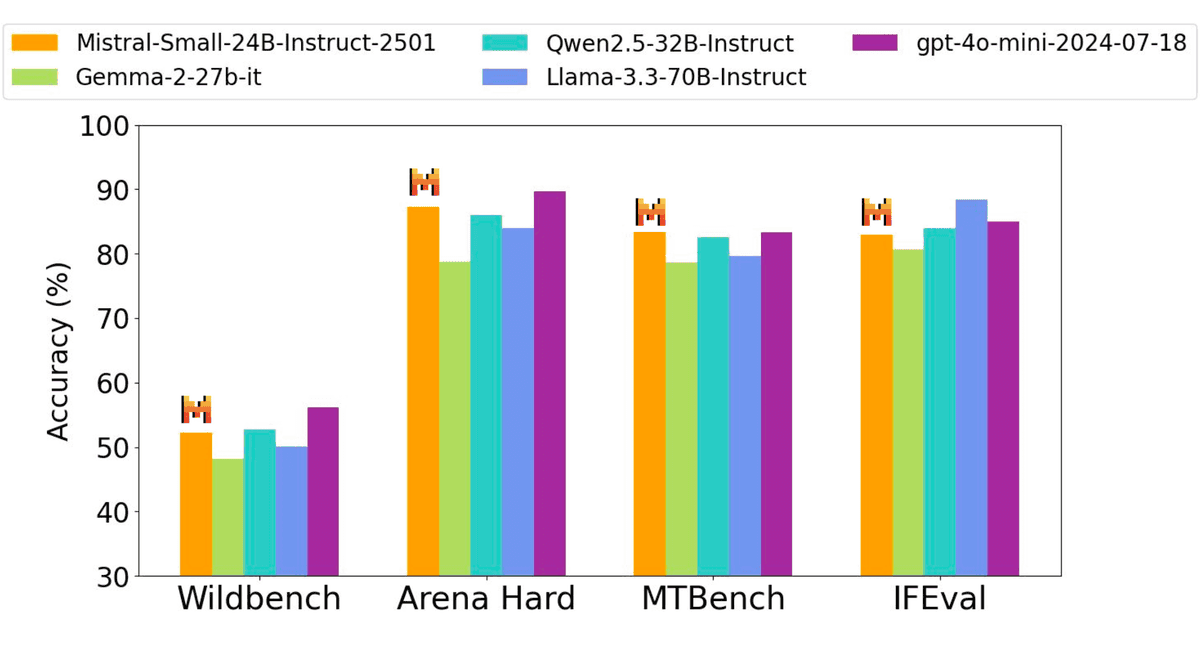

Mistral Small 3とその他のモデルについて、人間が「どちらの回答がより好ましいか?」を評価した結果は以下の通り。「Gemma-2 27B」「Qwen-2.5 32B」に比べて高く評価されたほか、Llama-3.3 70Bのような大きなモデルとも戦える性能を示し、GPT-4o miniとは同等と評価されました。

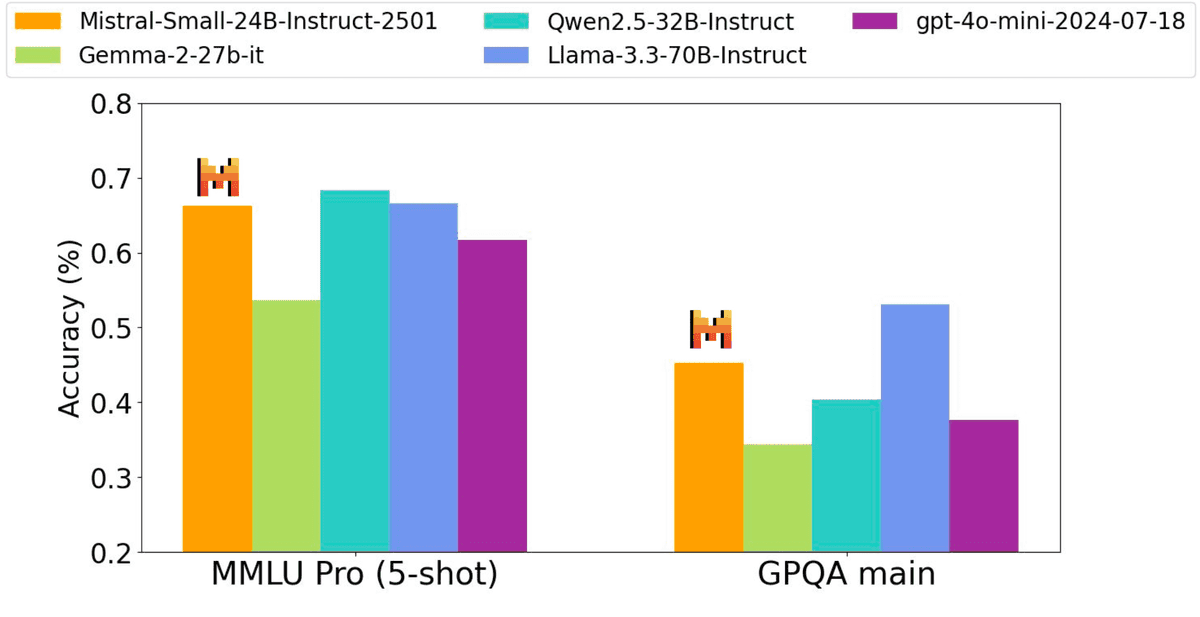

大規模マルチタスク言語理解(MMLU)ベンチマークと高度な推論能力を評価するGPQAベンチマークの結果は下図の通り。ベンチマーク結果からもLlama-3.3 70BやGPT-4o miniと同等の性能を持つことがうかがえます。

コーディング、数学、一般知識、命令などその他のベンチマークでも似た結果に。

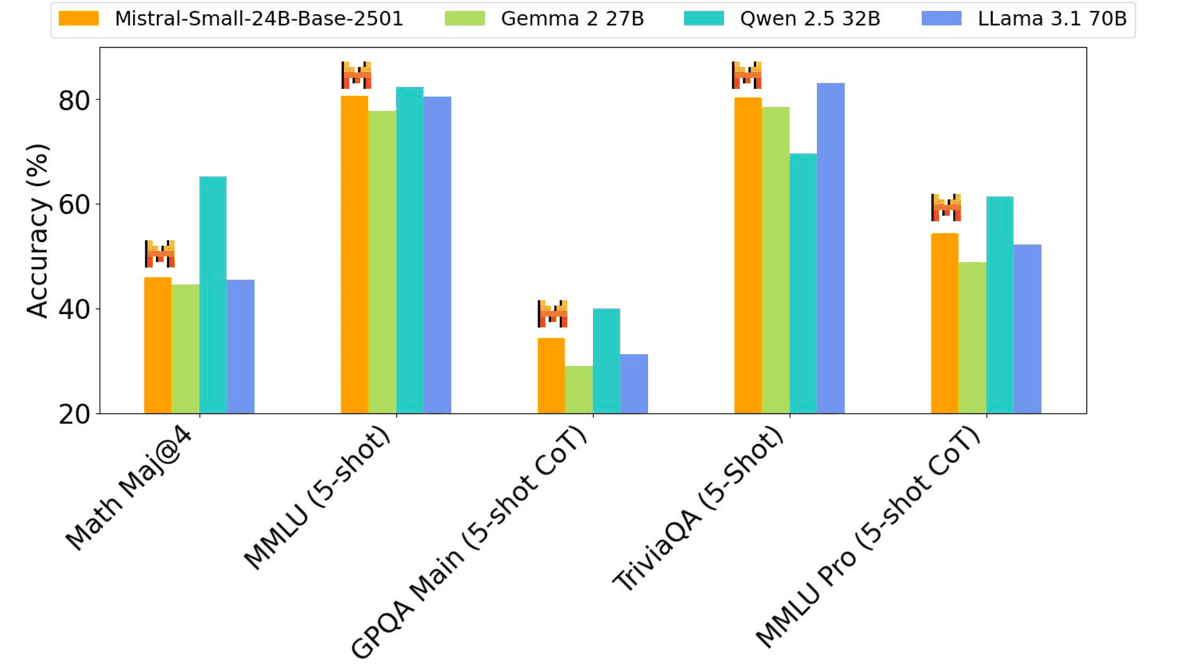

ファインチューニングを行う前の、事前調整済みモデルでの比較は以下の通り。Llama 3.1 70Bのような大きなモデルと同等の性能を発揮しています。

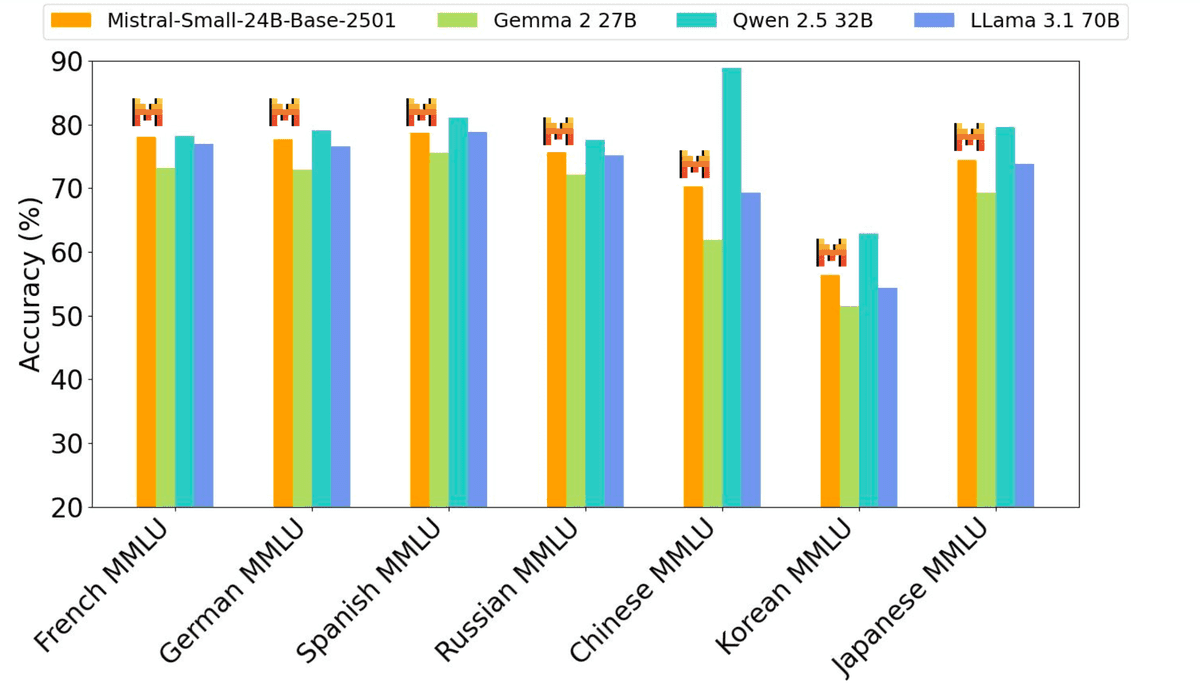

外国語に関する性能も引けを取りません。

Mistral Small 3を量子化することで単一のRTX 4090での動作が可能になるとのこと。その他、迅速な応答が必要なタスクで力を発揮するとされています。

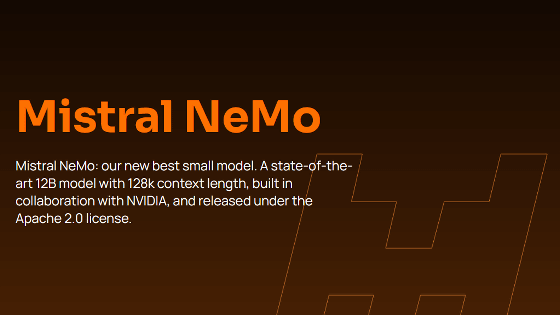

Mistral Small 3はHugging FaceやOllamaなどのプラットフォームからダウンロード可能です。Apache 2.0ライセンスで配布されているため、商用利用もOK。今後、さらに推論能力を強化した小型・大型のモデルが登場予定とのこと。

汎用(はんよう)AIシステムである大規模言語モデルにおいて、Mistralはヨーロッパで唯一存在感のある企業ですが、2024年のシェアは5%しかなく、アメリカ企業に押され気味です。ヨーロッパがAIに与える影響を維持するにはMistralがここから巻き返せるかが大切とFinancial Timesが報じています。

・関連記事

AIに「もっといいコードを書いて」と繰り返し要求するとコードの実行速度は向上するがバグが増えるという報告 - GIGAZINE

Amazonが生成AIで配達を高速化する仕組みとは? - GIGAZINE

CerebrasがNVIDIA H100の22倍高速な爆速AI推論サービスを発表、デモページも公開されたので使ってみた - GIGAZINE

既存の動画生成AIを8倍高速化できる「FastVideo」登場 - GIGAZINE

Googleが従来のモデルよりさらに小型で高速な「Gemini 1.5 Flash-8B」をリリース、価格は50%低くなり遅延も軽減 - GIGAZINE

・関連コンテンツ

in AI, ソフトウェア, ネットサービス, Posted by log1d_ts

You can read the machine translated English article Release of 'Mistral Small 3,' a latency-….