Micronが36GBの12段積層HBM3Eを発表、AI開発に役立つ超高速メモリの大容量版

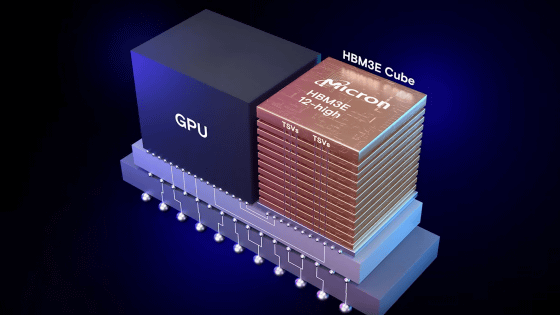

Micronが容量36GBの12段積層HBM3Eを出荷開始したことを発表しました。Micronが開発した36GB・12段積層HBM3Eは1.2TB/sを超えるメモリ帯域幅を備えており、AI開発に役立つことがアピールされています。

Micron continues memory industry leadership with HBM3E 12-high 36GB | Micron Technology Inc.

https://www.micron.com/about/blog/applications/ai/micron-continues-memory-industry-leadership-with-hbm3e-12-high-36gb

HBM3E | Micron Technology Inc.

https://www.micron.com/products/memory/hbm/hbm3e

AI開発では膨大なデータを扱う必要があるため、計算処理を行うプロセッサだけでなくデータの移動にかかわるメモリの容量や帯域幅も非常に重要な要素となっています。Micronは既に24GB・8段積層HBM3Eを量産しており、NVIDIAの高性能AI処理チップ「H200」にも採用されています。

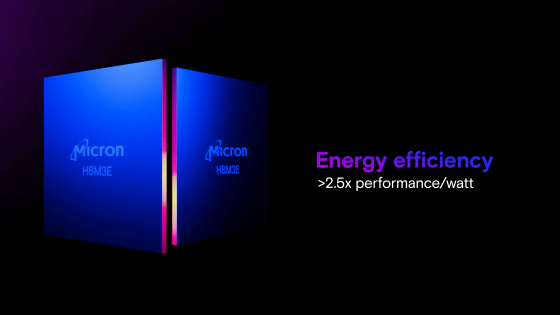

新たに開発された36GB・12段積層HBM3Eは1.2TB/sを超えるメモリ帯域幅を備えており、大規模なAIモデルでも単一のプロセッサで実行できるとのこと。さらに、消費電力は競合他社の24GB・8段積層HBM3Eと比べて大幅に低く抑えられています。

Micronの36GB・12段積層HBM3Eはすでに業界パートナー向けに出荷されており、AIエコシステムでの採用に向けてテストが進んでいます。

なお、36GB・12段積層HBM3EはSamsungも出荷開始しています。

転送速度1280GB/sで容量36GBの超高速メモリ「HBM3E 12H」をSamsungが発表、AIの学習の高速化と推論の並列実行数増加が可能 - GIGAZINE

・関連記事

Samsungの第4世代高帯域幅メモリの「HBM3」チップがNVIDIAのテストに合格、中国市場向けの「H20」に搭載予定 - GIGAZINE

SK HynixがTSMCとの提携を発表、2026年に量産予定の次世代HBM4チップと高度なチップパッケージング技術の開発へ - GIGAZINE

HuaweiがHBMチップ開発で中国のファウンドリ武漢新信半導体製造と提携、制裁を回避する体制確立へ - GIGAZINE

Micronが開発したGDDR7規格のVRAMはグラボの描画性能を30%以上改善する見込み - GIGAZINE

ついにPCIe 6対応データセンター向けSSDが登場、26GB毎秒を超える爆速読み取り速度を実現 - GIGAZINE

・関連コンテンツ

in ハードウェア, Posted by log1o_hf

You can read the machine translated English article Micron unveils 36GB 12-stacked HBM3E, a ….