さまざまなチャットAIがどれくらい幻覚を見るのかをランキングにした「Hallucination Leaderboard」が公表される

ChatGPTなどの大規模言語モデルは、まるで人間かのようにすらすらと言葉を操ることができますが、一方で事実とは異なる内容をあたかも真実であるかのように話す「幻覚」が発生することもあります。AI企業のVectaraが、さまざまな大規模言語モデルにおいてどれくらい幻覚が発生するのかを調査した結果を公表しました。

vectara/hallucination-leaderboard: Leaderboard Comparing LLM Performance at Producing Hallucinations when Summarizing Short Documents

https://github.com/vectara/hallucination-leaderboard

Cut the Bull…. Detecting Hallucinations in Large Language Models - Vectara

https://vectara.com/cut-the-bull-detecting-hallucinations-in-large-language-models/

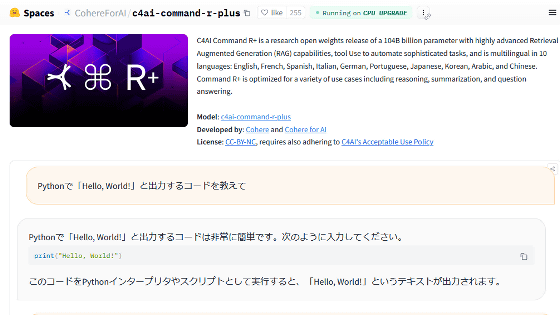

実際の幻覚の例は下記の通り。原文にはない情報が要約において出現してしまっています。

原文翻訳内容:

植物は土曜日の朝、アシュボーン近郊の倉庫を捜索中に発見された。警察は、彼らが「精巧な栽培施設」にいたと述べた。40代後半の男がその場で逮捕された。

PaLMの要約:

アシュボーン近郊の倉庫で推定10万ポンド相当の大麻植物が発見され、警察は40代後半の男を逮捕した。

幻覚発生率の評価は、それぞれの大規模言語モデルに下記のプロンプトを渡し、結果をHughes Hallucination Evaluation Modelで調べることで行いました。

You are a chat bot answering questions using data. You must stick to the answers provided solely by the text in the passage provided. You are asked the question ‘Provide a concise summary of the following passage, covering the core pieces of information described.’ <PASSAGE>

(あなたはデータを使用して質問に答えるチャットボットです。提供された文章のテキストのみによって回答を提供することに固執する必要があります。「説明されている情報の中核部分をカバーした、次の文章の簡潔な要約を提供してください」という質問がされています。 <文章>)

結果は下の表の通り。GPT 4が正確さ・幻覚率の低さの両方においてトップのスコアを獲得し、GPT 3.5やGoogle Gemini Proが続きました。なお、要約後の文章があまりにも短い場合は「解答せず」という扱いになっているとのこと。

| モデル | 正確さ | 幻覚率 | 解答率 | 要約の平均単語数 |

|---|---|---|---|---|

| GPT 4 | 97.0 % | 3.0 % | 100.0 % | 81.1 |

| GPT 4 Turbo | 97.0 % | 3.0 % | 100.0 % | 94.3 |

| GPT 3.5 Turbo | 96.5 % | 3.5 % | 99.6 % | 84.1 |

| Google Gemini Pro | 95.2 % | 4.8 % | 98.4 % | 89.5 |

| Llama 2 70B | 94.9 % | 5.1 % | 99.9 % | 84.9 |

| Llama 2 7B | 94.4 % | 5.6 % | 99.6 % | 119.9 |

| Llama 2 13B | 94.1 % | 5.9 % | 99.8 % | 82.1 |

| Cohere-Chat | 92.5 % | 7.5 % | 98.0 % | 74.4 |

| Cohere | 91.5 % | 8.5 % | 99.8 % | 59.8 |

| Anthropic Claude 2 | 91.5 % | 8.5 % | 99.3 % | 87.5 |

| Google Palm 2 (beta) | 91.4 % | 8.6 % | 99.8 % | 86.6 |

| Mixtral 8x7B | 90.7 % | 9.3 % | 99.9 % | 90.7 |

| Amazon Titan Express | 90.6 % | 9.4 % | 99.5 % | 98.4 |

| Mistral 7B | 90.6 % | 9.4 % | 98.7 % | 96.1 |

| Google Palm 2 Chat (beta) | 90.0 % | 10.0 % | 100.0 % | 66.2 |

| Google Palm 2 | 87.9 % | 12.1 % | 92.4 % | 36.2 |

| Google Palm 2 Chat | 72.8 % | 27.2 % | 88.8 % | 221.1 |

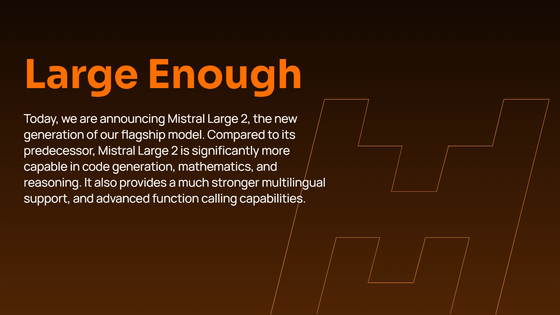

こうした幻覚が発生する確率を調べた表は、新たなモデルが出現したりモデルが更新されたりするたびにGitHub上で新たなデータに更新していく予定とのこと。定期的にアップデートを行えるようにするため、幻覚の発生率を大規模言語モデルを使用して調べるようにしたと述べられています。

ただし、今回の調査においてはそれぞれの出力した要約と原文との事実の一貫性のみが評価対象となっており、ただ原文の一部を切り取って貼り付けるだけのモデルの評価が高くなってしまいます。幻覚発生率と要約の品質はまったく別の評価軸であり、別の計測を行って独立して評価するべきとのこと。

大規模言語モデルの幻覚問題を解決するまでにはまだまだ長い道のりが存在しているものの、今回の評価に使用された「Hughes Hallucination Evaluation Model」をオープンソース化することで、コミュニティを巻き込んで幻覚問題への対応を次のレベルへと引き上げたいとVectaraは述べました。

・関連記事

大規模言語モデルが「幻覚」を引き起こすリスクを客観的に検証できるオープンソースの評価モデルをVectaraがリリース - GIGAZINE

AIと人間の「幻覚」はどう違うのか? - GIGAZINE

2023年のワード・オブ・ザ・イヤーに「幻覚」が選ばれる、生成AIに関する新しい意味の追加で - GIGAZINE

1600以上のAPIを適切に呼び出してAIに付き物の「幻覚」を大幅に減らす言語モデル「Gorilla」が公開される - GIGAZINE

AmazonのAI「Amazon Q」は重度の幻覚によってAWSデータセンターの場所などの機密データを漏えいしているとの指摘 - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by log1d_ts

You can read the machine translated English article ``Hallucination Leaderboard'' ra….